HPE가 AI 데이터센터 백엔드 네트워크의 해법으로 '오픈 이더넷'을 제시했다. 인피니밴드 대비 성능·비용·구축 유연성에서 더 높은 효율을 보이는 만큼 TCO(총소유비용)를 절반가량 낮출 수 있다고 주장했다.

김현준 HPE 이사는 11일 서울 신라호텔에서 열린 'ACC 2025' 행사에서 AI 워크로드를 위한 고성능 네트워크 구축 전략을 소개하며 AI 백엔드 패브릭의 핵심 기술 방향이 '오픈 이더넷'이라는 점을 강조했다.

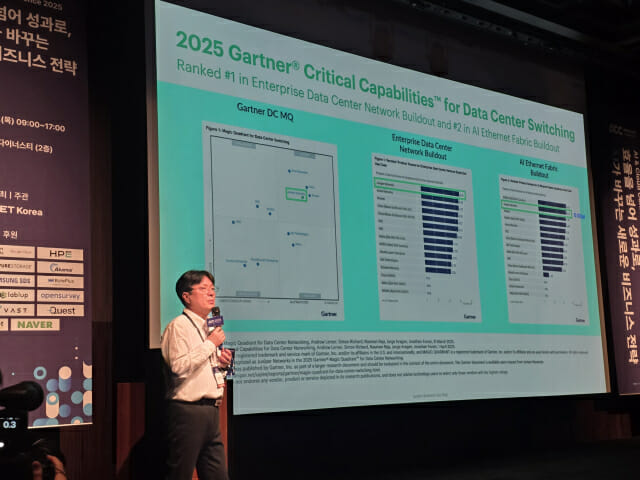

그는 HPE와 주니퍼의 합병 이후 강화된 데이터센터 포트폴리오를 기반으로 "AI 인프라의 중심이 빠르게 이더넷으로 이동하고 있다"고 말했다.

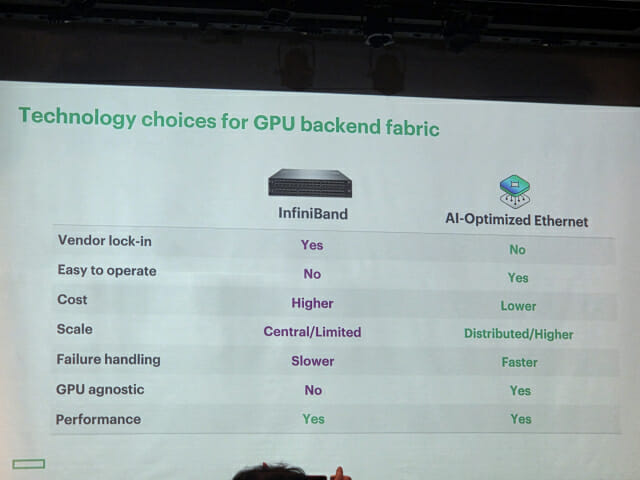

김 이사는 이날 발표에서 AI 백엔드 네트워크 기술 선택에서 가장 많이 제기되는 '인피니밴드(InfiniBand) vs 이더넷(Ethernet)' 논쟁을 정면으로 다뤘다.

그는 "그래픽처리장치(GPU) 간 통신을 어떻게 처리하느냐가 핵심"이라며 "이제는 이더넷이 성능·비용·구축 유연성 모두에서 현실적인 선택지로 자리 잡았다"고 말했다.

특히 TCO 측면에서 이더넷이 약 절반 수준으로 비용 효율을 확보할 수 있다는 점을 강조하며 "개방형 생태계를 기반으로 여러 벤더와 조합이 가능하다는 점 역시 큰 장점"이라고 덧붙였다.

AI 트래픽 특성은 이더넷 최적화 필요성을 뒷받침한다. 김 이사는 AI 트래픽을 "소수의 거대 플로우가 오가는 구조"라고 설명하며, 이 흐름을 안정적으로 처리하려면 패킷 로스를 사실상 0에 가깝게 줄여야 한다고 말했다.

또 그는 "원격 직접 메모리 접근(RDMA) 기반 AI 트래픽은 0.1% 수준의 로스만 발생해도 성능이 급격히 떨어진다"며 혼잡 제어(DCQCN)와 로드밸런싱 알고리즘의 중요성을 강조했다.

HPE는 이를 위해 명시적 혼잡 알림(ECN)·우선순위 기반 흐름 제어(PFC) 기반 혼잡 제어와 정적 부하 분산(SLB)·동적 부하 분산(DLB)·글로벌 부하 분산(GLB)·반응형 부하 분산(RLB) 등 다양한 로드밸런싱 기술을 적용하고 있다고 설명했다.

김 이사는 "AI 패브릭의 목적은 전체 네트워크 용량을 균등하게 활용하면서 로스를 없애는 것"이라며 "DLB 기반 동적 로드밸런싱이 기존 동일 비용 다중 경로 라우팅(ECMP)보다 확실한 성능 우위를 보인다"고 말했다.

실제 테스트 결과도 공개됐다. HPE는 자체 테스트 랩에서 AI 모델을 직접 학습시키며 네트워크 성능을 검증하고 있다.

관련기사

- 아카마이 "엣지로 '초저지연' AI 추론 시대 열 것"2025.12.11

- 바이트플러스 "AI, 이제 '사람' 아닌 'AI'가 통제"2025.12.11

- 삼성SDS "기업 발목 잡는 클라우드 장애…맞춤 DR로 대비해야"2025.12.11

- 알리바바클라우드 "영상 생성 AI '완 2.5', 경쟁사 모델보다 압도적 가성비"2025.12.11

김 이사는 "AI 인프라는 장비 스펙이 아니라 잡 완료 시간(JCT) 으로 성능을 판단해야 한다"며 "딥러닝 기반 추천 모델(DLRM)·양방향 인코더 기반 언어 모델(BERT) 등의 테스트에서 이더넷 패브릭이 안정적인 처리 시간을 보였다"고 강조했다.

또 그는 "AI 백엔드 네트워크는 더 이상 특정 기술에 종속된 구조가 아니라 개방형 이더넷 기반에서 고성능을 구현하는 방향으로 전환되고 있다"며 "HPE·주니퍼 통합 포트폴리오와 최신 스위치 제품군을 통해 고객이 향후 GPU 세대 변화까지 대응할 수 있도록 지원하겠다"고 밝혔다.