"인공지능(AI) 시대에 메모리는 기존 천편일률적인 구조를 벗어나, 각 기능에 맞춘 메모리를 최적의 방식으로 조합하는 것이 중요해지고 있다. 이 과정에서 커스텀 고대역폭메모리(HBM), 컴퓨트익스프레스링크(CXL), 고대역폭플래시(HBF) 등이 기회를 맞게 될 것이다."

박경 SK하이닉스 담당은 4일 오전 서울 코엑스에서 열린 'SK AI 서밋 2025'에서 회사의 메모리 사업 전략에 대해 이같이 밝혔다.

메모리, 향후 기능별로 분업화…최적의 조합 만들어야

이날 'AI 서비스 인프라의 진화와 메모리의 역할'을 주제로 발표를 진행한 박 담당은 AI 인프라 투자 확대에 따른 메모리 시장의 높은 성장세를 강조했다.

발표된 자료에 따르면, 글로벌 AI 데이터센터 시장 규모는 올해 2천560억 달러에서 2030년 8천230억 달러로 연평균 26% 증가할 것으로 예상된다. 이에 따라 D램은 서버 및 HBM(고대역폭메모리)를 중심으로, 낸드는 eSSD(기업용 SSD)를 중심으로 수요가 크게 늘어날 전망이다.

또한 AI 경쟁의 축이 기존의 학습에서 추론으로 이동하면서, 요구되는 메모리의 양도 급격히 증가하는 추세다.

추론 과정에서 KV(키-값) 캐시가 매 요청마다 생성되고 누적되면서, 메모리 용량과 대역폭을 상당 부분 소모하기 때문이다. KV 캐시는 키-값 구조로 데이터를 저장하는 캐시 시스템이다. 이전 연산 결과를 재활용해 추론 속도를 높이는 데 활용된다.

박 담당은 "AI 추론에서는 주어진 문장에 포함된 토큰 수와 사용자의 수에 따라 KV 캐시가 급증하는 것이 변수"라며 "이 KV 캐시로 촉발되는 메모리 요구량을 어떻게 잘 대응하느냐가 추론 시대에서 가장 중요한 화두가 될 것"이라고 설명했다.

때문에 SK하이닉스는 전체 시스템 내에서 가용되는 메모리의 성능 및 용량, 구성 방식이 AI 추론의 효율을 결정짓는 요소가 될 것으로 보고 있다. 특히 기존에는 메모리가 일반화된 계측 구조를 갖췄다면, 향후에는 기능별로 분업화된 메모리를 최적화된 구조로 조합하는 것이 핵심이 될 것으로 내다봤다.

'풀 스택 AI 메모리' 전략…커스텀 HBM·HBF 등 두각

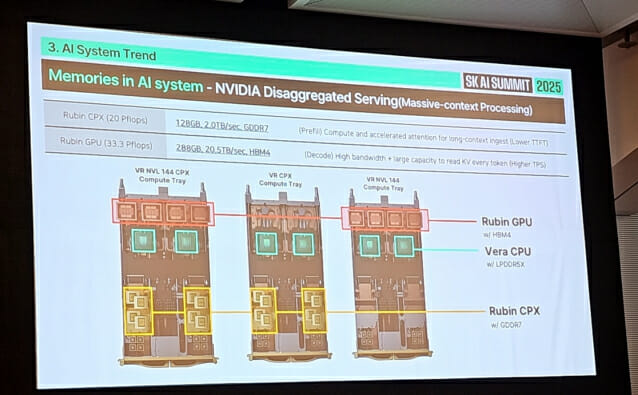

대표적인 사례가 엔비디아의 칩이다. 엔비디아는 루빈(Rubin) GPU에는 HBM4를, 베라(Vera) CPU에는 LPDDR5X(저전력 D램)를, 루빈 CPX(AI 추론에서 문맥 처리에 특화된 전용 가속기)에는 GDDR7(그래픽 D램)을 채용해 하나의 시스템을 구성하고 있다.

박 담당은 "예전에는 x86 CPU에 D램과 낸드를 붙이는 천편일률적인 메모리 구조가 지배적이었으나, 이제는 기능별로 메모리를 배치해야 하는 조합의 시대로 바뀌고 있다"며 "이 상황에서 메모리 공급사는 단순히 메모리 용량을 더 많이 제공하는 것이 아닌, 고객사 칩 성능에 따라 가장 효율적인 메모리 조합을 제시할 수 있어야 한다"고 강조했다.

관련기사

- SK하이닉스, 3개 분기 연속 D램 매출액 1위…HBM 효과2025.10.29

- 11.3조원 쏜 SK하이닉스, 내년도 HBM·D램·낸드 모두 '훈풍'2025.10.29

- AI 슈퍼사이클 왔다!...SK하이닉스 "D램·낸드까지 솔드아웃"2025.10.29

- HBM '수익 방어' 성공한 SK하이닉스 "내년도 공급 타이트"2025.10.29

이에 SK하이닉스는 '풀 스택 AI 메모리 크리에이터'라는 개념으로 AI 메모리 제품군을 적극 확장하고 있다. HBM4E부터 커스텀 HBM 공급을 준비 중이며, 기존 D램을 고객사 요구에 맞춰 더 세분화된 제품으로 개발하고 있다.

낸드 역시 초고성능과 대역폭, 초고용량 등 세 가지 방향에 맞춰 맞춤형 제품을 개발 중이다. 샌디스크와 협업해 개발 중인 HBF가 대표적인 사례다. HBF는 D램을 수직으로 여러 개 적층하는 HBM(고대역폭메모리)와 유사하게, 낸드를 여러 층 적층해 메모리 대역폭을 끌어올린 차세대 메모리다.