20년 전 스마트폰이 처음 등장하고 나서 지금까지 우리 일상의 많은 부분은 모바일 중심으로 바뀌었습니다. 이제는 인공지능(AI)이 우리 일상의 거의 모든 순간을 바꾸고 있습니다. 하지만 중요한 질문을 던지지 않을 수 없습니다.

"누구를 위한 AI인가, 어떤 목적을 향해 사용하는가?"

특히 디지털 환경에서 자주 배제되는 장애인이나 고령자 같은 정보약자들에게 AI는 과연 ‘실질적 수혜를 주는가, 아니면 또 다른 장벽을 만드는가’를 따져볼 필요가 있습니다.

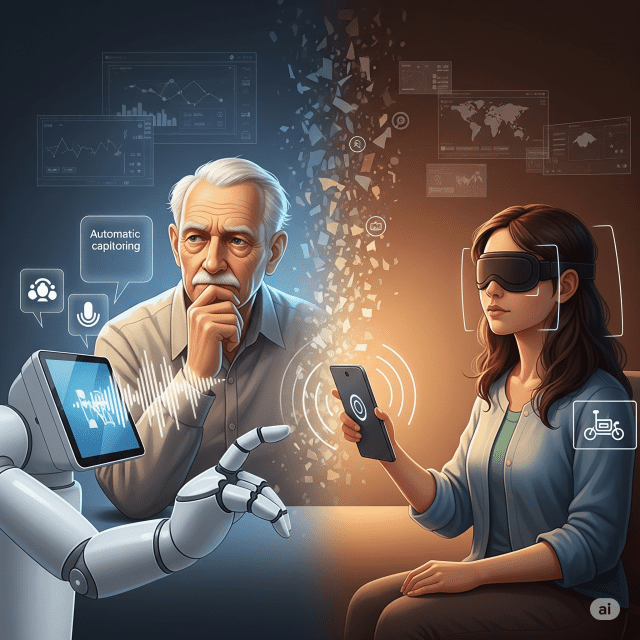

AI 기반의 자동 자막, 이미지 설명, 음성 인식 기술 등은 분명 장애인의 정보 접근성을 넓혀왔습니다. 예컨대 마이크로소프트가 개발한 시잉 AI(Seeing AI)는 사진 속 텍스트, 물건, 사람의 표정을 음성으로 설명하며, 시각장애인에게 ‘시각적 환경’을 구체적으로 전달합니다. 또한 비마이아이즈(Be My Eyes) 앱은 AI뿐 아니라 실시간 사람의 도움도 연계해, GPT4를 활용한 ‘Be My AI’를 통해 메뉴 설명, 물건 인식 등 다양한 지원을 제공하고 있습니다.

하지만 AI는 단순히 정보 접근성을 넓히기만 하는 것이 아닙니다. 실제로 정보취약계층은 접근성과 디지털 리터러시, 언어·문화·세대 차이 등 기존 정보격차를 오히려 확장하는 경향도 보입니다. 예컨대 세계인 중 영어 화자가 훨씬 많은 AI 모델이 이를 기반으로 한 기능들을 제공하면, 비영어권 사용자는 같은 성능을 기대하기 어렵습니다.

스탠퍼드 HAI 연구에 따르면 챗GPT 등 대부분 AI 모델은 영어권 사용자에게 최적화되어 있으며, 약 50억 명에 달하는 비영어권 사용자들에게는 성능이 현저히 낮습니다. 또한 유럽연합(EU) 연구는 고령자가 의료 AI에 접근할 경우, 인터넷 접속이나 디지털 기기 활용 능력 부족으로 인해 동일한 서비스임에도 불구하고 진단율과 치료 기회에서 불균형이 발생할 수 있다고 지적합니다.

이처럼 AI는 언어권, 소득, 지역, 교육 수준에 따라 적용성과 이해력의 격차가 심화되는 'AI 정보격차' 문제를 내포하고 있습니다. 그래서 저는 AI 기술이 실질적인 포용과 신뢰의 도구로 자리 잡기 위해, 세 가지 전략이 병행되어야 한다고 믿습니다.

첫째, 학습 데이터의 인권 중심 확보가 필요합니다.

AI가 실제 사회에서 안전하고 정확하게 작동하려면, 장애인·고령자 등 디지털 약자의 데이터가 충분히 반영되어야 합니다. 예컨대 비마이아이즈(Be My Eyes)와 힐튼(Hilton)의 협업은 호텔 사용자 행동을 실시간 피드백으로 AI에 반영하는 대표 사례입니다. 코넬 테크(Cornell Tech)와 구글의 공동 연구에서는 시각장애인이 오류 장면에 대한 직접 라벨링을 통해 데이터 품질을 개선하기도 했습니다. 이러한 참여형 데이터 수집은 AI의 정확도를 높이고, 약자에 맞는 안전망 역할을 강화합니다.

둘째, AI 개발 과정에 현장 참여형 설계 거버넌스(PID)가 반드시 포함되어야 합니다.

기술은 단순히 기능을 제공하는 것이 아니라, 설계 초기부터 장애인과 고령자 등의 사용자 실제 요구를 반영해야 비로소 ‘사람 중심’이 됩니다. 예컨대 소수자 커뮤니티 ‘퀴어인AI(Queer in AI)’ 프로젝트나 네덜란드의 오스월드연구소(Oswald Labs)는 현장 인터뷰와 워크숍을 통해 사용자의 문화·인지·신체 특성을 서비스 설계에 반영해왔습니다. 특히 고령자 인터페이스 테스트에서 “큰 글씨, 낮은 안내 속도” 등 단순한 요구가 실제 지원 정책에 반영되며, 고령층의 정서적 포용력까지 강화한 사례는 주목할 만합니다.

셋째, AI 서비스에는 투명성과 검증체계가 필수입니다.

AI 오류는 언제든 발생하며, 이때 중요한 것은 ‘누가, 어떻게, 언제, 어떤 오류를 검증하고 수정하느냐’입니다. 마이크로소프트의 애저(Azure)는 ‘Correction’ 기능을 통해 사용자가 실시간 오류를 수정할 수 있도록 했고, 비마이아이즈(Be My Eyes)는 사용자·자원봉사자 피드백을 기록해 모델 개선에 반영하고 있습니다. 이러한 시스템은 기술에 대한 신뢰 구축, 장기간 사용 유도, 서비스 질 향상에 필수적입니다.

이러한 세 가지 전략은 또 유엔교육과학문화기구(UNESCO), 경제협력개발기구(OECD), 유럽연합(EU) 등 국제기구들이 제정한 인권 중심 AI 윤리·가이드라인과도 맥을 같이합니다. OECD는 '포용적 성장, 투명성, 책무성(Inclusive growth, transparency, accountability)'을 기본 원칙으로 삼고 있으며, UNESCO 역시 '인권 존중, 투명성, 책임성'을 강조하는 윤리 권고를 채택했습니다.

관련기사

- AI 인재에 1천억 베팅한 메타…음성 스타트업 '플레이AI' 품었다2025.07.13

- [사스포칼립스 위기 ㊤] AI가 SaaS 산업 흔드나…"경쟁 구도 재편으로 봐야"2026.02.26

- 밀가루·설탕값 내렸는데…오리온·농심·롯데 조용 왜?2026.02.26

- 20년간 761대→13만대...미니, 올해 한정판 11종 출시2026.02.26

이 세 가지가 유기적으로 결합하면, AI는 단순히 '기술이 약자에게 제공하는 도구'를 넘어서, 실질적, 사회적 의미를 통해 인권을 보장하는 기술 수단이 될 수 있을 것이라 생각합니다. 모바일과 AI와 같은 기술의 발전은 전반적인 사회환경과 사람들의 삶에 편리함과 효율을 가져도 주었습니다. 다만, 정보취약계층은 기술의 발전에 따른 상대적인 정보격차로 인해 삶의 격차는 더욱 심화되는 현상을 초래하고 있습니다. 우리는 이러한 정보격차가 심화되지 않도록 책임있게 노력해야 합니다.

다음 주에는 'AI로 만든 격차, AI로 매울 수 있을까?'라는 제목으로, AI가 기존 격차를 어떻게 증폭시키는지 경고하고, 향후 해결 방안을 환기하는 내용을 다루며, 문제와 대응을 함께 조명할 예정입니다.

*본 칼럼 내용은 본지 편집방향과 다를 수 있습니다.