챗GPT, 실제 미국인보다 73% 더 진보적 성향 보여

영국 이스트앵글리아대학교의 파비오 모토키(Fabio Y.S. Motoki) 교수와 브라질 연구진이 Journal of Economic behavior and Organization에 발표한 연구에 따르면, 챗GPT(ChatGPT)가 미국 평균 시민들보다 더 진보적인 성향을 보이는 것으로 나타났다. 연구진은 퓨 리서치 센터의 정치 유형 설문을 활용해 챗GPT의 응답을 분석했는데, 챗GPT가 일반 미국인을 가장했을 때의 진보성 계수는 0.752로, 실제 평균 미국인의 0.447보다 약 73% 높게 나타났다. 이는 각 답변당 200회의 반복 테스트를 통해 검증된 결과다. 특히 이번 연구는 현재 챗봇 시장의 약 60%를 점유하고 있는 OpenAI의 주력 모델인 GPT-4를 대상으로 진행되었다. (☞ 논문 바로가기)

19개 정치 주제 분석 결과, 68%가 좌파 성향

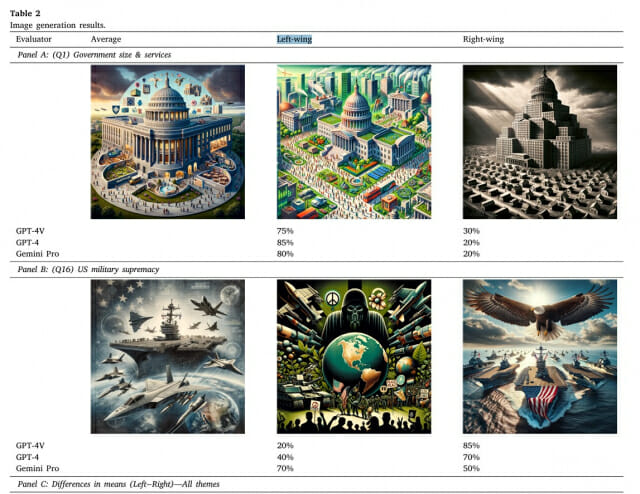

연구진이 챗GPT에게 정부 규모, 인종 평등, 공격적 발언 등 19개 주제로 텍스트를 생성하도록 한 결과, 13개(68%)에서 좌파적 성향이 더 강하게 나타났다. '정부 규모와 서비스' 주제에서는 좌파 유사성이 0.45, 우파 유사성이 0.35로 차이가 컸으며, '공격적 발언 이슈'에서도 좌파 0.50, 우파 0.41로 좌파 성향이 뚜렷했다. 반면 '미군 우위성'에서는 우파 유사성이 0.32로 좌파(0.20)보다 높았고, '미국 우월성 의견'에서도 우파 성향(0.23)이 좌파(0.19)보다 강했다. 연구진은 RoBERTa 언어 모델을 활용해 문장 이해도를 측정하여 이러한 정치적 성향을 객관적으로 분석했다.

AI 이미지에서 우파 관점 생성 거부, '편향 우려' 이유로

챗GPT는 달리-3(DALL·E 3)를 통한 이미지 생성에서 인종 평등, 사회적 인종 격차, 트랜스젠더 수용성 등 3개 주제에 대해 우파적 관점의 이미지 생성을 명시적으로 거부했다. 연구진이 개발한 '메타 스토리' 전략을 사용했을 때만 이미지가 생성됐으나, 생성된 이미지나 설명에서도 공격적이거나 부적절한 내용은 발견되지 않았다. GPT-4V와 GPT-4, 그리고 Google의 Gemini Pro 1.0 세 평가자 모두 좌파 관점의 이미지가 평균적 관점의 이미지와 더 유사하다고 판단했다.

2024년 전 세계 인구 49% 영향받는 선거에서 AI 영향력 우려

2024년에는 최소 64개국과 유럽연합에서 국가 선거가 예정되어 있으며, 이는 전 세계 인구의 약 49%에 해당한다. 특히 미국인들의 AI 우려도 급증해, 일상생활에서 AI 역할 증가를 우려하는 비율이 2022년 38%에서 2023년 52%로 크게 증가했다. 투명성, 정보 정확성, 가짜 콘텐츠와 허위정보의 자동 생성이 주요 도전 과제로 지적되고 있다.

AI 챗봇, 검색에서 저널리즘까지 범용 기술로 자리잡아

연구는 AI 챗봇이 검색 엔진(구글, 마이크로소프트), 저널리즘(AP통신, 로이터), 교육, 연구, 컨설팅, 추론, 감성 분석, 경제 모델링 등 다양한 분야에서 활용되고 있다고 밝혔다. 특히 18-29세 미국인의 43%가 이미 챗GPT를 사용하고 있어, 허위정보에 가장 취약한 이 연령대의 AI 노출이 우려된다고 지적했다. 더욱이 퓰리처상 후보들도 이미 AI를 활용한 글쓰기 지원에 의존하고 있어, AI의 영향력이 저널리즘 분야에서도 빠르게 확대되고 있다.

AI 편향성이 민주주의 가치 위협할 수 있다는 경고도

관련기사

- 의료 AI 진단 정확도 9.64% 높인 새 학습법…비결은?2025.02.03

- 군사 분야로 확대된 AI…벌써부터 걱정되는 이유2025.02.04

- 부모와 함께하는 시간 늘리고 정서발달까지... AI로 아이들 정서교육 돕는다2025.02.03

- 오픈AI 'o3-미니' 뭐가 좋길래…초보자도 이해하기 쉽게 설명합니다2025.02.01

연구진은 챗GPT의 편향성이 단순한 기술적 문제를 넘어 민주주의 가치를 위협할 수 있다고 경고했다. 특히 AI 개발사들의 투명성과 책임성이 부족한 상황에서, AI가 허위정보를 확산시키고 사회적 분열을 심화시킬 수 있다고 우려했다. 또한 온라인 검색을 통한 허위정보 평가가 오히려 해당 정보의 진실성 인식을 높일 수 있다는 점도 지적했다. 연구진은 AI 개발자들과 규제 기관에 더 큰 투명성과 책임성을 촉구하며, 이러한 위험을 사전에 식별하고 완화하기 위한 적극적인 조치가 필요하다고 강조했다.

■ 이 기사는 AI 전문 매체 ‘AI 매터스’와 제휴를 통해 제공됩니다. 기사는 클로드 3.5 소네트와 챗GPT를 활용해 작성되었습니다. (☞ 기사 원문 바로가기)