인공지능(AI) 윤리 산업이 성장하고 있다. 챗봇, 면접 등에 AI가 확대 적용되면서 윤리 중요성에 대한 인식이 커져서다. 이에 따라 AI 기술에 편향성 등 윤리적 판별 모델을 내놓는 기업까지 등장했다.

국내 기업 중에선 AI 스타트업 튜닙이 대표 사례다. 지난 8월 윤리성을 판별하는 모델 ‘세인패트릭’을 개발했다. API 형태다. 주로 AI 언어모델에서 발생할 수 있는 편향성, 비윤리성 등을 사전에 파악해 차단하고 지속적으로 관리한다.

텍스트에서 나타나는 욕설, 성희롱, 개인정보, 범죄 조장 등에 나타나는 혐오 표현 정도를 11단계로 나눠 이런 표현이 나오면 자동으로 탐지해 피해를 막는다. 개발자나 사용자가 이를 재사용하지 않도록 순화 표현까지 제시한다.

튜닙은 이를 지난달 생성AI 기업 뤼튼테크놀로지스에 유료로 공급했다. 뤼튼테크놀로지스는 해당 모델을 기반으로 이메일, 광고 문구, 블로그 포스팅 등 텍스트 콘텐츠를 작성해주는 서비스 '뤼튼'에 적용했다. 사용자가 부적절한 정보 입력하는 행위를 차단해 생성되는 콘텐츠 윤리성을 확보하겠다는 방침이다. 정확한 가격은 비공개다.

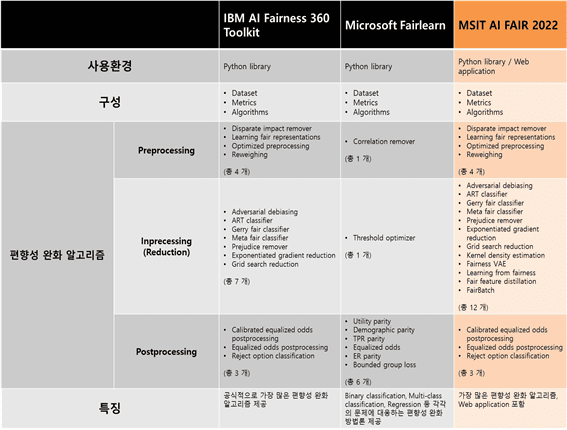

해외에서는 이미 AI 알고리즘 공정성을 판별하는 툴이 존재한다. IBM의 'AIF360', 마이크로소프트의 '페어런' 등이 대표 사례다. 영국 웨스트민스터대 피에르 베르데잼 AI 윤리학 박사는 "AI 알고리즘이 주관성을 결정하는 순간 데이터 학습 과정에 생기는 편향성을 인간 건강검진처럼 주기적으로 해야 한다"고 밝혔다. 베르데잼 박사는 "지난해까지는 AI 판별 도구 '개발'에 집중하겠지만, 올해부터는 이를 산업에 직접 적용하는 '실행' 단계로 접어들었다"고 말했다.

해외와 달리 국내에서는 기업뿐 아니라 연구소까지 나서서 AI 윤리 산업에 앞장서고 있다. 지난해 한국과학기술원(KAIST) 공정성연구센터도 AI 모델 공정성을 판별하는 툴 'MAF 2022'를 내놨다. 측정 대상인 AI가 데이터 학습 과정에서 편향된 데이터를 학습했는지, 사용 분야에 적합한 결과값을 내는지 분석하는 역할을 한다.

KAIST 측은 해당 도구가 기존 IBM, 마이크로소프트 등 해외에서 만든 공정성 툴보다 더 뛰어나다는 입장이다. MAF 2022는 편향성 검증을 알고리즘 19 종류로 측정하지만, IBM은 14개, 마이크로소프트는 8개에 그쳐서다. 해외 툴보다 2~3배 더 많은 장치로 AI 모델 데이터 편향성을 측정, 교정할 수 있는 셈이다.

정부도 AI 윤리 확보에 힘을 쏟고 있다. 과학기술정보통신부와 정보통신정책연구원은 AI 윤리 문제를 자체적으로 검사할 수 있는 'AI 윤리 자율점검표’와 ‘신뢰할 수 있는 AI 개발안내서’를 지난 8월 발표했다.

관련기사

- '대화형 AI챗봇' 챗GPT, 유료 모델 나오나2023.01.12

- 쓰리아이, AI 모션 트래킹 '피보맥스'로 글로벌 공략2023.01.11

- IBS 연구 역량 모은다...KAIST-포스텍 캠퍼스 준공2023.01.11

- KAIST, 초세대 협업연구실 추가 선정2023.01.11

특히 과기정통부는 지난달 체코에서 열린 제1회 유네스코 AI윤리 글로벌 포럼에서 해당 내용을 발표하며 국내외적으로 AI 윤리와 이를 산업에 활용해야 한다고 장려한 바 있다.

과기정통부 엄열 AI기반정책관은 “앞으로 한국도 AI 윤리 정책을 착실히 이행해 국제사회가 신뢰 가능한 AI를 만들어 나갈 수 있도록 그 역할과 책임을 다하겠다”고 강조했다.