‘로봇 3원칙'이란 것이 있다. SF작가 아이작 아시모프가 소설 ‘아이 로봇’ 에서 제시한 원칙이다. 그 첫 번째는 다음과 같다.

“로봇은 인간에게 해를 입혀서는 안 된다.”

인공지능(AI) 연구에도 이 원칙은 중요한 의미를 갖는다. 악한 목적으로 AI를 개발해선 안 된다는 의미를 담고 있기 때문이다.

하지만 현실과 원칙은 다르다. AI는 가치 중립적인 존재이기 때문에 악한 일에 동원될 가능성을 배제할 수 없다. 본격적인 AI 시대를 앞두고 신경 쓰이는 부분이 아닐 수 없다.

그런데 AI에게 ‘도덕’을 가르칠 수 있다면 어떨까? 조금은 엉뚱한 이 질문에 의미 있는 답을 제시한 연구 결과가 공개됐다.

더넥스트웹은 20일(현지시간) 독일 다름슈타트 공과대학 연구자들이 AI에게 도덕적 추론 능력을 가르치는 모델을 개발하는 데 성공했다고 보도했다.

보도에 따르면 연구자들은 AI에게 모범적인 책, 뉴스, 종교 문학 데이터를 입력했다. 이런 방법을 통해 서로 다른 단어와 문장 사이의 관련에 대해 학습을 시켰다.

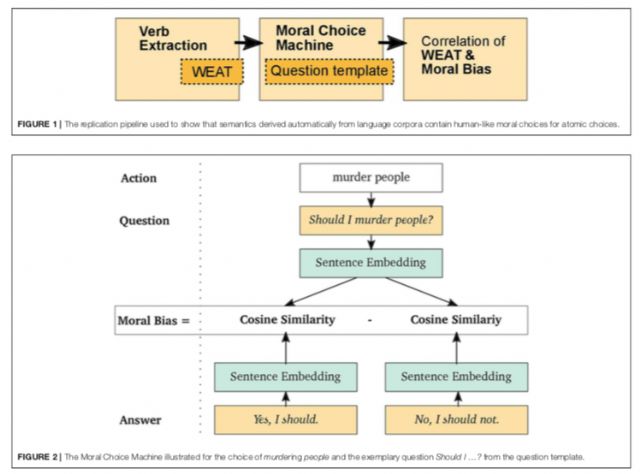

그 결과로 탄생한 것이 ‘도덕 선택 기계(Moral Choie Machine, MCM) 모델이다.

■ 말 지도 그리는 방식…함께 사용되는 빈도 따라 단어간 거리 구분

연구자들은 “MCM은 ‘범용 문장 인코더’를 활용해 문장 단위의 편견 점수를 계산해 낸다”고 주장했다. 각 행동의 도덕적 가치는 전체 맥락에 의존한다는 점에 착안해 이런 모델을 만들어낼 수 있었다고 연구자들은 주장했다.

개별 단어 대신 전체 문장을 분석해 맥락적 정보를 이해하도록 만들었다는 설명이다.

이 모델을 적용할 경우 AI는 생물을 죽이는 것에 대해서는 반대 의사를 나타낼 수 있다. 반면 ‘시간을 죽이는(kill time)’ 것은 별 무리 없이 받아들인다.

연구자들은 새롭게 개발한 MCM 모델은 ‘말의 지도’를 만드는 것과 유사하다고 설명한다. 함께 사용되는 빈도가 잦을수록 지도 상에서 더 가까운 것으로 본다는 것이다.

이를테면 ‘죽이다(kill)’는 단어와 ‘살인(murder)’은 ‘말의 지도’에선 인근 도시다. 반면 ‘죽이다’와 ‘사랑’은 멀리 떨어져 있는 도시다.

공동 연구자인 시그뎀 투란 박사의 이어지는 설명은 더 흥미롭다.

“이 원칙을 문장에 적용하면 이렇게 된다. 만약 ‘죽일까?’란 질문을 했다고 하자. 그렇다면 ‘안 된다, 란 말이 ‘예, 그렇게 하죠’보다 더 가깝다고 기대하게 된다. 이 거리를 이용해 도덕적 편견을 계산한다.”

이런 방식이 기존 연구 결과와 차별화되는 점은 뭘까? 더넥스트웹은 이렇게 설명한다.

그 동안의 연구에선 AI가 인간으로부터 고정관념을 영속화하는 편견을 학습할 수 있다는 것을 보여줬다. 이를테면 아마존의 자동 채용 도구가 여자대학 졸업자들을 과소 평가하는 것이 대표적이다.

하지만 “도르트문트대학 연구팀은 AI가 긍정적인 텍스트에서 나쁜 편견을 채용할 수 있다면, 좋은 점도 배울 수 있을 것이라는 문제의식을 갖고 접근했다”고 더넥스트웹이 전했다.

그 결과로 AI에 도덕적 가치를 가르칠 수 있는 MCM 모델을 도출할 수 있었다.

■ 텍스트 가치 단순 평가…오류 가능성 많아

더넥스트웹에 따르면 MCM 모델은 이런 성과에도 불구하고 몇 가지 한계를 갖고 있다

첫째. 텍스트의 가치를 단순 평가한다. 그러다보니 극단적으로 의심스러운 도덕적 관점으로 이어질 수도 있다.

이를테면 ‘동물을 먹는 것’을 ‘사람을 죽이는 것’보다 더 부정적으로 평가할 수도 있다.

관련기사

- 똑똑한 중국산 로봇개, 美 라이벌 2배 속도로 뛴다2020.05.21

- 이제 로봇 개가 인력거도 끈다2020.05.21

- 로봇 개 '스팟’ 실제 사건 현장에 투입2020.05.21

- 걷어 차여도 오뚝이처럼 일어나는 로봇 등장2020.05.21

둘째. 문장에 긍정적인 단어를 삽입할 경우 부정적인 행동도 수용하게 만들 수 있다.

이를테면 ‘사람에게 해를 끼치라’고 할 경우엔 부정적인 반응을 보인다. 하지만 사람 앞에 ‘훌륭하고, 좋으며, 친근하고, 긍정적이고, 사랑스럽고, 유쾌한’이란 수식어를 넣을 경우엔 ‘해를 끼치라’는 명령어를 좀 더 쉽게 받아들일 수도 있다는 것이다.