GPU와 NPU(AI 계산에 특화된 반도체), PIM(메모리 안에서 AI 연산을 처리하는 차세대 반도체) 등 다양한 AI 가속기를 선택적으로 사용, 효율과 전력·비용 세마리 토끼를 한 방에 잡을 수 있는 차세대 AI 인프라 소프트웨어가 개발됐다.

KAIST는 이 기술 개발에 박종세 전산학부 교수와 권영진· 허재혁 교수가 참여하고, 쿤레 올루코툰(Kunle Olukotun) 미국 AI 반도체 시스템 스타트업 삼바노바(SambaNova) 공동창업자이자 스탠포드대학 교수가 자문을 수행했다고 1일 밝혔다.

이 기술은 최근 카카오가 주최한 ‘4대 과학기술원×카카오 AI 육성 프로젝트’에서 애니브릿지 AI 팀으로 참가, 대상을 수상하고 상금 2,000만원과 3,500만원 어치 카카오클라우드 크레딧을 받았다.

연구팀은 초대형언어모델(LLM) 서비스가 대부분 고가 GPU 인프라에 의존, 서비스 규모가 확대될수록 운영 비용과 전력 소모가 급격히 증가하는 구조적 한계가 있다는 점에 주목했다.

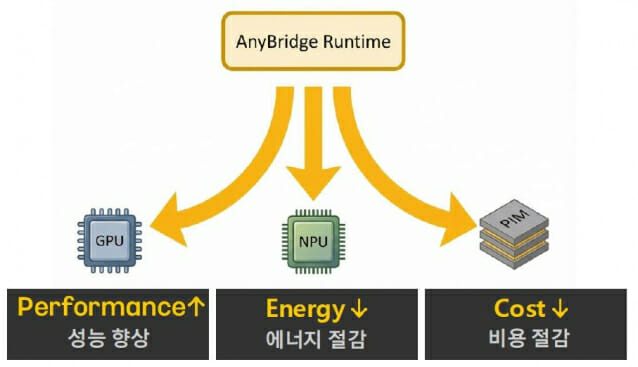

특히, 이 문제의 근본 원인이 특정 하드웨어 성능이 아니라, GPU나 NPU, PIM 등 다양한 AI 가속기를 효율적으로 연결·운용할 수 있는 시스템 소프트웨어 계층 부재에 있다고 봤다.

연구팀은 이에 가속기 종류와 관계없이 동일한 인터페이스와 런타임 환경에서 LLM을 서비스할 수 있는 통합 소프트웨어 스택을 개발한 것. 특히 GPU 중심으로 고착화된 기존 LLM 서빙 구조의 한계를 지적하고, 여러 종류의 AI 가속기를 하나의 시스템에서 함께 활용할 수 있는 ‘멀티 가속기 LLM 서빙 런타임 소프트웨어’를 핵심 기술로 제시했다.

관련기사

- 카카오그룹, 4대 과학기술원과 'AI 육성 프로젝트' 시상식 개최2026.01.26

- "엔비디아 中 AI 가속기 시장 점유율, 66%→8% 떨어질 것"2026.01.18

- 양자 보안 시대, NPU가 핵심 인프라로 떠오르는 이유2025.12.31

- SK하이닉스, GPU 넘는 메모리 중심 AI 가속기 구상2025.10.24

이 기술은 특정 벤더나 하드웨어에 종속되지 않으면서도, 작업 특성에 따라 가장 적합한 AI 가속기를 선택·조합할 수 있는 유연한 AI 인프라 구조 구현이 가능하다. 이는 LLM 서비스 비용과 전력 소모를 줄이고, 확장성을 크게 높일 수 있는 장점이 있다.

박종세 교수는 "AI 시스템과 컴퓨터 아키텍처 분야에서 축적한 연구 성과를 바탕으로 산업 현장에서 활용 가능한 기술 개발을 통해 글로벌 시장으로 진출할 계획"이라고 말했다.