단 2장의 사진으로 인공지능(AI)을 학습시킬 수 있는 방법을 제시한 국내 기업의 기술이 국제 권위 학회에서 인정받았다.

그동안 적게는 수천, 수만장의 데이터가 필요했던 AI 학습과정의 비용을 낮출 뿐 아니라 데이터가 부족한 분야도 보다 원할하게 AI를 도입할 수 있을 것으로 주목 받고 있다.

스누아이랩은 24일 이미지 노이즈 합성 모델 연구 논문이 '전미인공지능학회 2026(AAAI 2026)'에 채택됐다고 밝혔다.

AAAI는 미국인공지능협회가 주관하는 학회 시리즈로, 전 세계 연구자와 기업이 최신 AI 연구 성과를 경쟁하는 대표 무대 중 하나로 꼽힌다. 이번 AAAI 2026에 2만3천680건의 논문이 제출됐고 4천167건이 채택돼 채택 비중이 약 18% 수준다.

단 2장의 이미지로 데이터 부족 해결…해법은 AI 합성

채택 논문 제목은 '가이드노이즈: 일반화된 노이즈 합성을 위한 단일 쌍 가이드 확산 모델(GuidNoise: Single-Pair Guided Diffusion for Generalized Noise Synthesis)'이다.

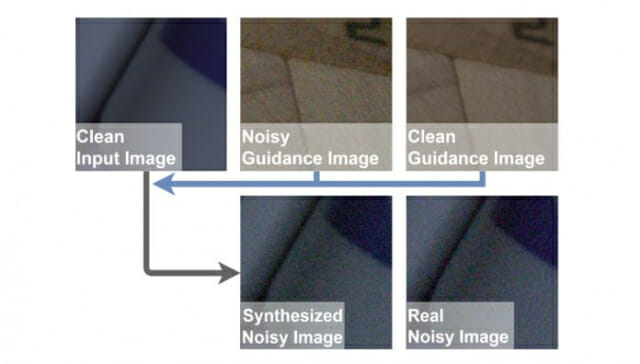

핵심은 원본이미지 한장과 노이즈가 발생한 사진 1장만 있으면 카메라와 촬영 환경에서 나타나는 불필요한 요소(노이즈)를 더한 학습용 데이터를 만들 수 있다는 점이다. 이를 통해 데이터가 부족해도 데이터를 만들어 학습을 진행할 수 있는 구조다.

현실 세계에서 발생하는 노이즈는 생각보다 복잡하다. 카메라 센서 특성, 이미지 신호 처리(ISP) 과정, ISO 감도, 조명, 촬영 온도 같은 조건이 겹치면서 노이즈의 형태가 달라진다. 같은 카메라라도 설정이 바뀌면 패턴이 바뀐다.

예를 들어 CCTV나 스마트폰 카메라로 촬영한 영상은 밤이 되거나 조명이 어두우면 충분한 빛을 확보하지 못해 화질 저하가 발생한다. 또한 태양광, LED 조명 등 광원의 종류나 피사체의 재질에 따라 카메라 센서가 받아들이는 노이즈의 패턴과 색감은 미세하게 달라진다.

스누아이랩이 제시한 기술은 원본 이미지의 반사광이나 명암을 인식해 그 환경에 맞는 현실적인 노이즈를 입혀줌으로써 AI가 다양한 조명 환경에 적응하도록 돕는다.

그동안 이를 해결위해 현장에서 수천 장의 사진을 일일이 찍어 데이터를 모아야 했다. 비용과 시간이 막대하게 드는 만큼 제조 라인, 보안 관제, 의료 영상처럼 촬영 조건이 다양하고 미세한 영역일수록 비용과 시간이 부담이 됐다.

스누아이랩은 논문을 통해 자체 개발한 가이드노이즈 기술을 이용해 원본사진과 노이즈가 있는 사진 한쌍으로 해당 환경의 노이즈 특성을 완벽하게 분석해낼 수 있음을 증명했다.

반면 가이드노이즈는 확산모델 기반 생성 방식을 활용해, 메타데이터 없이도 '가이드 이미지 1쌍'에서 노이즈의 질감과 분포를 읽어내고 이를 다른 이미지로 전이하는 방식을 제안했다. 이 기술을 적용하면 AI는 2장의 샘플을 가이드 삼아 특정 카메라로 찍은 것과 동일한 품질의 노이즈 이미지를 무한대로 합성해낼 수 있다는 구상이다.

논문은 이를 위해 두 가지 기술을 결합했다. 먼저 가이드 인식 변형 기술(GAFM)은 가이드 이미지에서 추출한 노이즈 특징을 신경망 내부의 특징 맵 수준에서 조정해 깨끗한 입력 이미지에 자연스럽게 반영한다.

노이즈 인식 정제 손실 기술은 합성 결과가 실제 노이즈의 분포와 더 가깝게 맞춰지도록 학습 목표를 추가한다. 연구지는 결과가 최종 이미지에 수렴하는 마지막 단계에서 정제를 집중해 미세한 차이를 줄이려 했다고 밝혔다.

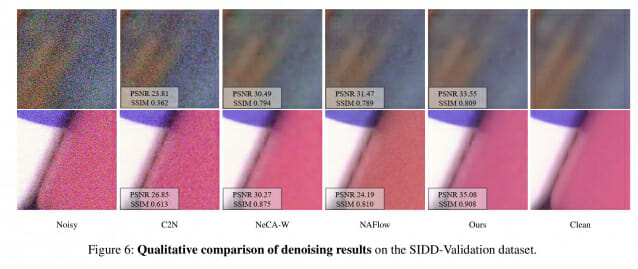

진짜 같은 노이즈 생성…기존 모델 대비 15% 이상 우위

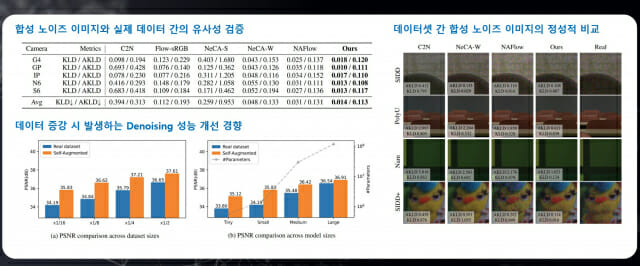

연구팀은 가이드노이즈의 성능을 검증하기 위해 세계적으로 통용되는 노이즈 데이터셋인 SIDD 등을 활용해 비교 실험을 진행했다. 논문에 따르면 노이즈의 실제 유사도를 나타내는 지표인 ‘평균 쿨백-라이블러 발산(AKLD)’ 평가에서 가이드노이즈는 0.113을 기록했다.

이 평가는 수치가 낮을수록 생성된 노이즈가 실제와 유사함을 뜻한다. 가이드노이즈의 기록은 기존 최신 기술인 NA플로우가 기록한 0.131나 NeCA의 0.133 대비 오차를 약 15% 이상 줄인 수치로 현존하는 모델 중 가장 실제에 가까운 노이즈를 생성한 것이다.

특히 합성된 데이터의 실용성이 돋보였다. 연구팀이 합성 데이터만으로 학습시킨 AI 모델의 이미지 복원 성능(PSNR)은 37.07 데시벨(dB)**을 기록했다. 이는 실제 데이터를 사용해 학습했을 때의 성능인 37.16dB과 비교해 차이가 0.1dB 미만에 불과한 수준이다.

값비싼 실제 데이터 수집 없이 합성 데이터만으로도 상용화 수준의 고성능 AI를 개발할 수 있다는 가능성을 수치로 증명한 것이다.

스누아이랩 측은 이 기술이 데이터 확보가 어려운 산업 현장에서 빛을 발할 것으로 전망했다. 데이터 반출이 힘든 반도체 제조 공장이나 개인정보 문제로 데이터 수집이 까다로운 의료 영상 분야에서도 소량의 샘플만으로 고성능 AI 모델을 구축할 수 있을 것이란 예상이다.

관련기사

- 스누아이랩, AI 기반 산업안전 솔루션으로 현장 혁신 나서2025.10.02

- 스누아이랩, 현장 학습형 AI 서비스 출시… 실시간 데이터로 성능 향상2025.02.03

- 스누아이랩,오토케어마스터 베타버전 출시2024.01.18

- UNIST, SCI 논문 피인용서 9년째 국내 1위…세계 순위는 203위2025.11.03

더불어 비전 AI의 전처리, 복원 품질을 끌어올리는 기반 기술이 될 수 있다고 보고 있다. 노이즈가 줄면 객체 탐지, 결함 분류, 문자인식(OCR), 이상 징후 탐지 등 후속 모델의 정확도도 함께 개선될 여지가 크다는 분석이다.

유명호 스누아이랩 대표는 "이번 AAAI 논문 채택은 스누아이랩의 연구 성과가 글로벌 무대에서 경쟁력을 인정받은 결과"라며 "현실 제약이 큰 산업 현장에서 저비용, 고효율로 성능을 끌어올릴 수 있는 비전 AI 기술을 지속적으로 고도화하겠다"고 밝혔다.