유튜브에 올라온 도시 여행 영상이 자율주행 로봇의 ‘교과서’가 될 수 있을까. 최근 캘리포니아대 로스앤젤레스(UCLA) 연구진이 공개한 UrbanVerse(어반버스) 프로젝트는 그 질문에 구체적인 답을 제시했다. 연구팀은 단 한 줄의 지도 데이터 없이, 오직 온라인의 시티 투어 영상만으로 AI가 도시 환경을 학습하고 실제 도심을 주행하는 데 성공했다고 밝혔다.

이는 AI가 현실을 직접 체험하지 않고도, 세상을 이해하고 이동할 수 있는지를 실험한 최초의 연구 중 하나다.

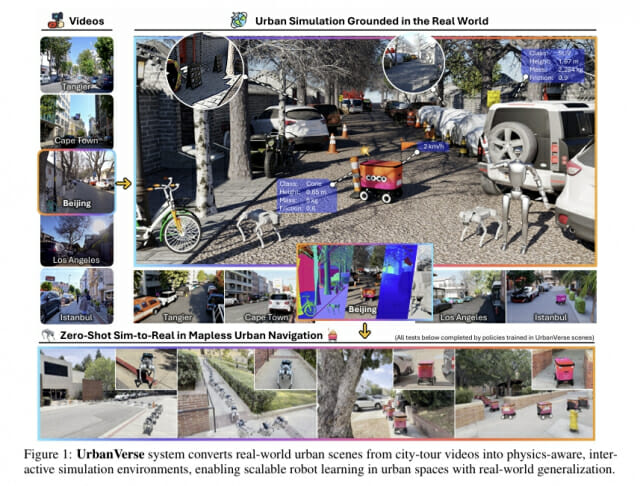

이미지 출처: UrbanVerse: Scaling Urban Simulation by Watching City-Tour Videos

현실 영상을 학습해 ‘가상 도시’를 구축한 AI

UrbanVerse의 출발점은 단순하다. “현실 영상을 데이터로 바꾸면, AI가 그 안에서 스스로 도시를 배울 수 있지 않을까?” 연구팀은 유튜브에 공개된 도시 여행 영상(City-Tour Video)을 수집해, AI가 거리 풍경을 분석하고 이를 3D 시뮬레이션 환경으로 변환하는 시스템을 구축했다.

이 시스템은 건물, 차량, 도로, 신호등 같은 도시 구성 요소를 자동으로 인식하고, 이를 물리적으로 상호작용 가능한 가상 공간으로 재구성한다. 즉, 영상 속 거리 하나가 AI에게는 실제 도로처럼 ‘움직이고 반응하는 훈련장’이 된다.

연구팀은 이렇게 생성된 도시 환경을 이용해 로봇 자율주행 모델을 훈련시켰다. AI는 지도나 GPS 없이 오직 카메라 입력과 목표 방향만으로 길을 찾아야 했다. 훈련 과정에서 로봇은 수천 개의 도시 장면을 통과하며, 보도와 차도의 경계, 장애물의 형태, 보행자의 움직임 패턴을 스스로 파악했다.

이미지 출처: UrbanVerse: Scaling Urban Simulation by Watching City-Tour Videos

“AI가 실제 도시를 주행했다” — 실험 결과로 증명된 자율 학습 능력

어반버스의 AI는 단순히 가상 공간에서 학습하는 데 그치지 않았다. 연구진은 이 모델을 실제 거리로 옮겨 검증했다. 테스트는 COCO 배달 로봇과 Unitree Go2 사족보행 로봇 두 가지 플랫폼에서 진행됐다. 각 로봇은 한 번도 방문한 적 없는 도심 구간을 주행해야 했다.

그 결과는 인상적이다. 훈련된 정책은 현실 도심에서 89.7%의 주행 성공률을 기록했으며, 로봇은 337m의 실험 구간을 단 두 번의 인간 개입만으로 완주했다.

즉, AI가 유튜브 영상을 통해 학습한 ‘가상 경험’만으로 현실 공간을 주행한 것이다. 이 실험은 로봇이 직접 도로를 주행하며 데이터를 수집하지 않아도, 영상 기반 학습만으로 충분히 ‘도시 감각’을 익힐 수 있음을 보여준다.

연구팀은 이러한 성과를 “Zero-Shot Sim-to-Real Transfer”라 정의했다. 이는 별도의 현실 데이터나 추가 학습 없이, 가상 환경에서 배운 행동 정책을 현실 환경에 즉시 적용하는 것을 의미한다.

GPT-4.1과 IsaacSim, 그리고 도시를 재현한 AI 인프라

어반버스의 기술적 구조는 크게 세 부분으로 나뉜다.

UrbanVerse-100K: GPT-4.1(OpenAI)을 활용해 구축한 10만 개 이상의 도시 객체 데이터베이스. 각 객체는 질량, 마찰, 재질 등 33가지 물리 속성을 포함한다.

UrbanVerse-Gen: 유튜브 영상을 분석해 건물·도로·보행자·하늘 등을 분리하고, 이를 3D 시뮬레이션 형태로 배치하는 자동 생성 파이프라인.

IsaacSim: NVIDIA의 물리 기반 시뮬레이션 엔진으로, AI가 실제 중력, 조명, 충돌 등을 경험할 수 있는 ‘가상 도시의 물리 법칙’을 구현한다.

이 과정을 거치면, AI는 현실 도시를 직접 보지 않고도 “도시가 어떻게 작동하는가”를 경험적으로 학습한다. 그 결과, 로봇은 현실의 도심에서도 신호등·보행자·차량의 움직임을 유사하게 예측하고 대응할 수 있다.

자율주행의 학습 방식이 바뀐다

UrbanVerse의 등장은 자율주행 AI의 학습 구조 자체를 뒤흔드는 변화다. 그동안 자율주행 연구는 수백만 km에 달하는 실제 도로 주행 데이터를 기반으로 이루어졌다. 그러나 현실 데이터 수집은 비용이 높고, 안전 문제도 뒤따른다.

어반버스는 이 문제를 근본적으로 재정의했다. AI가 이미 존재하는 대규모 영상 데이터를 이용해 ‘가상 도심에서 훈련하고, 현실로 전이되는’ 방식을 입증한 것이다. 이는 향후 자율주행, 물류 로봇, 드론 내비게이션 등 현실 데이터를 대체하는 시뮬레이션 학습 체계의 전환점이 될 수 있다.

특이 이 연구는 생성형 AI가 물리 세계를 학습의 영역으로 확장한 결정적 사례라고 할 수 있다. 언어와 이미지 생성에 머물던 생성형 AI가, 이제는 현실의 복잡한 구조와 행동을 스스로 학습하는 단계에 들어섰다는 의미다.

FAQ (※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q. 유튜브 영상만으로 자율주행이 가능하다는 말이 사실인가요?

A. UrbanVerse는 실제 주행 데이터를 사용하지 않았습니다. 유튜브 영상을 분석해 만든 가상 환경에서만 학습했지만, 훈련된 로봇은 실제 도심에서 89.7%의 성공률로 주행에 성공했습니다.

Q. 어떻게 현실과 가상을 연결할 수 있었나요?

A. AI는 GPT-4.1을 이용해 영상 속 사물의 물리 속성을 추론하고, NVIDIA IsaacSim 엔진을 통해 이를 실제 물리 환경처럼 구현했습니다. 이 덕분에 가상 학습이 현실 행동으로 자연스럽게 전이됐습니다.

Q. 이 기술이 자율주행 산업에 주는 의미는 무엇인가요?

관련기사

- [Q&AI] ‘죽고 싶지만 떡볶이는 먹고 싶어’ 작가 별세… 누구?2025.10.17

- 14초 걸리던 암 치료 계산, AI가 0.03초 만에 해낸다2025.10.16

- 수백만 명이 쓰는데 AI는 모른다...2천개 언어 '디지털 실종' 충격2025.10.15

- 챗GPT, 왜 이럴까…"무례하게 물어봐야 정답률 높다"2025.10.15

A. 현실 도로 주행 데이터에 의존하던 기존 학습 구조가 영상 기반의 시뮬레이션 학습으로 대체될 가능성을 제시합니다. 이는 자율주행 개발 비용과 위험을 동시에 줄일 수 있는 방향입니다.

■ 이 기사는 AI 전문 매체 ‘AI 매터스’와 제휴를 통해 제공됩니다. 기사는 클로드 3.5 소네트와 챗GPT를 활용해 작성되었습니다. (☞ 기사 원문 바로가기)