국내 연구진이 STA·네이버·업스테이지·셀렉트스타·KT·LG AI연구원 등과 협의체를 구성해 AI 안전성 및 신뢰성 분야 국제 표준 개발에 착수했다.

한국전자통신연구원(ETRI)은 AI 시스템의 위험을 미리 찾아내는‘AI 레드팀 테스팅’표준과 소비자가 AI의 신뢰 수준을 쉽게 이해할 수 있는‘신뢰성 사실 라벨(TFL)’표준을 국제표준화기구(ISO/IEC)에 제안하고, 본격적인 개발에 착수했다고 20일 밝혔다.

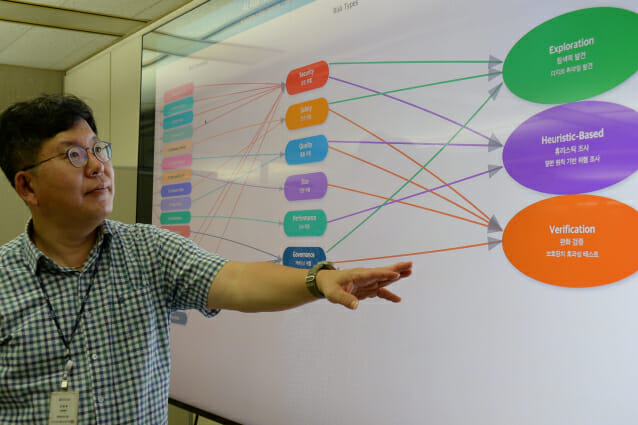

‘AI 레드팀 테스팅’은 AI 시스템이 얼마나 안전한지를 공격적으로 탐색하며 테스트하는 방법이다. 예를 들어, 생성형 AI가 잘못된 정보를 내놓거나, 사용자 보호장치를 피해 악용되는 상황을 미리 찾아내는 것이다.

ETRI는 이 분야의 국제표준인 'ISO/IEC 42119-7' 에디터 역할을 맡아, 의료·금융·국방 등 다양한 분야에 공통으로 적용할 수 있는 국제 공통 시험 절차와 방법을 만들고 있다.

연구팀은 서울아산병원과 의료 전용 레드팀 평가 방법론도 함께 개발 중이다. 첨단 AI 기술을 적용한 디지털의료제품에 대한 레드팀 시험 체계도 만들고 실증 테스팅을 진행할 예정이다.

STA·네이버·업스테이지·셀렉트스타·KT·LG AI연구원 등 주요 기업들과 협의체를 구성, AI 레드팀 국제표준화 협력도 진행 중이다.

‘신뢰성 사실 라벨(Trustworthiness Fact Labels, TFL)’은 AI 시스템이 얼마나 신뢰할 수 있는지를 한눈에 알 수 있도록 시각화해주는 것으로, 마치 식품의 영양성분표처럼 소비자에게 투명한 정보를 제공한다.

ETRI는 현재 'ISO/IEC 42117' 시리즈 표준 개발을 주도하고 있다. 이 표준은 기업이 스스로 정보를 제공하거나, 제3의 기관이 검증·인증하는 다양한 방식으로 운영될 수 있다.

향후에는 AI의 탄소배출량(탄소발자국) 같은 ESG 요소도 반영하는 방안까지 검토 중이다.

이 표준은 인공지능 활용 조직에 대한 국제 인증 표준으로 사용하고 있는‘AI 경영시스템 표준(ISO/IEC 42001)’과도 연계, 개발된 제품 및 서비스가 얼마나 신뢰할 수 있는지 입증할 수 있는 틀로 자리매김하도록 할 계획이다.

관련기사

- 과학 논문 매일 한 편씩 쓰는 AI모델 만든다2025.08.13

- IITP, 지역 AI·ICT 인재 양성위해 현장 소통 나선다2025.06.13

- [현장] IT서비스 학술대회, AI 혁신 방향 제시…KIST·포스코DX·삼성SDS 한자리에2025.05.14

- 中 정부 주도 딥시크에 놀란 과기정통부, AI 연구 인프라 확대 '총력'2025.03.24

정보통신기획평가원 김 욱 PM은 "이 두 표준은 정부가 추진하는‘소버린 AI(주권형 AI)’,‘AI G3 도약’전략과도 맞닿아 있다"며 “이번 국제표준 선도는 AI 규범을 선도하는 국가로 가는 분기점”이라고 평가했다.

ETRI 이승윤 표준연구본부장도 “AI 레드팀 테스팅과 신뢰성 라벨은 미국, EU 등 각국 AI 규제정책에 포함된 핵심 기술 요소"라며 "대한민국이 소버린 AI뿐 아니라 소버린 AI 안전 기술을 이끄는 중심이 되도록 할 것"이라고 밝혔다.