SK하이닉스가 인공지능(AI)를 지원하는 차세대 메모리 고대역폭메모리(HBM), CXL(컴퓨트익스프레스링크), PIM(프로세싱 인 메모리) 시장에서 기술 선도를 이어갈 계획이다. 내년에 HBM4 개발을 본격화하고, 하반기에는 CXL 메모리를 상용한다는 목표다.

HBM 1위, 기술 초격차로 경쟁 우위 지킨다

SK하이닉스는 21일 자사 뉴스룸를 통해 올해 HBM 경쟁 우위를 굳건히 지켰다고 자평하며 내년에도 경쟁우위는 지속된다고 자신감을 내비쳤다.

김왕수 SK하이닉스 GSM(Global Sales&Marketing) 팀장은 "내년에는 HBM3E의 양산·판매가 계획되어 있어, 자사의 시장 지배력이 다시 한번 극대화할 것"이라며 "후속 제품인 HBM4 개발도 본격화할 예정이기에 내년은 SK하이닉스의 HBM이 새로운 국면을 맞는 한 해가 될 것이다"고 말했다.

김 팀장은 이어 "AI 산업이 빠르게 성장하는 만큼 HBM 제품도 현재 AI 서버에 국한된 것을 뛰어넘어 AI와 관련된 모든 영역으로 확장하겠다"며 "이 시점에 자사의 HBM 제품은 AI 산업을 이끄는 매우 중요한 역할을 맡을 것"이라고 전망을 밝혔다.

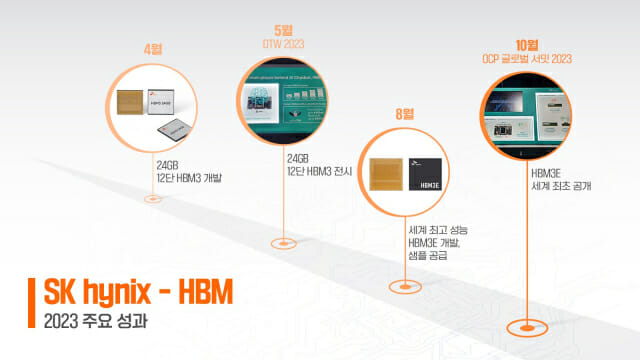

HBM은 여러 개 D램을 수직으로 연결해 기존 D램보다 데이터 처리 속도를 대폭 끌어올린 고성능 제품이다. HBM은 1세대(HBM)·2세대(HBM2)·3세대(HBM2E)에 이어 4세대(HBM3) 제품이 공급되고 있으며, 내년부터 5세대(HBM3E) 양산을 앞두고 있다.

SK하이닉스는 선행 기술을 도입해 성능 향상에도 앞장서고 있다고 밝혔다. 회사는 2013년 세계 최초로 TSV((Through Silicon Via) 기술로 D램 칩 사이사이에 수천 개의 데이터 이동 통로를 만들어 고용량, 고대역폭 HBM을 구현했다. 이후 MR-MUF(Mass Reflow-Molded UnderFill) 기술로 D램 칩을 쌓고 포장해 생산성을 높였다. 최근에는 어드밴스드 MR-MUF까지 개발해, 더 작은 크기로 고용량 패키지를 만들고 열방출 성능도 개선했다.

이 같은 기술력을 바탕으로 지난 8월 세계 최고 성능의 HBM3E 개발을 마치고 고객사에 샘플을 공급했다. 이 제품의 핀당 처리 속도는 초당 9.2Gb 이상이며, 데이터 처리량은 초당 1.15TB(테라바이트)에 달한다. 용량은 12단 HBM3와 같지만, 층수는 8단으로 더 적다. 12단 개발 시 더 많은 용량을 확보할 수 있는 셈이다.

CXL 상용화 초읽기…AiMX 성능 높인다

SK하이닉스는 내년에 CXL 상용화에도 주력할 방침이다.

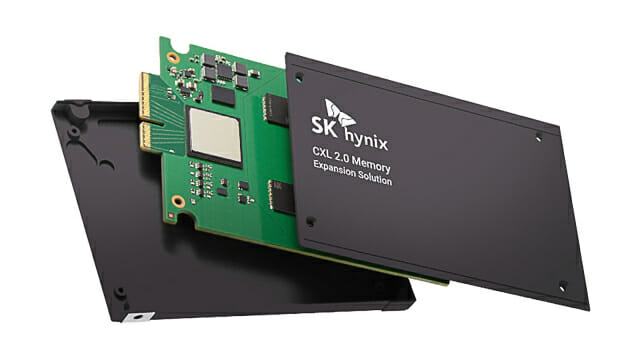

CXL은 PCIe 기반으로 CPU, GPU, 가속기 등 여러 장치와 메모리를 연결하는 통합 인터페이스 기술이다. PCIe 기반의 CXL을 사용하면 모듈을 추가하는 방식으로 메모리 용량과 대역폭을 크게 늘릴 수 있다. CMS 2.0은 CXL 메모리에 연산 기능을 통합한 솔루션이다. SK하이닉스는 지난해 10월 CMS 2.0개발에 성공한 이후, 올해 기술을 고도화해 델 테크놀로지스 월드 2023, 슈퍼컴퓨팅 2023 등에서 성능을 시연했다.

최원하 SK하이닉스 GSM TL은 "96GB와 128GB 제품을 중심으로 내년 상반기에는 고객 인증을 마치고, 하반기에 상용화할 예정"이라며 "CXL 2.0 메모리 확장 솔루션을 적용한 고객은 DDR5만 탑재한 기존 시스템 대비 최대 50% 대역폭 향상을 기대할 수 있고, 용량 확장도 최대 50~100%까지 가능하다"고 설명했다.

관련기사

- 시총 2위 굳힌 SK하이닉스...내년 흑자전환 전망2023.12.18

- S&P, SK하이닉스 신용등급 '안정적' 상향…"AI 반도체로 실적 개선"2023.12.15

- SK하이닉스, AI-HBM 인재 선점 나섰다...경력 채용 기준 완화2023.12.08

- 삼성전자, 차세대 메모리 'CXL 컨트롤러' 자체 개발 총력2023.12.14

아울러 SK하이닉스는 본격적인 AiMX 상용화를 위해 내년에 성능과 활용 범위를 더욱 높일 계획이다. PIM은 메모리 반도체에 연산 기능을 더한 지능형 메모리 반도체다. AiMX는 GDDR6-AiM 여러 개를 연결해 성능을 높인 가속기 카드로, GPU 대신 AI 연산에 활용할 수 있다.

권용기 솔루션개발 팀장은 "SK하이닉스의 AiM은 AI 추론 분야에서의 핵심인 가격 경쟁력을 갖춘 유일한 AI 솔루션"이라며 "데이터센터부터 온디바이스(On-Device) AI를 탑재한 모바일까지 AI 추론 영역에서 폭넓게 활용될 전망이다"고 말했다. 이어 "수백 GB급 거대언어모델(LLM)에 대응하기 위해 고용량 AiMX 시제품을 내놓고, OPT 13B보다 더욱 큰 규모의 LLM을 시연하겠다"고 계획을 밝혔다.