마이크로소프트가 플랫폼과 개발언어 등 제약없이 인공지능(AI), 기계학습(ML) 앱을 만들고 배포할 수 있는 환경을 제시했다.

마이크로소프트는 23일(현지시각) 개최한 연례 개발자 컨퍼런스 '마이크로소프트 빌드 2023'에서 크로스 플랫폼 기계학습(ML) 가속엔진 ‘ONNX 런타임’과 장치 최적화 도구 ‘올리브(Olive)’를 공개했다.

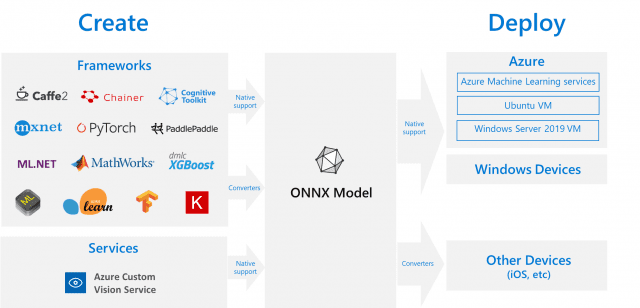

ONNX 런타임은 윈도를 비롯해 안드로이드, iOS, 리눅스, 웹 등 다양한 플랫폼에서 CPU, GPU, NPU 등 원하는 컴퓨팅 자원을 이용해 함께 기계학습 모델을 공동 개발할 수 있는 추론엔진이다.

파이썬, C++, 자바 등 프로그래밍 언어와 API를 비롯해 X64와 ARM 아키텍쳐도 자유롭게 선택해 구성할 수 있다.

또한 기계학습을 위해 파이토치, 텐서플로, 허깅페이스 등의 프레임워크를 선택할 수 있으며 배포 과정에서는 개발에 사용한 플랫폼 외에 사물인터넷(IoT) 및 에지에도 배포할 수 있다.

기업이나 조직에서 다수의 개발자가 함께 대규모 ML모델을 개발할 때 특정 플랫폼 등의 제약을 없애 보다 빠르고 자유로운 개발을 지원한다. 또한 업무 환경 구축을 위한 추가 비용 지출을 줄이고 모바일 디바이스 등을 활용해 장소 등의 제약에 구애받지 않고 업무를 수행할 수 있다.

마이크로소프트 측은 ONNX 런타임 도입으로 추론 속도는 최대 17배 AI학습 속도는 최대 1.4배 향상됐다고 밝혔다.

함께 공개한 올리브는 여러 OS 및 장치를 활용한 기계학습 과정에서 원활한 통신과 협업이 이뤄질 수 있도록 하드웨어를 최적화한다. 각 하드웨어를 인식 후 학습 과정에서 가장 적합한 환경을 구축할 수 있도록 지원한다.

관련기사

- "개발자, 코파일럿 플러그인으로 돈 버는 시대 온다"2023.05.24

- 시민 개발자는 생성 AI로 더 강해진다2023.05.24

- MS, 윈도 코파일럿 공개…'생성 AI 사이드바 배치'2023.05.24

- 마이크로소프트 빌드2023 'D-1' 뭐가 나올까2023.05.23

ONNX 런타임은 클라우드나 로컬 환경에서 모두 활용할 수 있도록 동일한 API를 지원해 선택의 폭을 넓혔다.

마이크로소프트는 웹 브라우저 환경에서 추론 속도를 향상시키기 위해 ONNX 런타임 웹(ORT 웹)을 도입하고, 웹신경망(WebNN) 통합을 위해 파트너와 협력 중이라고 밝혔다. 더불어 ONNX 런타임의 활성화를 위해 전용 사이트를 구축하고 관련 정보 및 윈도 AI 애플리케이션 구축을 위한 정보를 공유한다.