"인공지능(AI)을 알고리즘 모델로만 국한해서 볼 게 아니라 전체적인 구조를 봐야 한다. 모델 관리 체계와 모델을 제어하는 방법, 학습 데이터에 대한 보안 문제 등 총체적인 관점에서 AI를 살펴야 한다. AI가 무엇을 하는지 이해하고, 문제 없는 과정을 거쳐 결과를 도출하는지 항상 모니터링할 수 있어야 한다."

최근 국내 기업이 개발한 AI 챗봇 '이루다'가 혐오 발언, 개인정보 유출 등 각종 문제를 일으켜 비판의 대상이 됐다. 이에 분야를 막론하고 AI를 적극 도입해온 국내 산업계에서도 비즈니스에 접목한 AI가 예상 못한 폐해를 일으킬지 모른다는 우려가 커지고 있다.

IBM 최고데이터책임자로서 AI·클라우드 전환 비즈니스를 총괄하는 세뜨 도브린 박사는 23일 진행된 화상 미디어 브리핑에서 이런 우려를 해소할 수 있는 방법론에 대해 이같이 설명했다.

도브린 박사는 전체적인 모델 구조에서 신뢰성과 투명성을 갖춘 AI를 '신뢰할 수 있는 AI'로 소개했다. 이는 ▲결과가 도출된 과정을 공개적으로 설명할 수 있고 ▲편향되거나 불공정한 답을 도출하지 않으며 ▲AI 채택 기업의 비즈니스와 철학을 이해하고 ▲무결성을 갖춘 데이터를 엄격하게 통제함으로써 제공되는 AI를 뜻한다.

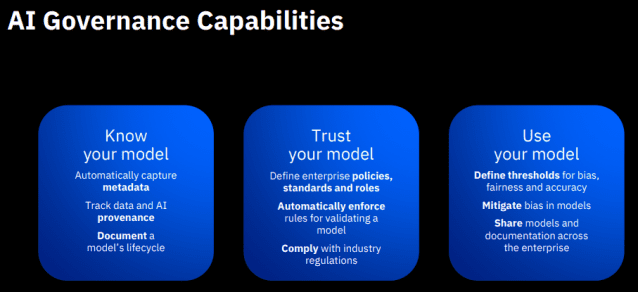

이런 AI를 구축하기 위한 조건으로 'AI 거버넌스 역량'을 제안했다. AI 거버넌스 역량은 AI의 모델을 만들고, 시장에 출시한 뒤 사후 관리하는 전체 과정에서 AI의 투명성과 신뢰성을 확보할 수 있는 조건들이다.

먼저 '모델 이해 역량'의 중요성을 강조했다. AI 메타데이터(데이터들을 정의하는 데이터)를 자동으로 캡쳐하고, AI가 결과 도출에 어떤 데이터를 사용했는지 추적할 수 있어야 한다는 것이다. 또 AI가 지속적으로 학습함에 따라 나타나는 AI 모델의 변화를 문서로 관리할 수 있어야 한다고 언급했다.

'모델의 신뢰성 확보 역량'도 필요하다고 봤다. 이는 AI를 사용하는 기업의 정책과 기준, 역할 등을 정의하고 AI 모델을 검증하기 위한 규칙들을 자동화된 방식으로 집행할 수 있어야 한다는 것을 뜻한다. 아울러 해당 산업계 규제도 준수할 수 있도록 모델을 구성해야 한다는 의미를 담고 있다.

'모델 사용 역량'은 AI 모델을 사용하는 동안 발생할 수 있는 불공정이나 편향, 편견 등을 정의한 뒤 이를 감지하고, 감지된 내용과 관련해 지속적으로 모델을 수정할 수 있어야 한다는 것을 뜻한다.

도브린 박사는 "편견, 편향에 대한 정의는 업계에 따라서 다양하게 갈릴 수 있다"며 "이런 내용들을 적절히 정의하고, 모델을 구축하는 과정에서 최소화한 뒤 실제 운영에 들어간 뒤에도 편향이 감지되면 실시간으로 이를 제거할 수 있어야 한다"고 조언했다.

이어 "이렇게 구축된 모델을 공유하고, 문서화해서 공개해 모델을 검증할 수 있어야 한다"고 덧붙엿다.

이같은 기준을 참고해 AI를 활용한 실 사례로 작년 서울시와 IBM이 공동 구축한 시민의견 수렴용 챗봇 서비스를 언급했다. 서비스 구축 과정에서 IBM의 대화형 AI 플랫폼 기술 '왓슨 어시스턴트'가 사용됐다.

관련기사

- 이루다가 던진 질문…AI가 배워야 할 윤리는?2021.02.02

- 혐오발언 AI를 수출할 수 있을까?...AI윤리, 선택아닌 필수2021.02.01

- AI 도입과 데이터는 중국이 세계 최고2021.02.06

- "인간과 공존 AI 위해선 완전히 새로운 접근 필요"2021.02.02

도브린 박사는 이 챗봇이 코로나19 이후 시민 생활상을 파악하는 데 사용됐다고 언급하면서, "FAQ 자동 추출 기술을 사용해 프로세스를 상당 부분 자동화했고, 자사 AI 편향 검증 기술 '오픈스케일'이 사용돼 챗봇 답변에 대한 배경을 이해할 수 있도록 했다"고 설명했다.

최고기술책임자(CTO)인 이지은 한국IBM 전무는 "최근 국내에선 고객이 AI 모델을 시범적으로 몇 개 도입하는 단계에 그치지 않고, 실제 업무에 활용하거나 비즈니스 프로세스를 자동화하는 과정에 도입하는 사례가 많이 나타나고 있다"며 "그러다 보니 AI의 윤리 및 편향성에 대한 고민도 실제 비즈니스 현장에서 AI를 운영하는 과정에서 고려하는 경우가 느는 상황"이라고 밝혔다.