구글이 인종에 따른 편견을 보인 인공지능(AI)에 대해 사과했다.

최근 독일 IT전문 매체인 알고리즘워치는 인종 차별적인 판단을 내린 AI 서비스에 대해 구글이 사과했다고 보도했다.

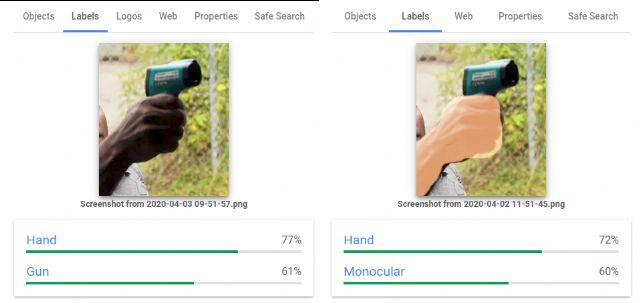

논란이 된 AI는 구글 비전AI다. 이미지를 분석해 어울리는 단어를 기록하는 데이터 라벨링에 쓰인다.

문제는 해당 AI가 피부색에 따라 비슷한 이미지임에도 다른 결과를 냈기 때문이다.

비전AI는 밝은 피부를 가진 사람이 체온계를 들고 있는 경우 그대로 체온계로 표시했다. 하지만 짙은 피부색의 손이 체온계를 들고 있는 경우는 총으로 라벨링했다.

또한 같은 이미지에서 짙은 피부색을 밝게 덧씌운 후 다시 분석한 결과 총으로 분류되지 않았다.

구글은 이러한 결과를 만든 AI의 알고리즘을 수정했으며 인종차별적인 결과로 인해 피해를 본 모든 사람들에게 죄송하다고 사과했다.

구글의 트레이시 프레이 제품전략 및 운영 담당이사는 “발생할 수 있는 피해에 대해 깊이 사과한다”며 “결과와 인종 차별과의 관련성을 중요하게 분석하고 있다”고 전했다.

AI가 편견을 가진 이유는 충분한 학습을 거치지 않은 것이 큰 것으로 나타났다. AI를 휴대용 온도계의 이미지가 거의 포함되지 않은 데이터 세트로 학습했기 때문에 총과 온도계를 명확하게 분류할 수 없었기 때문이다.

또한 학습 과정에서 데이터셋에 포함된 이미지 중 폭력을 묘사하는 장면에서 어두운 피부를 가진 사람이 자주 등장해 잘못학습을 했을 것이란 분석도 나오고 있다.

잘못된 학습으로 인한 AI의 실수가 발생하면서 일부에선 AI로 인해 무고한 피해자가 나올 수 있다는 지적도 나오고 있다.

관련기사

- 中 텐센트, AI 사랑 계속…"한달새 7개 기업 투자"2020.04.14

- AI로 청각장애인 목소리 찾아드립니다2020.04.14

- 美 샌디에이고대학, 코로나19 확진자 CT 데이터셋 공개2020.04.14

- 구글, 데이터 세트 검색 엔진 개발2020.04.14

뉴욕 대학교 AI 나우 인스티튜 데보라 라지 기술연구원은 “학교, 콘서트 홀, 아파트 단지 및 슈퍼마켓에서 AI 기반 무기 인식도구가 사용된다”며 “이러한 시스템은 대부분 비전AI와 비슷한 방식이라 쉽게 편견에 빠질 수 있다”며 일부 사람은 무해한 물체를 잡고 있어도 위험한 것으로 표시될 가능성이 높다고 지적했다.

트레이시 프레이 이사는 “공정성은 구글 핵심 AI 원칙 중 하나”라며 “기계 학습의 성공척도로서 공정성을 갖춘 기계 학습 개발에 진전을 다하겠다"고 강조했다.