페이스북이 지난 미국 대선 때와 같이 잘못된 뉴스가 퍼져 여론이 조작될 가능성이 있다는 사실을 인정하면서 이러한 조직적인 활동을 막기 위한 대응지침을 새롭게 공개했다. 핵심은 행동패턴을 파악해 잘못된 뉴스가 확대, 재생산되는 허리를 끊겠다는 것이다.

최근 페이스북은 '인포메이션 오퍼레이션과 페이스북(Information Operations and Facebook)'이라는 보고서를 통해 지난해 심각한 문제로 불거졌던 여론 조작 문제에 대한 자사의 구체적인 대응 전략을 공개했다.

이 회사는 "우리는 계정 해킹, 악성코드 및 스팸 유포, 금융사기 등 전통적인 위반행위에서부터 파악하기 힘들게 교묘한 방식으로 시민담론을 조작하고 사람들을 기만하려는 방식에 대해서까지 우리의 보안영역을 확장했어야 했다"고 밝혔다.

페이스북은 우선 관련 사안에 대해 '가짜 뉴스(Fake News)' 대신 '잘못된 뉴스(False News)'라는 표현을 쓰기로 결정했다. 가짜 뉴스가 패러디나 루머, 문화적인 요소, 어뷰징 등 너무 포괄적인 의미를 담고 있어 개선책을 마련하는데 혼선을 빚을 수 있다는 판단에서다.

또한 보고서에서 이 회사는 가짜 계정을 만들어 잘못된 뉴스 등을 활용해 왜곡된 정보를 뿌리고 왜곡된 여론을 확대, 재생산하려는 활동을 '인포메이션 오퍼레이션'이라고 정의했다. 정부 후원을 받거나 독립적으로 조직된 공격자들이 국내외 정치 상황을 조작해 전략적인 혹은 지정학적인 이익을 얻는 것을 목표로 하는 활동을 말한다.

미국 대선 과정에서 사실과 다른 잘못된 뉴스가 페이스북에 난무하면서 여론에 심각한 영향을 미쳤다는 의혹이 끊이지 않았다.

이와 관련 페이스북은 인포메이션 오퍼레이션을 수행하는 조직들이 크게 3단계를 통해 여론전을 폈다고 분석했다.

먼저 대상에 대한 데이터를 수집하는 작업이다. 대상으로부터 정보를 훔쳐내거나 비공개됐던 정보를 공개하는 방법으로 여론을 흔든다. 여기에 더해 잘못된 정보를 저널리스트들이나 외부 단체에 흘리거나 가짜 온라인 인물을 통해 유포하기도 한다. 그 뒤에는 이러한 잘못된 정보를 확대재생산하는 작업이다.

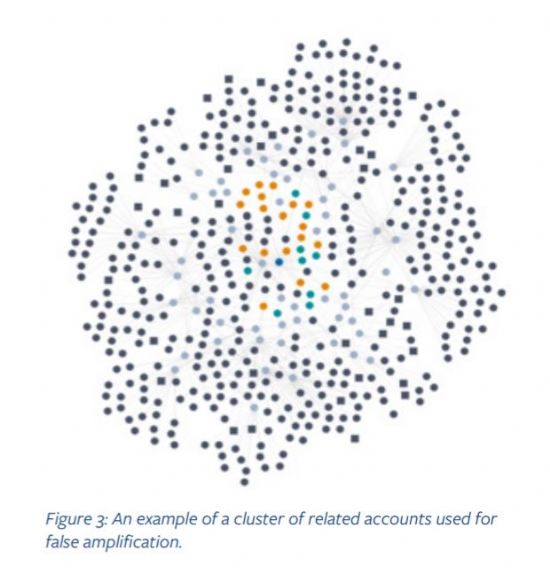

페이스북 입장에서 가장 집중적으로 모니터링하려는 지점은 잘못된 정보가 확산되는 과정이다. 보고서는 페이스북 계정을 대량으로 만들거나 잘못된 콘텐트를 빠르게 여러 곳에 퍼나르며, 댓글을 달고 '좋아요'를 누르며 가짜 그룹 페이지를 만들어 일반 사용자들을 끌어들인다고 설명했다.

관련기사

- 페북, '불펌' 영상 광고 수익 원작자에게 지급한다2017.04.30

- 페북, 가짜뉴스 막기 위해 ‘3자 사실확인’ 도입 추진2017.04.30

- 페이스북 다음 이정표 공개, VR-AR 생태계 잡을 것2017.04.30

- 美 페북에 살인장면 동영상 올라와 충격2017.04.30

페이스북은 분석 결과, 정치적인 이익을 얻으려는 인포메이션 오퍼레이션의 경우 일명 '소셜봇'이라 불리는 자동화된 툴을 악용하기보다는 사람이 직접 여론 조작 작업에 개입됐었다고 설명했다. 대상 국가에 대한 기본적인 정치 상황을 인식하고, 적절한 언어스킬을 구사했다.

이러한 잘못된 정보 확산을 막기 위해 페이스북은 콘텐트보다 해당 계정의 행동에 주목했다, 이를 위해 머신러닝 기술을 도입하는 등 방법으로 사용자들의 행동패턴을 파악하는데 주력했다. 같은 내용을 계속해서 올리거나 기존과 전혀 다른 성격을 가진 콘텐트를 대량으로 만들어 내는 경우가 그렇다. 실제로 우리나라와 비슷한 시기 최종 대통령 선거 결선투표를 앞두고 있는 프랑스에서는 이러한 방법으로 4월13일 기준 3만여개 가짜 페이스북 계정을 잡아냈다.