현재 정부가 추진 중인 '독자적 파운데이션 모델(이하 독파모)' 선정 과정에서 오픈소스를 활용한 기업 독자 모델 인정여부를 두고 잡음이 일고 있다. 사용한 오픈소스가 더이상 지원하지 않거나 라이선스를 변경할 경우 독자 모델로서 존립하기 어렵다는 지적 때문이다.

하지만 지난해 초 중국 인공지능(AI) 스타트업 '딥시크(DeepSeek)'가 내놓은 AI 모델 R1과 비교하면 상황이 묘하다. 적은 비용으로 미국 빅테크들과 견줄 수 있는 성능을 낸 AI는 오픈소스 모듈을 적극적으로 차용해 개발됐지만 자체 AI모델로 인정받고 있다.

똑같이 외부 기술을 빌려 썼는데 딥시크는 독자 기술로 주목받고 국내 기업은 무늬만 독자라는 비판을 받고 있는 셈이다. 이에 대해 업계 전문가들은 양측의 가장 큰 차이로 기업이 가진 철학과 이를 구현하는 차별화를 꼽았다.

딥시크부터 구글까지...오픈소스 활용하는 글로벌 AI

딥시크의 기술 보고서에 따르면 R1을 비롯한 모델 라인업 개발 과정에서 주요 기능 구현에 경쟁사 모듈이 대거 사용됐다.

멀티모달 모델은 이미지를 인식하는 비전 인코더로 구글에서 개발한 모델을 도입했다. 딥시크-VL은 SigLIP-L, SAM-B를 하이브리드 비전 인코더로 썼고 야뉴스는 SigLIP-L을 비전 인코더로 채택했다

학습 과정도 마찬가지다. 딥시크는 모델 학습 속도를 극한으로 끌어올리기 위해 경쟁사인 오픈AI가 개발해 공개한 GPU 프로그래밍 언어 '트라이톤(Triton)'을 추론 및 커널 최적화 코드에서 활용했다. 학습 가속을 위해서는 스탠포드 대학 연구진이 개발한 플래시 어텐션 모듈을 차용했다.

이런 모듈 활용은 딥시크에 국한된 이야기가 아니다. 현재 오픈형 LLM 표준으로 불리는 메타의 라마 시리즈는 문맥 순서를 파악하는 위치 임베딩에 중국 AI 기업 쥬이이테크놀로지가 개발한 회전위치임베딩(RoPE) 모듈을 사용한다.

활성화 함수 역시 구글이 제안한 'SwiGLU' 방식을 채택했다. 구글 제미나이 역시 학습 효율을 위해 딥시크처럼 외부에서 개발한 플래시 어텐션 기술을 내부 인프라에 통합해 사용 중이다.

임정환 모티프 대표는 "자동차를 만들 때 타이어나 와이퍼를 전문 업체 부품으로 썼다고 해서 그 차를 독자 개발이 아니라고 하지 않는다"며 "인코더나 가속 라이브러리 같은 '부품을 외부에서 가져오는 방은 효율성을 위한 합리적인 선택"이라고 설명했다.

강화학습·MoE로 효율 혁신...딥시크, 기술로 증명한 독자 가치

다양한 오픈소스를 활용했음에도 딥시크가 독자 모델로 평가받는 이유는 그 동안 없었던 기술적 시도를 통해 새로운 가치를 증명했기 때문이다.

당시 중국은 미국 반도체 제재로 인해 최신 엔비디아 GPU를 구하기 어려운 상황에 처했다. 딥시크는 제한된 인프라 안에서 어떻게 하면 미국 빅테크와 대등한 성능을 낼 수 있을까라는 과제를 안고 있었다.

이를 해결하기 위해 도입한 방법이 강화학습이었다. 당시 업계는 강화학습을 챗봇 말투를 교정하는 용도(RLHF)로 제한해 활용했다. 추론 능력을 높이는 데는 효율이 떨어진다고 여겨 잘 시도하지 않았다.

하지만 딥시크는 "강화학습을 통해 AI가 스스로 생각하는 과정을 훈련시키면 적은 데이터와 파라미터로도 추론 능력을 극대화할 수 있다"는 독자적인 가설을 세웠다. 그리고 이를 기술적으로 구현해 냄으로써 단순히 데이터를 많이 쏟아붓는 방식이 아닌 새로운 '지능 향상의 길'을 열었다. 기존 오픈소스 모델을 가져와 데이터만 주입하던 방식과는 차원이 다른 접근이었다.

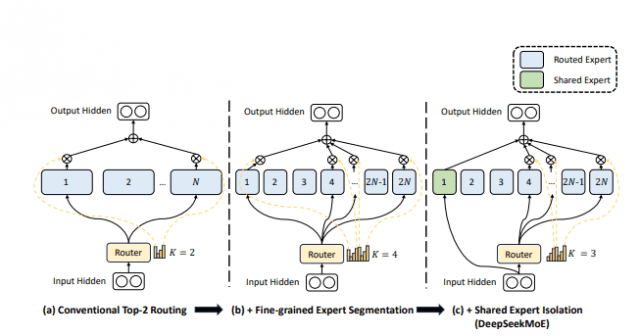

또 다른 혁신은 아키텍처 효율화에 있다. 이들이 채택한 '전문가 혼합(MoE)' 모델은 거대 AI를 각 분야에 최적화된 여러 개 '작은 전문가 모델'로 나눈 뒤 질문에 따라 필요한 모델만 불러와 처리함으로써 효율을 극대화하는 기술이다. 1991년 처음 제안된 후 구글이 '스위치 트랜스포머(Switch Transformer)' 등을 통해 발전시킨 개념이다.

딥시크는 기존 MoE 보다 전문가 모델을 더 세분화하고 어떤 질문이든 공통적으로 필요한 지식을 다루는 일부 모델은 항상 대기시키는 방식을 더해 딥시크MoE라는 독자적인 변형 아키텍처로 발전시켰다.

기존에 존재하던 기술을 재설계해 경쟁사 모델 대비 메모리 사용량과 연산 비용을 획기적으로 줄이는 데 성공했다. 결과적으로 적은 자원으로도 고성능을 낼 수 있음을 증명했다.

유명호 스누아이랩 대표는 "오픈소스를 활용하는 것보다 중요한 건 오픈소스를 그대로 가져다 쓰는지 아니면 거기에 독창적인 아이디어와 방법론을 결합해 새로운 가치를 만들어내느냐 차이"라고 지적했다.

이어 "학계에서도 기존 모델에 새로운 엔진이나 방법론을 접목해 성능을 개선하면 새로운 이론으로 인정한다"며 "단순히 오픈소스를 썼냐 아니냐를 따질 게 아니라 기업에서 제시한 새로운 이론이나 기술이 얼마나 적용되었는가를 따지는 심사 기준이 필요하다"고 말했다.

한국어만 잘하는 AI는 넘어...차별화된 혁신성 제시해야

업계 전문가들은 이번 논란을 계기로 한국 AI 산업이 '독자 AI'라는 단어의 함정에서 빠져나와야 한다고 지적한다. 단순히 부품 국산화율을 따지는 제조업식 사고방식으로는 AI 기술 패권 경쟁 본질을 놓칠 수 있다.

유명호 대표는 "비전 인코더는 데이터 구축도 어렵고 개발 난도가 매우 높다"며 "우리도 자체 개발하는 데만 2~3년이 걸렸다"며 단시간에 AI 관련 모든 인프라를 구축하는 것은 한계가 있다고 지적했다.

현재 글로벌 시장은 AI 관련 모든 요소를 자체적으로 만들었는지 보다 특정 분야라도 얼마나 독창적이고 차별화된 아키텍처를 만들었는지, 그 결과 비용 효율성이나 특정 기술 특화 등 차별화 포인트가 무엇인지를 묻고 있다. 딥시크가 인정받는 이유도 이 지점이다.

더불어 압도적인 자본과 인력을 쏟아붓는 미국과 중국을 단순히 추격하는 방식으로는 승산이 없다는 지적이다. 특히 글로벌 시장에서 경쟁하기 위한 AI 모델을 목표로 하는 만큼 한국어 인식률이 높다는 포인트만으로는 차별화 포인트를 제시할 수 없다는 것이 업계 반응이다.

임정환 대표는 "정부와 시장이 벤치마크 점수 1등이라는 타이틀에만 집착하면 기업은 결국 검증된 오픈소스 모델을 가져와 점수만 올리는 '안전한 길'만 택하게 된다"고 경고했다.

관련기사

- 'K-AI' 주도권 잡을 4개 정예팀은…정부, 첫 심사 발표 임박2026.01.12

- LG AI연구원, 'K-엑사원' 경쟁력 입증…'독파모' 첫 평가 1위2026.01.11

- "해외도 놀랐다"...허깅페이스 CEO가 주목한 'K-AI' 3곳 어디?2026.01.08

- [AI 리더스] 'AI 표준' 만든 이승현 "K-AI 5곳, 모두 승자…톱2 집착 버려야"2026.01.08

단기적으로는 가시적인 성과처럼 보일지 몰라도 장기적으로는 원천 기술 부재로 인한 글로벌 기술 종속을 심화시키는 결과를 초래할 수 있다는 지적이다. 이를 방지하고 한국 AI 산업이 딥시크와 같은 반열에 오르기 위해서는 '보여주기식 성과'에 집착하는 현재 평가 체계를 개선해야 한다는 요구도 제기되고 있다.

임 대표는 "진정한 국가대표 AI라면 단순히 한국어를 잘하는 AI를 넘어 글로벌 시장에 내세울 수 있는 특화된 장점과 경쟁력이 있어야 한다"며 "설령 당장은 점수가 낮거나 실패하더라도 맨땅에 헤딩하며 독자적인 가설을 세우고 원천 기술을 확보하려는 기업에게 더 많은 기회와 지원을 제공해야 한다"고 제언했다