인공지능 언어모델들이 서로 협력할 때 텍스트 메시지 대신 '생각'을 직접 교환하는 새로운 방법이 개발됐다. 중국 칭화대학교와 인피니전스 AI 연구팀은 여러 AI 모델이 함께 일할 때 텍스트로 대화하는 기존 방식의 한계를 넘어서는 '캐시-투-캐시(C2C)' 기술을 선보였다.

텍스트 대화의 문제점… 정보 손실되고 시간도 오래 걸려

연구 논문에 따르면, 현재 여러 AI 모델이 협업할 때는 사람처럼 텍스트로 대화한다. 한 모델이 분석한 내용을 문장으로 만들어 다른 모델에게 전달하는 식이다. 하지만 이 과정에는 문제가 있다. AI가 머릿속에서 이해한 복잡한 내용을 단순한 텍스트로 바꾸면서 많은 정보가 사라진다. 게다가 단어를 하나하나 생성해야 하므로 시간도 오래 걸린다.

연구팀은 이런 문제를 해결하기 위해 'KV 캐시'라는 것을 활용하는 방법을 제안했다. KV 캐시는 AI가 문장을 이해할 때 머릿속에 저장하는 일종의 메모장이다. 이 메모장에는 단순한 텍스트보다 훨씬 풍부한 의미 정보가 담겨 있다. 마치 사람이 책을 읽으면서 머릿속에 떠오르는 이미지나 감정처럼, AI도 텍스트를 넘어서는 깊은 이해를 이 캐시에 저장한다.

연구팀은 실험을 통해 이 아이디어가 실제로 효과가 있는지 확인했다. 같은 길이의 질문이라도 캐시에 담긴 정보가 더 풍부하면 AI가 더 정확하게 답한다는 것을 발견했다. 예를 들어 퓨샷(few-shot) 방식으로 예시를 먼저 보여준 뒤, 질문 부분의 캐시만 사용하도록 했더니 일반적인 방식보다 정확도가 3.92% 높아졌다.

신경망으로 AI의 '생각'을 번역해 전달

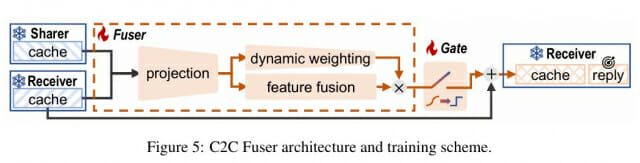

C2C 시스템의 핵심은 한 AI의 캐시를 다른 AI가 이해할 수 있는 형태로 바꿔주는 '캐시 퓨저'라는 장치다. 이는 마치 통역사처럼 한 AI의 생각을 다른 AI의 언어로 번역해준다. 캐시 퓨저는 세 가지 부품으로 구성된다. 첫째, 두 AI의 캐시를 연결해서 변환하는 '프로젝션 모듈'이다. 둘째, 상황에 따라 전달할 정보의 양을 조절하는 '동적 가중치 모듈'이다. 셋째, 각 단계에서 정보를 받아들일지 말지 결정하는 '게이트'다. 게이트는 학습을 통해 어떤 단계에서 다른 AI의 도움이 필요한지 스스로 판단한다.

이 시스템을 훈련할 때는 원래 두 AI 모델은 그대로 두고 캐시 퓨저만 학습시킨다. 두 AI가 같은 질문을 받아 각자의 캐시를 만들면, 캐시 퓨저가 이를 합친다. 그리고 받는 쪽 AI가 합쳐진 캐시로 답변을 만들면서 점점 더 잘 합치는 방법을 배운다. 서로 다른 종류의 AI끼리도 이 방식을 쓸 수 있다. 연구팀은 각 AI가 사용하는 단어 단위를 맞추고, AI 내부의 처리 단계를 짝지어주는 기술을 개발했다. 단어 맞추기는 한 AI의 단어를 문자로 풀었다가 다른 AI의 단어로 다시 조립하는 방식이고, 단계 맞추기는 두 AI의 마지막 단계부터 거꾸로 올라가며 연결하는 방식이다.

정확도 최대 10% 높이고 속도는 2배 빨라져

연구팀은 Qwen, Llama, Gemma 등 여러 종류의 AI 모델로 실험했다. 연구팀은 C2C 기술을 적용한 AI가 혼자 동작하는 기존 방식에 비해 평균적으로 8.5~10.5% 더 높은 정확도를 보였다고 밝혔다. 텍스트 기반 협력 방식과 비교하면 평균 3~5% 정도 정확도가 더 높았으며, 처리 속도 역시 두 배 이상 빨라졌다는 것이 실험 결과다. 다양한 모델 조합 실험에서도 C2C는 일관된 효과를 보였다. Qwen3-0.6B와 Gemma3-1B의 조합에서는 텍스트 방식(41.35%)보다 C2C(45.90%)가 4.55% 포인트 높은 정확도를 기록했다.

구체적인 예를 보면, 작은 AI 모델(Qwen3-0.6B)이 혼자 문제를 풀 때 정확도가 35.53%였는데, 다른 모델의 도움을 C2C로 받았더니 42.92%로 올라갔다. 텍스트로 도움을 받았을 때는 41.03%였으니, C2C가 거의 2% 포인트 더 높은 셈이다. 시간도 텍스트 방식은 1.52초 걸렸는데 C2C는 0.40초밖에 안 걸렸다.

긴 문장을 처리하는 테스트에서도 C2C가 우수했다. 0~4천 단어 길이의 문장에서 C2C는 36.64%의 정확도를 보였는데, 텍스트 방식은 29.47%에 그쳤다. 차이가 7% 이상 났다. 모델 크기에 따른 효과도 확인했다. 도움을 주는 AI가 클수록 C2C의 효과가 더 컸다. 작은 AI(5억 파라미터)가 도와줄 때보다 큰 AI(140억 파라미터)가 도와줄 때 정확도 향상 폭이 훨씬 컸다. 이는 더 똑똑한 AI의 지식을 C2C가 효과적으로 전달할 수 있다는 뜻이다.

필요한 부분만 선택적으로 받아들여 효과 극대화

연구팀은 C2C의 각 부품이 얼마나 중요한지도 실험했다. 단순히 캐시를 변환만 하면 정확도가 20.70%에 불과했다. 하지만 두 AI의 캐시를 합치는 기능을 추가하자 44.88%로 급등했다. 여기에 게이트를 추가하니 47.95%까지 올라갔다.

흥미로운 점은 모든 단계에서 다 도움을 받는 것보다 선택적으로 받는 게 더 좋았다는 것이다. AI 내부에는 여러 처리 단계(레이어)가 있는데, 상위 10개 단계에만 도움을 받았을 때가 모든 단계에 다 받았을 때보다 정확도가 높았다. C2C 시스템의 게이트 기능은 AI 내부의 여러 처리 단계 중 실제로 성능을 높이는 단계에서만 정보를 융합하도록 자동 학습된다. 연구팀은 상위 10개 단계에만 선택적으로 도움을 받게 했을 때 전체 27개 레이어를 모두 활용하는 것보다 성능이 높아졌다고 설명했다.

연구팀은 '유효 랭크'라는 지표로 캐시가 얼마나 풍부한 정보를 담고 있는지 측정했다. C2C를 쓴 후 이 수치가 증가했는데, K 캐시는 388에서 395로, V 캐시는 532에서 560으로 올라갔다. 숫자가 클수록 더 다양하고 풍부한 정보가 담겨있다는 의미다. 이는 C2C가 한 AI의 지식을 다른 AI에 성공적으로 주입해서 이해의 폭을 넓혔다는 증거다.

연구팀은 C2C 기술이 다양한 분야로 확장 가능하다고 설명했다. 예를 들어 클라우드의 강력한 AI가 엣지 기기의 작은 AI에게 핵심 정보만 캐시로 전달하면, 원본 텍스트를 노출하지 않으면서도 작은 AI의 능력을 향상시킬 수 있다. 또 텍스트 AI, 이미지 AI, 로봇 제어 AI의 캐시를 합치면 언어, 시각, 행동이 통합된 더 똑똑한 시스템을 만들 수 있다.

FAQ( ※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q1. C2C 기술은 쉽게 말하면 무엇인가요?

A. AI 모델들이 대화할 때 문장 대신 '머릿속 메모'를 직접 공유하는 기술입니다. 사람으로 치면 말로 설명하는 대신 생각을 직접 전달하는 것과 비슷합니다. 이렇게 하면 말로 표현하면서 빠지는 정보가 없고, 말하는 시간도 절약됩니다.

Q2. 왜 텍스트보다 캐시를 주고받는 게 더 좋은가요?

A. 복잡한 생각을 단순한 문장으로 바꾸면 많은 정보가 사라집니다. 게다가 AI가 문장을 만들려면 단어를 하나씩 생성해야 해서 시간이 오래 걸립니다. 캐시는 더 풍부한 정보를 담고 있고 한 번에 전달할 수 있어서 2배 빠르면서도 정확도도 3~5% 높습니다.

Q3. 어떤 AI 모델에서나 C2C를 쓸 수 있나요?

관련기사

A. 네, 다양한 종류, 다양한 크기의 AI 모델에서 사용할 수 있습니다. 연구팀이 Qwen, Llama, Gemma 등 여러 회사의 AI로 테스트했고, 작은 모델(6억)부터 큰 모델(140억)까지 모두 잘 작동했습니다. 서로 다른 AI끼리도 캐시를 번역해주는 기술이 있어서 호환됩니다.

■ 이 기사는 AI 전문 매체 ‘AI 매터스’와 제휴를 통해 제공됩니다. 기사는 클로드 3.5 소네트와 챗GPT를 활용해 작성되었습니다. (☞ 기사 원문 바로가기)