“래블업(Lablup)은 AI의 민주화가 목표입니다.”

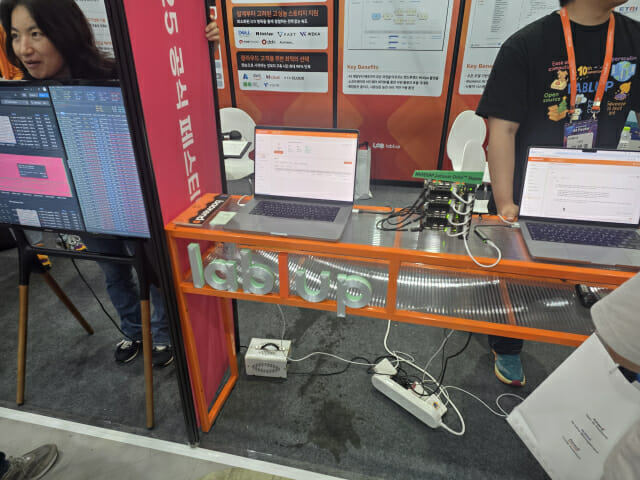

래블업 관계자는 1일 서울 삼성동 코엑스에서 열린 과학기술정보통신부 공식 AI 주간 'AI페스타 2025'에서 “AI 개발을 힘들어하는 분들이 좀 더 편한 환경에서 누구나 AI를 쓰실 수 있도록 AI의 장벽을 낮출 것”이라며 이같이 밝혔다.

래블업은 랩(Lab)과 업그레이드(Upgrade)의 합성어로, 연구와 업그레이드를 잇는다는 뜻을 담았다. 회사가 지난 2015년 창업 이후 집중해 온 지점은 ‘AI 접근성’이다. 10년이 지난 오늘날, 오늘날 단순한 툴 제공을 넘어 GPU, NPU 등 대규모 자원을 효율적으로 활용 할 수 있는 백엔드 AI 오케스트레이션 플랫폼으로 입지를 넓혀가고 있다.

“백엔드 닷 AI, 엔비디아 대비 GPU 자원

래블업의 핵심 플랫폼은 ‘백엔드 닷 AI(Backend.AI)’다. 연구자와 기업이 복잡한 설정 없이도 대규모 GPU 자원을 쉽게 띄워 학습과 추론을 실행할 수 있도록 지원한다. 특히 자체 개발한 ‘슈퍼바이저’ 오케스트레이터를 통해 쿠버네티스 대비 오버헤드를 1/4 수준으로 줄였다.

“AI 개발 돕는다”...온프레미스 환경에 적합

래블업은 AI 개발 중 반복되는 불편을 줄이기 위한 기능도 제공한다.

먼저 빨리(PALI)는 모델 이름만 입력하면 GPU에 자동 배포돼 즉시 API 엔드포인트(URL)를 제공한다. 연구자나 개발자가 별도의 서버 세팅 없이 오픈AI API처럼 바로 활용할 수 있는 구조다.

패스트트랙(FastTrack)의 경우 데이터 전처리→학습→평가 과정을 드래그앤드롭 방식으로 자동 실행한다. 사용자는 학습 코드 작성에만 집중하고, 반복되는 환경 설정은 플랫폼이 대신 처리한다.

관련기사

- 래블업, AI 네이티브 플랫폼 'AI:DOL' 첫선…글로벌 시장 '정조준'2025.09.05

- 래블업, 獨서 글로벌 진출 시동…"유럽 HPC 시장에 도전장"2025.06.05

- "북미 시장 정조준"…래블업, 엔비디아 GTC 2025서 AI 인프라 혁신 공개2025.03.20

- KT, 래블업과 GPU 구독 서비스 협력..."국내 AI 생태계 확장"2025.02.27

래블업의 플랫폼은 온프레미스 환경에 적합하다. 금융사, 정부기관, 대기업처럼 민감한 데이터를 외부로 유출할 수 없는 기관들이 주요 고객층이다. 실제로 금융사와 통신사 일부가 래블업의 기술을 채용해 AI를 운영하고 있다.

회사는 엔비디아 GPU뿐 아니라 국산 NPU 등 다양한 칩도 지원한다. 래블업 관계자는 “새로운 칩이 나오면 직접 테스트해 지원을 늘려가고 있다”며 “국산 반도체 기업들과의 협업을 적극 추진하고 있다”고 말했다.