LLM, 거짓 정보 탐지에는 강하지만 전반적 성능은 아직 미흡

생성형 AI를 기반으로 한 대형 언어 모델(LLM)이 정치 정보의 진위를 판별하는 팩트체킹 영역에서 어떤 역할을 할 수 있을지 관심이 커지고 있다. 최근 ChatGPT와 같은 대화형 AI의 등장으로 정보의 진위를 자동으로 판별하는 기술에 대한 기대가 높아지고 있는 가운데, 바이젠바움 연구소와 베른 대학 연구팀이 5개 주요 LLM의 팩트체킹 능력을 체계적으로 평가한 연구 결과를 발표했다.

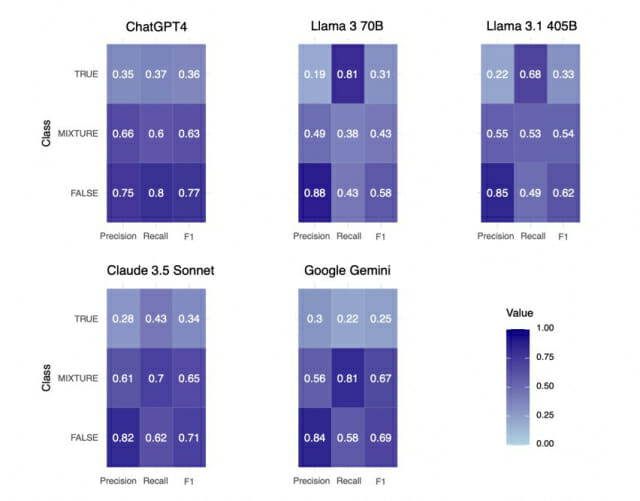

연구팀은 ChatGPT-4, Llama 3(70B), Llama 3.1(405B), Claude 3.5 Sonnet, Google Gemini 등 5개 LLM을 대상으로 전문 팩트체커가 이미 검증한 1만 6,513개의 정치 정보 진술문에 대한 진위 판별 능력을 테스트했다. 주제 모델링과 회귀 분석을 통해 진술문의 주제나 모델 유형이 판별 정확도에 어떤 영향을 미치는지 체계적으로 분석했다.

정확도는 챗GPT와 제미나이가 앞서… 거짓 정보 탐지 정확도 최대 80%

연구 결과에 따르면 ChatGPT-4와 Google Gemini가 다른 모델보다 전반적으로 높은 정확도를 보였다. 특히 모든 모델이 참인 정보보다 거짓 정보를 탐지하는 데 더 강점을 보였는데, 특히 코로나19, 미국 정치 논쟁, 사회 이슈와 같은 민감한 주제에서 더 높은 정확도를 나타냈다.

이는 모든 LLM이 공중 보건이나 정치인과 관련된 민감한 주제에 대해 가드레일(안전장치)을 설정했을 가능성을 시사한다. 이런 주제에 대한 높은 정확도는 훈련 데이터에 관련 거짓 정보가 더 많이 포함되었을 가능성도 있지만, GPT 모델이 건강 관련 주제에서 높은 정확도를 보인다는 이전 연구와도 일치하는 결과다.

코로나19는 133% 더 정확하게, 경제 주제는 70% 더 부정확하게 판별

모든 LLM은 전반적으로 '혼합(MIXTURE)' 범주의 진술문보다 '거짓(FALSE)' 범주의 진술문을 더 정확하게 식별했다. 특히 진위 여부가 명확한 극단적 사례보다 부분적 사실과 부분적 거짓이 혼합된 복잡한 진술을 평가하는 데 어려움을 겪었다.

흥미롭게도 연구진은 LLM 간 성능 차이가 상당하다는 점을 발견했다. 예를 들어 Llama 모델은 진술문이 '참'인지 '거짓'인지 혹은 '혼합'인지에 관계없이 '참'으로 판정하는 경향이 있었다. 이는 모델들의 기반이 되는 훈련 데이터가 성능에 깊은 영향을 미친다는 점을 보여준다.

또한 미국 재정 문제나 경제 관련 주제에서는 모든 LLM이 거짓 정보를 식별하는 정확도가 낮았다. 이는 특정 주제에 대한 훈련 데이터의 부족이나 주제별 가드레일의 차이에서 기인했을 가능성이 있다.

더 큰 모델이 팩트체킹도 더 정확하게 수행

연구팀은 LLM의 팩트체킹 성능이 모델의 아키텍처 및 파라미터 규모와 직접적인 관련이 있다고 지적했다. Llama 3.1(405B)이 Llama 3(70B)보다 모든 카테고리에서 더 나은 성능을 보인 것이 이를 증명한다. 이는 더 많은 파라미터로 훈련된 모델이 복잡한 팩트체킹 작업에서 더 좋은 성능을 발휘한다는 것을 의미한다.

연구진은 LLM의 팩트체킹 능력 향상을 위해 목표화된 사전 훈련과 미세 조정이 필요하다고 제안했다. 특히 코로나19와 미국 정치 관련 주제에서 모든 LLM이 높은 정확도를 보인 점에 주목하며, 가드레일 설정이 출력의 정확성을 보장하는 유망한 전략이 될 수 있다고 밝혔다.

하지만 이러한 가드레일은 변화하는 사회정치적 맥락에 맞춰 지속적인 조정이 필요하다는 도전과제도 함께 존재한다. 연구팀은 또한 ClaimsKG 데이터셋이 미국 중심적이라는 점을 한계로 지적하며, 다른 사회정치적 맥락이나 언어에서는 LLM 성능이 다를 수 있다고 경고했다.

FAQ

Q: 생성형 AI가 팩트체킹을 완전히 자동화할 수 있을까요?

A: 현재로서는 어렵습니다. 이번 연구에서 보듯 대형 언어 모델(LLM)은 특히 거짓 정보 탐지에 강점을 보이지만, 전반적인 정확도는 여전히 제한적입니다. LLM은 팩트체킹을 보조하는 도구로 활용하되, 전문가의 검증이 여전히 필요합니다.

Q: 왜 AI는 참인 정보보다 거짓 정보를 더 잘 탐지하나요?

A: 연구에 따르면 이는 훈련 데이터의 특성과 관련이 있을 수 있습니다. 예를 들어 ChatGPT-4는 팩트체크된 거짓 정보가 더 많이 포함된 데이터로 훈련되었을 가능성이 있고, 특히 코로나19나 정치 논쟁과 같은 민감한 주제에 대해서는 가드레일(안전장치)이 설정되어 있을 수 있습니다.

Q: 어떤 주제에서 AI 팩트체킹이 가장 정확한가요?

관련기사

- 챗GPT 시대, 대학생들의 AI 태도 측정할 척도 개발됐다2025.03.15

- [Q&AI] 백종원 형사 입건, 왜? …AI가 수집한 소비자 반응은2025.03.14

- 챗GPT? 클로드?…생성형 AI, 최고 인기 모델은?2025.03.14

- [Q&AI] 시드니FC vs 전북…챗GPT가 예상한 결과는2025.03.13

A: 이번 연구에서는 코로나19, 미국 정치 논쟁, 사회 이슈와 같은 민감한 주제에서 AI가 더 정확한 팩트체킹을 수행했습니다. 반면 미국 경제나 재정 정책 관련 주제에서는 정확도가 낮았습니다. 이는 특정 주제에 대한 데이터 부족이나 가드레일 설정의 차이에서 비롯될 수 있습니다.

■ 이 기사는 AI 전문 매체 ‘AI 매터스’와 제휴를 통해 제공됩니다. 기사는 클로드 3.5 소네트와 챗GPT를 활용해 작성되었습니다. (☞ 기사 원문 바로가기)