수학·과학·코딩 테스트에서도 강력한 성능 입증

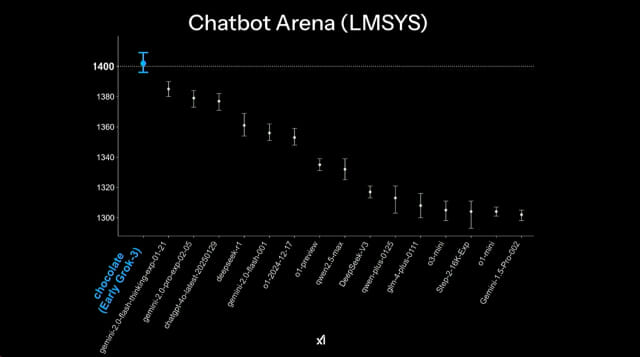

xAI가 새롭게 출시한 인공지능 챗봇 ‘그록3’가 AI 성능 평가 플랫폼 Chatbot Arena에서 최상위 점수를 기록하며 경쟁 모델들을 압도했다. 18일(한국 시간) 오후 1시 xAI 공식 X에서 진행된 '그록3 출시' 라이브에 따르면, ‘그록3’는 OpenAI의 GPT-4o, Google DeepMind의 Gemini-2 Pro, Anthropic의 Claude 3.5 Sonnet 등을 제치고 챗봇 성능 순위 1위에 올랐다. (☞ 발표 바로가기)

그록3, AI 챗봇 성능 평가 1위 차지

최근 공개된 Chatbot Arena의 성능 비교 차트에 따르면, ‘그록3’는 경쟁 모델을 상대로 가장 높은 점수를 기록했다. 특히 LMSYS의 순위 평가에서 ‘그록3’는 독보적인 점수로 1위를 차지했으며, 신뢰 구간(오차 범위) 역시 경쟁 모델들보다 안정적인 것으로 나타났다. LMSYS의 Chatbot Arena는 익명의 AI 모델을 사용자가 직접 비교 평가하는 방식으로 운영되며, AI 챗봇 간의 실제 사용자 피드백을 기반으로 순위를 산정한다. 이번 결과는 ‘그록3’가 실사용 환경에서 GPT-4o나 Gemini-2 Pro보다 더 나은 성능을 발휘했음을 시사한다.

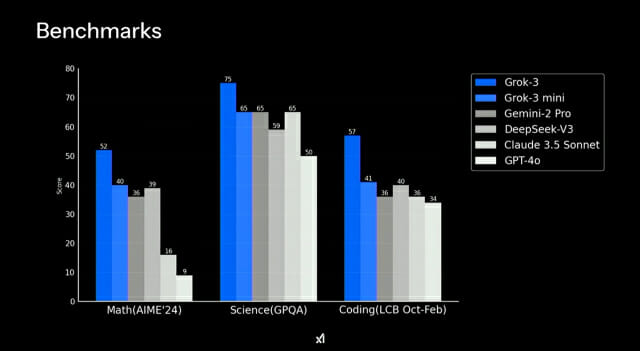

벤치마크 테스트에서도 두각

또한

Benchmarks테스트에서도 ‘그록3’는 수학(AIME 2024), 과학(GPQA), 코딩(LCB Oct-Feb) 항목에서 경쟁 모델 대비 압도적인 성적을 기록했다.

수학(AIME 2024):52점(그록3) vs. 40점(GPT-4o), 39점(Claude 3.5 Sonnet)

과학(GPQA):75점(그록3) vs. 65점(Gemini-2 Pro, GPT-4o), 50점(Claude 3.5 Sonnet)

코딩(LCB Oct-Feb):57점(그록3) vs. 41점(GPT-4o), 40점(Gemini-2 Pro)

이는 AI 모델의 논리적 추론 및 문제 해결 능력을 평가하는 핵심 지표로, ‘그록3’가 특정 영역에서 기존 모델들보다 더 뛰어난 성능을 보였다는 점을 확인할 수 있다.

xAI, 그록3로 AI 경쟁에서 우위 점할까?

관련기사

- 美 법원 "AI도 저작권 위반"...챗GPT·클로드 떨고 있다2025.02.18

- AI, 동물 통증도 잘 잡아낸다…"수의사 보다 11.5% 더 정확"2025.02.18

- 오픈AI, 챗GPT 검열 해제…"모든 관점 수용하겠다"2025.02.17

- "생성형 AI 구독, 작년 299% 늘어…30대가 최다 이용"2025.02.17

xAI는 일론 머스크가 설립한 AI 연구 기업으로, 경쟁사 대비 보다 자유로운 답변을 생성하는 AI 모델을 개발하는 것을 목표로 한다. ‘그록3’는 이전 모델보다 자연어 이해와 생성 능력이 크게 향상되었으며, 특히 복잡한 문제 해결과 프로그래밍에서 높은 성과를 보이고 있다. 이번 ‘그록3’의 성능 결과는 AI 시장에서 OpenAI, Google DeepMind, Anthropic과의 경쟁이 더욱 치열해지고 있음을 의미한다. GPT-4o와 Gemini-2 Pro가 시장을 선도하고 있는 가운데, ‘그록3’가 실제 제품화 과정에서 어떤 차별점을 가질지 주목된다.

■ 기사는 클로드 3.5 소네트와 챗GPT-4o를 활용해 작성되었습니다. (☞ 기사 원문 바로가기)