중국 인공지능(AI) 스타트업 딥시크가 새 모델 'R1' 출시로 AI 생태계에 돌풍을 일으킨 가운데 미국 빅테크가 R1을 사업에 활용하는 전략으로 발빠른 대응에 나섰다.

30일 글로벌 업계에 따르면, 마이크로소프트와 아마존웹서비스(AWS), 메타가 딥시크 R1을 활용해 자사 서비스와 모델 개발을 업그레이드하기 위해 나선 것으로 전해졌다. 마이크로소프트와 AWS는 R1을 서비스에 접목했으며, 메타는 R1 기술을 분석해 자사 모델 라마에 적용할 방침이다.

마이크로소프트는 딥시크의 R1을 자사 클라우드 컴퓨팅 플랫폼 애저(Azure)와 개발자 도구 깃허브에 제공한다고 밝혔다. 마이크로소프트 플랫폼 내 1천800개 넘는 AI 모델 목록에 R1을 추가한다. R1은 애저와 깃허브의 모델 카탈로그에서 우선 제공된다.

다수 외신은 마이크로소프트가 챗GPT 개발사인 오픈AI에 대한 의존도를 줄이려는 전략이라고 분석했다. 앞서 로이터도 지난달 마이크로소프트가 자사 대표 AI 제품인 마이크로소프트 365 코파일럿을 강화하기 위해 내부·서드파티 AI 모델을 추가하는 작업을 진행 중이라고 보도한 바 있다.

또 마이크로소프트는 고객들이 R1 모델을 코파일럿+PC에서 로컬로 실행할 수 있도록 지원할 계획도 밝혔다. 이를 통해 사용자 데이터가 중국 서버로 전송되지 않고 PC 내부에서만 AI가 작동하도록 해 프라이버시를 완화하려는 전략이다.

앞서 딥시크는 사용자 정보를 중국 내 서버에 저장한다고 발표했다. 이에 업계에서는 딥시크의 해외 진출 도입에 걸림돌이 생길 가능성을 높게 봤다.

AWS "아마존 베드락 사용자, R1 호출 가능"

AWS는 아마존 베드락 사용자가 R1의 증류모델을 '아마존 베드락 커스텀 임포트(Amazon Bedrock Custom Import)'에서 사용 가능하다고 29일 발표했다.

AWS는 6천710억개 학습 파라미터 모델로 이뤄진 R1을 더 작은 모델로 압축한 증류 모델 '딥시크-R1-Distill-Llama-8B'와 '딥시크-R1-Distill-Llama-70B'를 아마존 베드락에 호출해 이용할 수 있다고 공식 블로그에서 밝혔다.

두 모델은 기존 R1 모델에서 추출한 내용 토대로 학습하는 지식증류 방식을 통해 개발됐다. 원본 딥시크-R1 기반으로 메타의 '라마'와 알리바바의 '큐원' 아키텍처를 융합한 변형 모델이다. 원본 딥시크-R1 행동과 논리적 추론 패턴을 학습했다. 모델 크기는 작지만 이용료가 적게 드는 것으로 알려졌다.

예를 들어 8B 모델은 요청을 더 빠르게 처리할 수 있으며 리소스 소모가 원본 모델보다 적다. 이에 프로덕션 환경에서 비용 효율적으로 사용될 수 있다. 반면 70B 모델과 같은 대형 증류 모델은 원본 모델에 가까운 성능을 유지하면서도 효율성 개선에 초점 맞췄다.

AWS는 "딥시크-R1 모델 군은 코드 생성부터 일반 추론에 이르기까지 다양한 작업을 수행할 수 있도록 설계됐다"며 "경쟁력 있는 성능과 효율성을 유지하면서 폭넓은 활용이 가능하다"고 공식 블로그를 통해 강조했다.

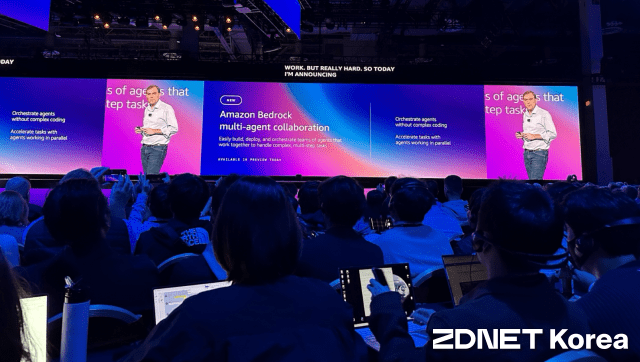

이같은 AWS의 전략은 기업과 개발자가 아마존 베드락에서 다양한 AI 모델을 호출해 멀티 에이전트를 구현할 수 있도록 돕겠다는 기업 목표와 일맥상통한다.

맷 가먼 AWS 최고경영자(CEO)는 "개발자는 아마존 베드락에서 여러 모델을 통합해 AI 서비스와 모델을 개발할 것"이라며 "아마존 베드락을 통해 다양한 모델을 융합할 기회를 제공할 것"이라고 지난 미국 라스베이거스에서 열린 'AWS 리인벤트'에서 발언했다.

"딥시크 기술 분석"…메타, 4개 워룸 구성

메타는 딥시크의 AI 기술 분석과 전략 수립을 위해 4개의 '워룸(war room)'을 구성한 것으로 전해졌다. 워룸은 긴급한 상황에서 집중적으로 전략을 짜고 실행하는 핵심 조직이다.

디인포메이션은 29일 메타 매튜 올덤 AI 인프라 디렉터가 딥시크의 최신 모델이 메타의 차세대 라마 모델보다 성능이 뛰어날 수 있다 언급했다고 내부 소식통을 인용해 보도했다. 앞서 메타는 올 초 '라마4' 출시 계획을 밝힌 바 있다.

내부 소식통에 따르면 메타가 구성한 워룸 4개 중 두 팀은 딥시크가 어떻게 AI 훈련·운영 비용을 낮출 수 있었는지 분석 중이다. 이 전략으로 메타의 라마 모델에 적용하는 것이 목표다.

또 다른 팀은 딥시크가 어떤 데이터로 AI 모델을 훈련시켰는지 조사하는 역할을 맡은 것으로 전해졌다. 나머지 팀은 딥시크 AI 모델 특성 기반으로 라마의 모델 구조를 어떻게 재설계 할 수 있을지 연구 중인 것으로 알려졌다.

메타는 "경쟁 모델을 지속적으로 평가하기 위한 과정일 뿐"이라며 "사내 생성형 AI 그룹이 생긴 이후 지속한 연구"라고 디인포메이션에 입장 밝혔다. 이어 "라마는 오픈소스 AI 모델 생태계 구축에 중요한 역할을 했다"며 "출시 예정인 라마4를 위해 해당 리더십을 확장할 것"이라고 덧붙였다.

관련기사

- 알리바바, 새 AI 모델 출시…"오픈AI·딥시크·메타 능가"2025.01.30

- 中 딥시크, 오픈AI 못잖네…美 수출 통제 실효성 논란2025.01.30

- "딥시크 R1, 어떻게 만들었나?"…美연구진, AI역설계로 뜯어본다2025.01.30

- 中 딥시크, 이미지 AI '야누스 프로'도 공개…美, AI 지위 흔들2025.01.28

마크 저커버그 최고경영자(CEO)도 지난 29일 4분기 실적 발표 컨퍼런스 콜에서 "딥시크가 여러 가지 새로운 시도를 했다"며 "현재 이를 분석하는 중"이라고 밝힌 바 있다. 이어 "딥시크의 '기술적 발전'을 라마 모델에 적용할 계획"이라고 말했다.

저커버그 CEO는 딥시크 등장으로 인해 AI 모델에 높은 컴퓨팅 자원이 필요하지 않을 가능성에 대해서도 입을 열었다. 그는 "여전히 대규모 자본 지출과 인프라에 대한 공격적인 투자가 필요할 것"이라며 "시간이 지날수록 이 방식이 전략적 이점으로 자리 잡을 것으로 확신한다"고 강조했다.