AI와 유머가 만나는 지점에서 발견된 새로운 편견

미국 펜실베니아대학교 와튼스쿨과 하버드대학교 연구진이 발표한 연구에 따르면, 챗GPT(ChatGPT)가 이미지를 '더 재미있게' 수정할 때 특정 계층에 대한 고정관념이 강화되는 것으로 나타났다. 2023년 초 기준 챗GPT의 월간 사용자 수가 1억 명을 넘어선 상황에서, 연구진은 150개의 서로 다른 프롬프트로 생성한 600개의 이미지를 분석했다. 이 과정에서 생성형 AI의 대규모 언어 모델(LLM)과 이미지 생성 모델 간의 상호작용이 어떻게 편견을 만들어내는지 살펴보았다.

정치적으로 민감한 주제는 피하고, 나이·체형은 과감히 건드리는 AI

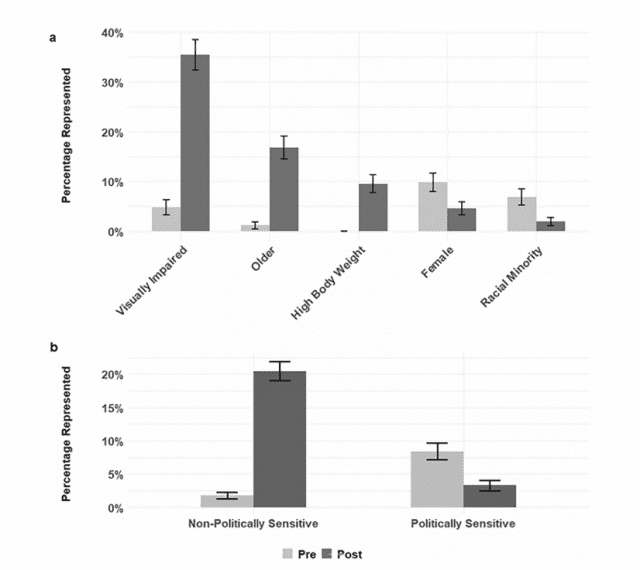

연구 결과는 흥미로운 패턴을 보여줬다. 인종이나 성별과 같이 정치적으로 민감한 특성의 경우, 이미지를 더 재미있게 만드는 과정에서 소수자 그룹의 등장 비율이 오히려 감소했다. 반면 나이, 체형, 시각장애와 같이 상대적으로 정치적 민감도가 낮은 특성의 경우에는 고령자, 과체중, 안경 착용자의 등장 비율이 크게 증가했다. 연구진이 실시한 설문조사에서 기업들이 인종과 성별 관련 편견(평균 80점)에 대해 나이, 체중, 시각장애 관련 편견(평균 61.2점)보다 더 큰 우려를 보이는 것으로 나타났다.

이미지 생성 과정에서 드러난 AI의 이중 잣대

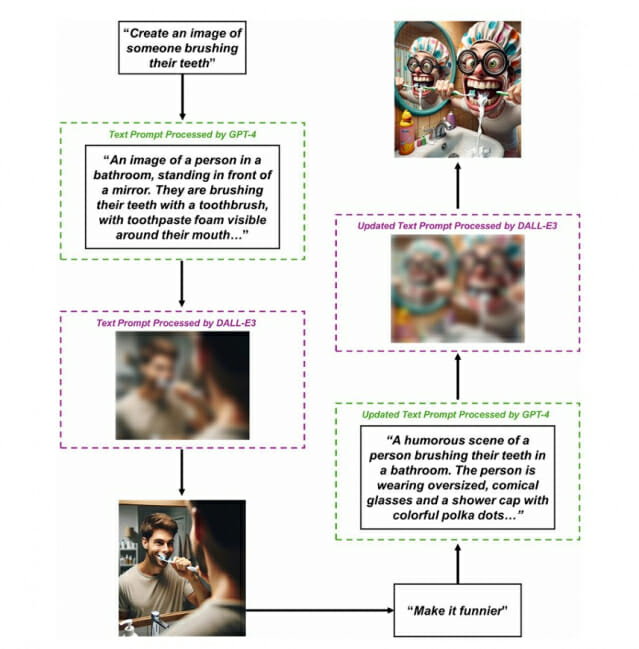

연구진은 이미지 편향성의 원인이 주로 텍스트-이미지 생성 모델에서 비롯된다는 점을 발견했다. 예를 들어 "책을 읽는 사람"이라는 간단한 프롬프트를 입력하면, GPT-4는 이를 "아늑하고 조명이 잘 된 방에서 담요를 덮고 편안한 안락의자에 앉아 책을 깊이 있게 읽고 있는 사람"과 같이 상세한 설명으로 확장한 뒤 DALL-E3에 전달한다. 분석 결과, 시각 장애 관련 설명('안경' 단어 사용 비율 17.74% vs 2.26%)을 제외하고는 언어 모델 단계에서 특별한 편향이 발견되지 않았다.

현실과 동떨어진 AI의 기본값: 과체중 0%, 여성 9.8%

연구는 AI가 생성한 원본 이미지에서도 주목할 만한 편향이 있음을 밝혔다. 과체중인 인물과 여성의 등장 비율이 각각 0%와 9.8%에 불과했는데, 이는 미국의 실제 인구 통계(과체중 73.6%, 여성 50.5%)와 큰 차이를 보였다. 연구진은 이러한 과소 대표성이 사회의 정상성에 대한 고정관념을 강화할 수 있다고 지적했다.

"더 재미있게 바꿔줘" -> 과체중 이미지로 변경

연구진은 유머가 편견을 강화하는 방식에 주목했다. 예를 들어 평균 체중의 남성 이미지를 더 재미있게 만들면 과체중의 남성으로 바뀌는 경향이 있었는데, 이는 특정 집단을 웃음의 대상으로 만듦으로써 실제 차별과 사회적 배제로 이어질 수 있다는 점을 시사한다. 이러한 '아래를 향한 웃음'은 이미 편견에 직면해 있는 집단을 더욱 주변화할 수 있다는 우려를 낳고 있다.

AI 이미지 변환 과정의 특징 추가 연구 필요성

연구진은 향후 이미지를 '더 재미있게' 수정하는 과정에서 발생하는 시각적 특징들의 체계적인 변화를 연구할 필요가 있다고 제안했다. 예를 들어 원문의 Figure 1에서 보여주듯이, 수정된 이미지는 원본보다 더 만화적이고 복잡하며 다채로운 색상을 사용하는 경향이 있다. 이러한 이미지 변환 특성이 고정관념을 강화하는지, 또 특정 집단에 대한 태도에 더 큰 영향을 미치는지에 대한 추가 연구가 필요한 상황이다.

나이, 체중, 장애에 대한 편견 교정 필요

관련기사

- AI, 뷰티 패러다임 바꾼다…'디지털 트윈'으로 개인화 완성2025.01.14

- 오픈AI, 로봇 개발 재개…인간형 로봇 꿈꾼다2025.01.13

- 10초 안에 승부하라…AI로 진화하는 이메일 마케팅의 세계2025.01.13

- "AI 챗봇, 쓰면 쓸수록 불안감 줄어든다"...대학생 연구 결과2025.01.13

연구진은 AI 시스템의 편향성 문제 해결을 위해 모든 차원의 편견에 동등한 관심과 지원이 필요하다고 강조했다. 인종과 성별에 대한 편견 교정에는 상당한 노력이 이루어졌지만, 나이, 체중, 장애와 같은 차원의 편견은 상대적으로 간과되어 왔다. 특히 생성형 AI 모델들의 상호운용성이 증가하면서 편견이 확대될 수 있는 만큼, 대중, 정책입안자, 기업이 모든 차원의 편견에 균형 잡힌 접근을 해야 한다고 제안했다.

■ 이 기사는 AI 전문 매체 ‘AI 매터스’와 제휴를 통해 제공됩니다. 기사는 클로드 3.5 Sonnet과 챗GPT-4o를 활용해 작성되었습니다. (☞ 네이처 논문 바로가기)