구글에서 인공지능(AI)을 활용해 양자컴퓨터의 정확성을 높이는데 성공한 연구가 네이처 저널에 실렸다. 양자컴퓨터 정확성 향상은 실용화를 위해 극복해야 할 핵심문제 중 하나인 만큼 AI를 활용한 성과가 업계의 주목을 받고 있다.

네이처는 21일 구글 딥마인드와 구글 퀀텀 AI 연구팀에서 발표한 '양자 프로세서를 위한 고정확도 오류 디코딩 학습' 논문을 게재했다.

이번 논문은 구글에서 개발한 '알파큐비트(AlphaQubit)'를 활용해 양자 오류 정정 문제를 해결한 성과가 담겼다.

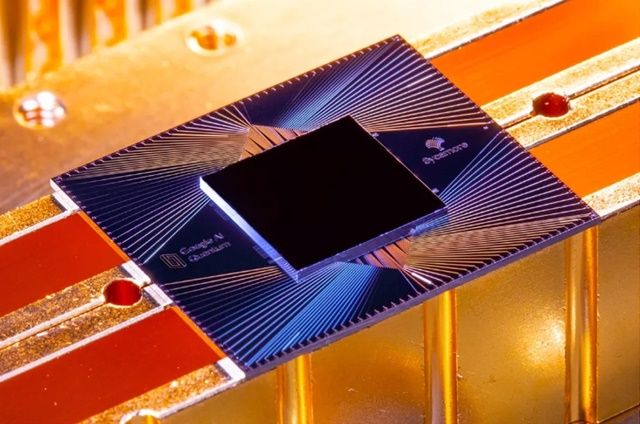

논문에 따르면 알파큐비트는 구글의 양자 프로세서 '시커모어(Sycamore)'에 적용한 결과 기존 오류 정정 모델 대비 최대 28% 오류율을 낮추는 데 성공했다. 특히 안정성을 최대한 보장하는 코드거리11의 경우 0.0009% 오류율을 기록했다.

양자컴퓨터 분야에서는 사용화를 위한 최소한의 오류율로 10의 -12제곱을 목표로 한다. 알파큐비트가 달성한 성과는 100만 배 이상 오류율이 높아 상용화 수준은 도달하지 못했다. 하지만 지속적인 학습을 통해 성능을 향상시킬 수 있는 AI 특성상 앞으로 정확성은 더욱 높아질 전망이다.

양자 컴퓨터는 얽힘, 중첩 같은 양자역학을 기반으로 한 미래형 슈퍼컴퓨터다. 처리 프로세서 구조부터 기존 컴퓨터와 달라 그동안 풀 수 없는 복잡한 문제를 해결할 잠재력을 가지고 있다.

다만 프로세서 연산에 활용되는 큐비트가 외부 환경에 극히 민감해 쉽게 오류가 발생할 수 있는 것이 단점이다. 이에 구글의 시커모어는 우주에서 떨어지는 우주선(cosmic rays)까지 차단할 수 있는 환경을 구축하고 절대영도에 가까운 냉각환경을 마련해야 한다.

알파큐비트는 이런 양자컴퓨터의 오류율을 낮추기 위한 딥러닝 기반의 양자 오류 정정 디코더다. 트랜스포머 기반의 신경망 구조를 기반으로 시커모어 데이터를 기반으로 학습 및 테스트를 거쳤다.

학습과정은 시뮬레이션 데이터를 활용해 초기 모델을 학습시키는 사전 훈련과 시커모어의 실제 실험 데이터를 활용해 성능을 향상시키는 미세 조정(Finetuning) 두 단계로 진행됐다.

관련기사

- 구글, 엔비디아 슈퍼컴으로 양자컴퓨팅 개발한다2024.11.19

- 양자컴퓨터 국내 첫 도입한 연세대…IBM과 불치병 잡을까2024.11.20

- MS, 세계 최초 양자컴퓨터 논리적 큐비트 24개 달성…상용화 눈앞2024.11.20

- 2천700조 양자컴퓨터 시장, 국내기업 사업 기회는?2024.10.11

딥마인드 연구팀은 목표치인 10의 −12제곱 수준의 오류율 달성을 위해 추가적인 AI 학습을 비롯해 외부 접근을 차단하기 위한 하드웨어 환경 조성에 집중할 계획이다.

구글 딥마인드와 퀀텀 AI 연구팀은 "아직 목표 수치에 비해 오류율이 높지만 다른 방식에 비해서는 훨씬 빠르게 높은 성과를 내고 있다"며 "외부 접근을 차단하기 위한 하드웨어 연구와 함께 AI를 지속해서 학습시킨다면 머지않아 목표치를 달성할 수 있을 것"이라고 밝혔다.