"챗GPT는 '컵'이라는 단어를 알지만 컵의 구체적 용도를 모릅니다. 사람이 이를 일일이 데이터로 가르쳐야 합니다. 인공지능(AI)이 더 발전하려면 AI에 팔과 다리가 생겨야 합니다. AI가 연구실 밖에서 직접 물체를 보고 만져야 고품질 데이터(지식)를 습득할 수 있을 겁니다."

서울대 장병탁 교수는 지난 2일 개최한 한국정보처리학회 창립 30주년 기념 글로벌 컨퍼런스 특별강연에서 이같이 강조했다.

장병탁 교수는 현재 생성형 AI가 새로운 시대를 열었다고 밝혔다. 장 교수는 "많은 데이터를 한데 모아 학습한 파운데이션 모델이 큰 역할을 했다"고 전했다. 파운데이션 모델은 오픈AI의 'GPT', 구글의 '팜', 네이버의 '하이퍼클로바X'를 일컫는다.

장병탁 교수는 "현재 학계를 비롯한 다양한 산업계는 생성형 AI 모델로 업계 문제 해결 시간을 획기적으로 줄일 수 있었다"고 설명했다. 장 교수는 "현재 텍스트 데이터로 이뤄진 모델이 많지만 앞으로 이미지, 음성, 센서 데이터 기반 파운데이션 모델도 많이 만들어질 것이다"고 내다봤다.

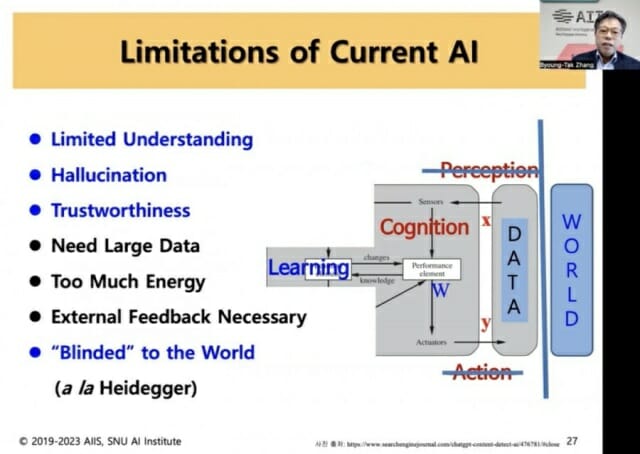

장병탁 교수는 생성형 AI 한계점을 해결해야 하는 시점이 왔다고 주장했다. 그는 "그동안 AI가 연구실 안에서만 데이터를 학습했다"며 "반쪽짜리 지식으로 결과물을 생성하고 있다"고 지적했다. AI가 방대한 데이터를 학습했지만, 이를 100% 다 이해하지 못했다는 말이다.

예를 들어, 챗GPT는 컵이라는 단어를 알고 있다. 챗GPT가 직접 컵을 센서 기술로 만져보거나 본적은 없다. 세상 속 지식에 대한 이해를 100% 할 수 없는 셈이다. 그는 "AI의 반쪽짜리 지식이 환각 현상을 부추겼다"고 꼬집었다.

그는 AI 모델에 더 풍부한 데이터가 필요하단 점도 알렸다. 현재 대부분 데이터가 텍스트 위주로만 수집되고 있다는 이유에서다. 그는 "오픈AI의 달리3 등이 나왔지만 세상 모든 이미지를 정확히 이해·생성하려면 아직 멀었다"며 "이 외에 센서나 음성 데이터 등도 아직 많이 필요하다"고 강조했다. 생성형 AI 모델에 대한 끊임없는 피드백 필요성도 덧붙였다.

"AI, 직접 물리적 세상 느껴야"

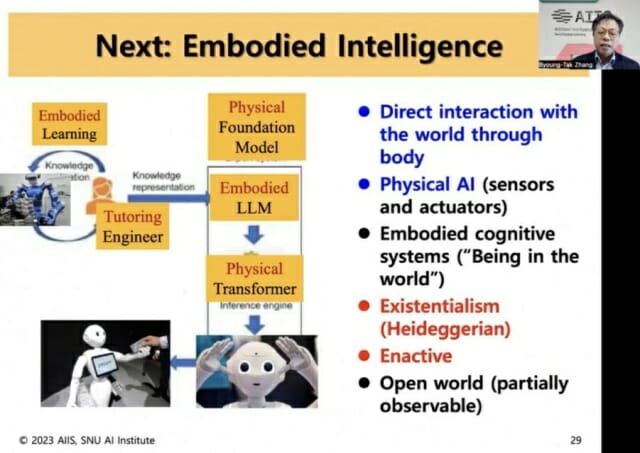

장병탁 교수는 생성형 AI에 팔과 다리가 필요한 시점이라며, 연구실 대신 세상 속에서 직접 부딪히면서 데이터 학습을 해야 한다고 말했다.

장병탁 교수 설명에 따르면, 지금까지 생성형 AI의 데이터 학습은 연구실에서만 진행됐다. AI가 현실과 철저히 분리된 상태에서 연구실에서만 단어와 이미지 데이터 등을 학습한 셈이다.

장 교수는 "생성형 AI가 몸을 가지고 세상과 직접 상호작용 해야 한다"며 "스스로 지식을 체득하고, 이를 기반으로 더 정교하고 정확한 생성물을 사람에게 제공할 수 있을 것"이라며 "현재 AI가 스스로 데이터를 만들 순 없다"며 "AI가 몸을 가지고 직접 행동, 지각, 교정할 수 있다면 스스로 고품질 데이터까지 만들어낼 수 있을 것"이라고 예측했다.

앞으로 생성형 AI가 내부적으로는 거대언어모델(LLM)과 초거대 이미지·센서 모델을 갖추고, 물리적으로는 주행 가능한 팔·다리를 장착할 필요가 있다는 말이다. 이를 통해 사람과 자연스럽게 대화를 하고, 명령에 따라 미션을 하나하나 수행하면서 지식을 습득하고 더 똑똑한 AI로 거듭날 수 있다. 장병탁 교수는 미래의 생성형 AI 모습을 이같이 그렸다.

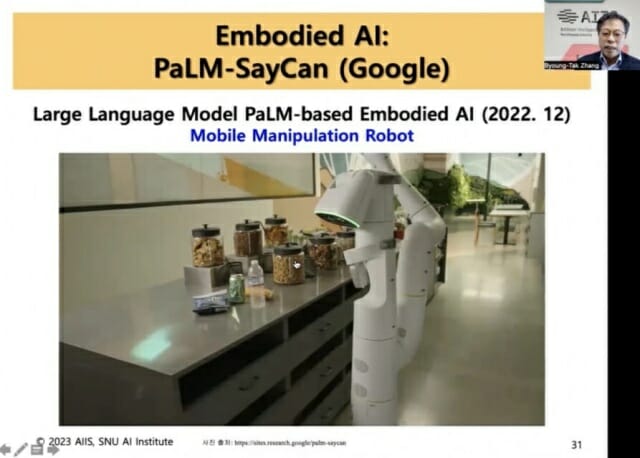

장 교수 설명에 따르면, 해당 연구는 벌써 이뤄지고 있다. 지난해 구글은 LLM을 비롯한 이미지·센서 데이터를 탑재한 로봇을 훈련하는 연구를 진행하고 있다. 연구원이 "부엌에 가서 찬물이 담긴 물병에서 물을 반만 따라서 갖고 와"라고 명령하면, 로봇은 이를 LLM으로 인식하고 센서 데이터와 각종 기술을 활용해 주변을 탐지한다. 그 후 명령어에 맞는 물병을 집어 물을 정확히 반만 따라서 연구자에게 갖다주는 식이다.

관련기사

- 생성AI, 미세조정보다 프롬프팅이 나을 수 있다2023.12.04

- 얀 르쿤 메타 AI 총괄 "AI, 인간과 경쟁하려면 수십 년 걸려"2023.12.04

- "구글, AI 모델 '제미니' 내년 초 공개"2023.12.03

- 챗GPT 탄생 1주년…신세계 열었지만 해결 과제도 늘어2023.12.01

장병탁 교수는 "AI가 실제 세계에서 물병을 만져보고 용도까지 직접 체험하는 셈"이라며 "단순히 물병이라는 단어만 알고 있는 것과는 차원이 다르다"고 했다. 올해 3월부터 서울대에서도 관련 연구를 시작했다.

그는 AI가 연구실 밖에서 나와 세상 속에서 직접 부딪히면서 데이터를 학습할 경우 생성형 AI 고질병인 환각 현상도 줄일 수 있을 것으로 봤다. 그는 "AI는 시각적 능력을 비롯한 언어 능력, 행동 능력을 결합해 세상에 대한 이해를 높일 수 있을 것"이라며 "직접 체득하고 얻은 데이터를 통해 더 정확하고 정교한 결과물을 생성할 것"으로 봤다.