미국 연구자들이 노래를 들을 때 뇌에 나타나는 반응을 기록하고, 이를 인공지능에 학습시켜 음악을 재구성하는데 성공했다.

뇌가 음악을 처리하는 과정에 대한 이해를 높일뿐 아니라, 신경장애로 말을 하지 못하는 사람이 보다 자연스럽게 의사소통할 길을 열 것으로 기대된다.

미국 캘리포니아주립 버클리대학 연구진은 록밴드 핑크플로이드의 히트곡 '어나더 브릭 인 더 월, 파트 1 (Another Brick in the Wall, Part 1)'을 들을 때 나타난 뇌 신호 기록을 분석해 이같은 결과를 얻었다. .

■ 노래 들을 때 나타나는 뇌 신호 분석해 노래 재구성

이 기록은 간질 환자 29명이 뇌에 전극을 심는 수술을 받는 동안 노래와 말소리를 들려주고, 전극에서 나타난 신호를 측정한 것이다. 2008년과 2015년 수집되어 뇌 신호를 기반으로 언어를 재구성하는 연구에 쓰였으며, 최근 AI 기술 발달에 힘입어 이번에 음악까지 재구성했다.

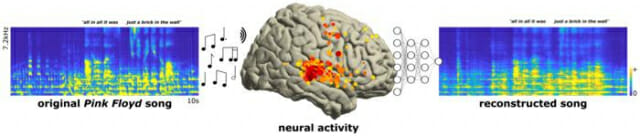

연구진은 노래를 들려주며 측정한 뇌 신호 기록을 인공지능에 학습시키고, 이를 기반으로 뇌 신호를 다시 노래로 만들어내게 했다. 그 결과, 노래 중 'All in all it was just a brick in the wall'이란 부분을 실제 노래와 비슷하게 재현했다. 리듬과 가사가 많이 뭉개지긴 했으나, 식별 가능한 수준은 되었다.

로버트 나이트 버클리대 교수는 "이 연구를 통해 뇌의 음악 처리에 대한 이해라는 큰 벽에 작은 벽돌 하나를 더 놓았다"라고 말했다. 이 연구는 학술지 'PLOS 바이올로지(PLOS Biology)'에 최근 실렸다.

음악은 리듬과 강세, 음조 등 운율 요소를 통해 말로는 잘 표현할 수 없는 감정을 전달할 수 있다. 이 연구를 활용해 향후 루게릭병 환자처럼 마비나 신경 장애 등으로 언어 표현을 못 하는 사람이 음악적 요소를 넣어 보다 자연스럽게 소통할 수 있을 것으로 연구진은 기대했다.

현재의 언어 구현 기술은 단어 단위로 언어를 재구성하기 때문에 마치 고 스티븐 호킹 박사가 쓰던 언어 장치처럼 로봇같은 부자연스러운 음성이 나온다.

■ 언어는 좌뇌, 음악은 우뇌?

연구진은 기술 발전에 따라 언젠가 두개골을 열지 않고 머리 외부에 전극을 설치해도 뇌 심층부에서 나오는 신호를 정확하게 얻을 수 있으리란 기대도 비쳤다. 비침습적 뇌전도는 현재 한 글자를 처리하는데 20초 정도 시간이 걸리고 정확도도 낮아 실생활에 적용하기엔 무리가 따른다.

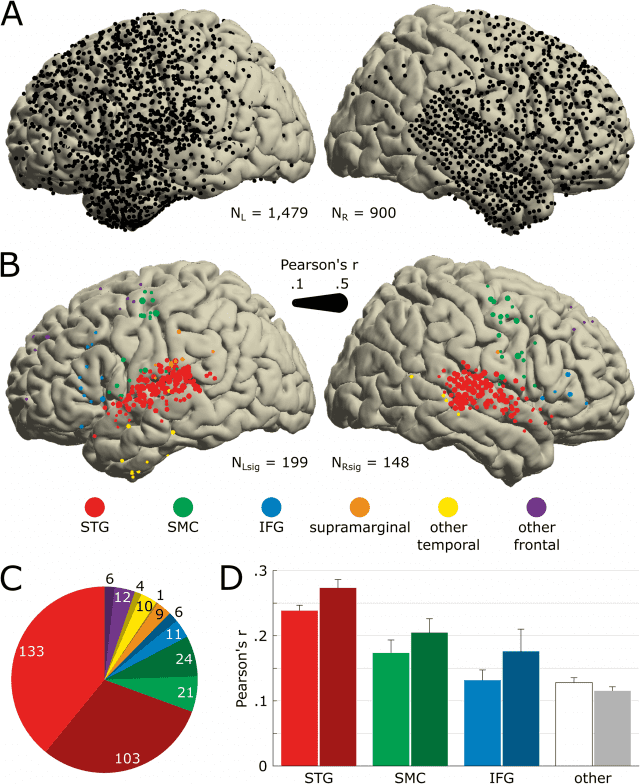

이와 함께 연구진은 29명의 간질 환자 뇌에 심긴 2천 668개의 전극 신호를 분석, 음악과 관련 있는 뇌 부위를 식별했다. 상측두회(Superior Temporal Gyrus)와 감각운동피질(Sensory-Motor Cortex), 하전두회(Inferior Frontal Gyrus) 등 3군데에 설치된 전극에서 나오는 신호가 주로 음악과 관련돼 있었다.

관련기사

- 머리 속 생각 읽는 AI 나왔다2023.05.02

- 노래에 반응하는 뇌 영역 따로 있다2022.02.23

- 생각만으로 로봇 팔 움직인다...사지 절단 장애 극복에 한걸음 더2022.10.24

- 대기업 이탈 속 국대 AI 패자부활전 개막…"기준 미달 시 선정 무산"2026.01.23

상측두회는 노래나 악기의 시작 부분에서 주로 반응을 보였고, 다른 두 부분은 이어지는 보컬에 주로 반응했다. 상측두회는 리듬에 반응하는 부분이기도 했으며, 이 부분의 전극을 제거했을 때 재구성된 음악의 품질이 가장 안 좋아졌다.

또 뇌의 오른쪽 반구가 왼쪽에 비해 음악 관련 활동에 더 많이 관여하는 것으로 나타났다. 언어가 뇌의 왼쪽 반구와 주로 관련돼 있는 반면, 음악에 대한 기능은 양측에 보다 퍼져있다는 것이다.