국내외 인공지능(AI) 빅테크들이 'AI 레드팀'에 많은 공을 들이고 있다. 미국 기업뿐 아니라 국내 기업들도 비슷한 행보를 보이고 있다.

일반적으로 레드팀은 소프트웨어(SW) 보안 강화 역할을 하는 팀이다. 실제 사이버 공격처럼 자사 SW를 직접 해킹해 취약점을 분석하기도 한다. 도출한 연구 결과를 SW 개발자에게 전달해 보안 강화 대책을 세우는 작업을 돕는다.

AI 레드팀은 여기서 한발 더 나아간다. SW 취약점 찾는 것뿐 아니라 AI 제품에 대한 윤리성, 신뢰성 향상을 위한 연구까지 진행한다. AI가 유해한 결과물을 생성하지 않도록 하기 위해서다.

생성 AI가 각광을 받으면서 'AI 레드팀'의 중요성이 더 커지고 있다. 환각 현상을 비롯한 편향성, 비윤리적 답변, 보안 등 생성 AI의 부작용을 시급하게 해결해야 하기 때문이다.

구글의 로얄 한센 개인정보보호안전 및 보안엔지니어링 부문 부사장은 8일(현지시간) 워싱턴포스트(WP)와 인터뷰를 통해 "AI 레드팀은 잠재적인 AI 위험을 식별, 해결할 수 있다"며 "올해 들어 역할과 중요성이 더 커졌다"고 말했다.

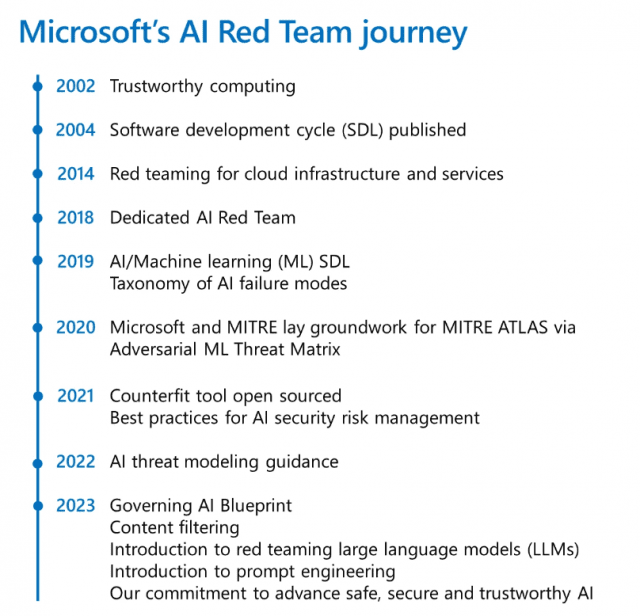

미국 빅테크 중 AI 레드팀을 가장 먼저 만든 것은 마이크로소프트다. 2018년 출범한 마이크로소프트 AI 레드팀은 AI 시스템 취약점을 식별하고 대응하는 방법을 연구한다. 워싱턴포스트에 따르면, 마이크로소프트 AI 레드팀은 AI 챗봇 '빙' 개발부터 배포 전 과정에 긴밀하게 협력했다. 또 이 회사는 생성 AI를 탑재한 제품을 출시하기 전 AI 레드팀 테스트를 반드시 거치는 정책까지 만들었다.

해당 팀 구성원은 AI 시스템 보안을 측정하는 도구도 개발했다. 2020년 산학 협력을 통해 AI 시스템 위협을 탐지, 대응, 완화할 수 있는 SW 툴을 만들었다. 같은 해 AI 시스템 보안을 자동으로 테스트하는 툴도 오픈소스로 공개했다. 올해 초에는 'AI 보안 스캐너'를 깃허브에 공개했다. 마이크로소프트 측은 다양한 툴 개발을 통해 다른 기업들도 AI 보안과 안전성을 개선할 수 있도록 돕겠다는 입장이다.

구글도 AI 레드팀을 운영하고 있다. 외신 보도에 따르면, 구글 AI 레드팀은 거대언어모델(LLM)과 AI 알고리즘 악용 사례 포착에 초점 맞췄다. 현재 LLM 모델 데이터셋을 조작하거나 프롬프트로 해킹하는 경우의 수를 잡아내는 방법론을 연구 중이다.

구글 AI 레드팀은 AI 알고리즘을 정치적 목적으로 악용하지 못하게 돕는다. 일반적으로 해커는 알고리즘 맹점을 찾아 조작할 수 있다. 모든 결과가 자신에게 유리하게 나오도록 알고리즘을 꾸밀 수 있다는 의미다. 이를테면 알고리즘의 허점을 활용해 특정 정치 정보가 더 많이 노출되도록 할 수도 있다. AI 레드팀은 이런 약점을 찾아내 알고리즘을 악용하지 못하도록 한다.

오픈AI도 올해 AI 레드팀을 꾸렸다. 본격적인 활동은 멀티모달 모델 GPT-4 연구 시점부터다. 기존 챗GPT에 탑재된 GPT-3.5 모델이 해킹, 악용에 취약했다는 이유에서다. 해당 기업 AI 레드팀도 GPT-4가 악용될 수 있는 경우의 수를 지속적으로 연구했다.

성과도 이뤘다. 이 팀은 GPT-4가 특정 회사 직원에게 피싱 메일을 작성할 수 있는 기능을 발견했다. 현재 관련 데이터셋과 알고리즘을 삭제한 상태다.

국내 기업 네이버도 레드팀을 통해 AI 신뢰성과 보안을 끌어올리고 있다. 네이버클라우드 하정우 AI혁신센터장은 최근 본지와 진행한 인터뷰에서 "레드팀은 AI 신뢰성과 윤리에 대한 정의를 내리는 일부터 시작한다"며 "믿을 수 있고 윤리적인 AI란 무엇인지 알아내는 연구를 한다"고 설명했다.

관련기사

- 마이크로소프트의 AI 안전 자율규제 약속 6가지2023.07.31

- 구글·MS, AI 안전표준 함께 만든다…오픈AI도 동참2023.07.27

- SAP "클라우드에 생성 AI 솔루션 안전히 접목"2023.07.04

- 네이버 초거대 AI '하이퍼클로바X', 어떻게 만들었나2023.07.19

하정우 AI혁신센터장는 "이를 통해 어떻게 데이터를 만들고, 어떻게 AI 문제점을 개선할 것인지 논의한다"고 말했다. 하 센터장 설명에 따르면, 해당 팀은 이달 공개될 네이버 초거대 AI 모델 ‘하이퍼클로바X’ 개발 과정에서도 신뢰성과 윤리 강화에 힘썼다.

그는 "네이버 레드팀은 AI 기능 향상과 별개로 '믿고 쓸 수 있는 AI'에 초점 맞춘다"며 "이를 통해 더 올바르고 윤리적인 AI 모델과 제품을 만들 수 있을 것"이라고 강조했다.