머리 속 생각을 읽고 문장으로 나타내는 인공지능(AI) 모델이 나왔다.

기능적 자기공명 영상(fMRI) 장비를 이용, 뇌에 전극을 꽂지 않고도 뇌 언어 영역의 활동을 탐지하고 이를 해독해 내용을 거의 정확하게 제시할 수 있다. 의식은 있지만 언어 기능에 문제가 있는 사람들에게 유용하게 쓰일 수 있다.

이 연구 결과는 학술지 '네이처 뉴로사이언스(Nature Neuroscience)'에 1일(현지시간) 실렸다. (☞ 관련기사 바로 가기)

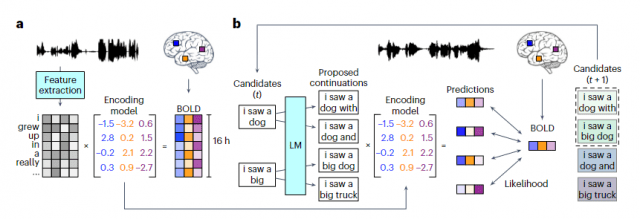

미국 텍사스대학 연구진은 자원자 3명을 fMRI 장비에 넣고 16시간 동안 이야기 팟캐스트를 들려주며 뇌 피질 영역의 활동을 기록했다. 이를 통해 듣는 내용의 의미와 뇌 활동 사이의 관계를 탐지하고, 이 데이터를 AI 모델에 학습시켰다.

이 AI 모델은 오픈AI의 챗GPT나 구글 바드의 기반이 된 구글의 트랜스포머 모델을 일부 활용했다.

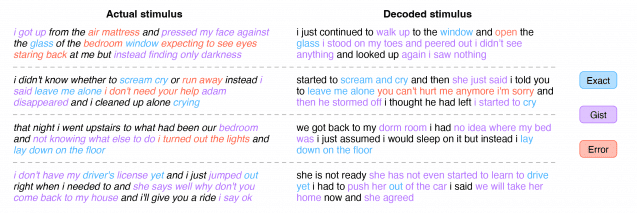

이후 학습에 쓰이지 않은 다른 이야기를 참가자에게 들려주자, 이 때 나온 뇌의 반응을 바탕으로 AI 모델은 이야기의 주요 내용과 의미를 담는 문장을 생성해 냈다. 연구진은 들려준 이야기를 1:1로 옮기는 것이 아니라, 듣거나 생각한 것의 요지를 파악하도록 AI를 훈련시켰다. 잘못된 문장이나 단어를 내놓기도 했으나 대략 이야기의 의미나 쓰인 단어를 비슷하게 재구성해 보여주었다.

참가자가 "아직 운전면허증을 따지 않았어"라는 문장을 들은 경우, AI 모델은 "그는 아직 운전을 배우기 시작하지도 않았어"라는 결과를 내놓았다. "소리를 질러야 할지, 울어야 할지, 도망쳐야 할지 몰랐어. 결국 나는 '날 좀 내버려둬!'라고 말했어"라는 문장을 들려주었을 때엔 "그녀는 소리를 지르고 울기 시작했다. 그러다 '나를 내버려두라 했잖아'라고 말했다"라는 결과를 제시했다.

또 참가자가 머리 속에서 이야기를 상상만 한 경우에도 AI 모델은 이 이야기의 대략적 내용을 문장으로 제시했다. 두 개의 이야기를 동시에 들려주고 이중 하나는 무시하고 한 이야기에만 집중하라고 한 경우, AI 모델은 참가자가 집중해 들은 이야기의 의미를 재구성했다.

참가자들이 짧은 영상을 본 경우에도, AI는 영상의 내용을 재구성했.

뇌 활동을 탐지해 이를 언어로 옮기는 연구는 많이 시도됐으나 정확도를 높이려면 뇌를 열어 전극을 삽입해야 한다는 문제가 있었다. 비침습적 방식은 정확도가 낮고 단어나 짧은 문장밖에 파악할 수 없었었다.

이번 연구 결과는 이같은 한계를 넘어설 가능성을 제시했다는 평가다. 언어 기능에 장애가 있는 사람에게 유용할 전망이다. 또 뇌의 언어 관련 기능에 대한 이해를 높이고, 메타버스 등에 활용할 수도 있다.

관련기사

- 생각만으로 로봇 팔 움직인다...사지 절단 장애 극복에 한걸음 더2022.10.24

- 배양접시에 키운 뉴런, '퐁' 게임 플레이하다2022.10.14

- 머스크, 동물학대 혐의..."뉴럴링크 실험에 1천500마리 떼죽음"2022.12.07

- 삼성전자, '1b D램' 양산에 사활…수율 잡을 TF 가동2024.06.11

이런 기술은 악용될 가능성도 있다. 다른 사람의 생각을 몰래 읽는다거나, 독재국가에서 정치범의 생각을 조사하는데 쓰일 수도 있다는 우려가 나온다.

이에 대해 연구진은 "AI 모델이 학습하려면 참가자가 협조적 태도를 가지고 15시간 동안 fMRI 장비 안에 들어가 이야기에 집중해야 한다. 또 참여자가 의식적으로 다른 생각을 하면 제대로 된 결과를 얻을 수 없다"라며 선을 그었다. 다만 앞으로 기술 발전에 따라 적절한 규제가 필요할 수 있다고 밝혔다.