세계적인 과학 학술지 네이처가 “챗GPT를 과학논문 저자로 인정하지 않겠다"고 선언해 관심을 모으고 있다. ‘네이처’를 출판하고 있는 스프링거 네이처는 지난 24일(현지시간) 온라인 사이트에 올린 사설을 통해 이 같은 사실을 공식화했다.

이번 선언이 관심을 끄는 건 세계적인 학술지가 ‘AI 저자’에 대해 처음으로 명확한 입장을 밝혔기 때문이다.

챗GPT 저자 인정 문제와 관련해 네이처가 내세운 입장은 크게 두 가지다.

첫째. 챗GPT 같은 대규모 언어 모델(LLM)은 논문 저자로 인정하지 않는다.

둘째. 그렇다고 챗GPT를 활용하는 걸 반대하지는 않는다. 다만 챗GPT를 활용해서 논문을 썼을 경우엔, 어느 정도 기여했는지 명확하게 밝히라.

■ 논문 저자는 쓰는 것보다 더 많은 능력이 요구된다

대규모 언어 모델(LLM)은 특정 분야에선 인간이 범접하기 힘든 능력을 발휘한다. 이를테면 법률 분야에서도 판례 분석 같은 영역은 사람보다는 AI가 훨씬 더 뛰어난 성과를 낼 수 있다.

이런 상황에서 네이처는 왜 챗GPT를 과학 논문 저자로 인정하지 않겠다고 선을 그은 것일까? 바둑처럼 인간의 능력을 넘어선 AI 기술을 막기 위한 조치일까? 과학 연구 영역은 인간의 고유의 영역으로 남겨 두려는 것일까?

그래서 ‘네이처’가 이번 조치를 공지하면서 내세운 이유를 살펴봤다. 그리고 "네이처의 결정을 편협하게 볼 것만은 아니다"는 결론을 내리게 됐다. 충분히 따져볼만한 부분이란 생각이 들었다.

논문 저자로 인정받기 위해선 몇 가지 조건을 충족해야 한다. 논문을 쓰는 것 외에 몇 가지 기능이 더 필요하다.

학술지에 논문을 게재하기 위해선 ‘동료 평가(peer review)’를 통과해야만 한다. 이 과정에서 심사자와 긴밀하게 소통해야 한다. 수정 요구가 있을 땐 적절하게 수정해야 하며, “이런 저런 이유 때문에 이렇게 했다”고 설명해야 할 때도 있다. 때론 언론에 자신의 연구 결과를 설명해야 할 때도 있다.

그런데 챗GPT 같은 AI 툴들은 이런 과정을 제대로 수행하기 힘들다는 게 네이처의 설명이다. 단순히 논문을 쓰는 행위만으로는 과학 논문 저자의 필요충분 조건이 될 수 없다는 것이다.

다른 과학자들의 질문과 소통하고, 때론 언론을 상대로 자신의 연구 결과를 설명해야 하는 경우도 있는 데, 챗GPT 같은 AI 프로그램은 이 부분이 취약할 수밖에 없다는 것이다.

게다가 저작권법도 아직은 AI를 저작자로 인정하지 않고 있다. AI 자체는 자신이 작성한 논문이나 각종 예술작품의 저작권을 주장할 수 없다.

그렇다면 AI를 저작자로 인정하기로 공감대가 형성된다면 사정이 달라질까?

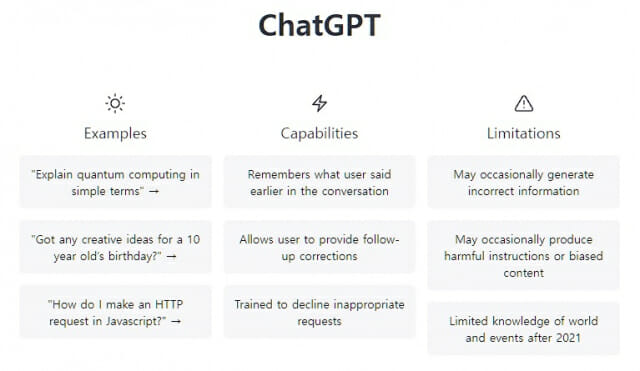

이 질문에 대해서도 네이처는 부정적인 답변을 내놓고 있다. AI 글쓰기 소프트웨어는 아직 한계가 많다는 것. 특히 AI가 성차별이나 인종차별 같은 편견을 확대 재생산할 수도 있다는 것이다.

네이처는 또 "AI가 ‘그럴 듯한 헛소리(plausible bullshit)’를 양산하는 경향도 있다"고 지적했다. 실제로 최근 미국 IT매체 씨넷은 챗GPT를 활용해 기사를 작성하는 실험을 하다가 중단했다. 쓴 기사의 절반 가량에 오류가 포함돼 있는 것으로 나타났기 때문이다.

이런 문제보다 더 중요한 건 ‘투명성'이다. 논문 심사자들은 논문 저자가 ‘성실하고 양심적으로 연구를 수행했다’는 전제 하에 내용을 살펴본다. 과학자 커뮤니티는 연구 부정이나 데이터 조작이 없다는 믿음 위에 구축된 공동체다. 대신 연구 부정이나 데이터 조작 사실이 드러나면 가혹할 정도로 엄격한 책임을 묻는다.

그런데 AI는 이런 부분에서 아직은 한계를 가질 수밖에 없다. 연구의 투명성을 담보하기 힘들기 때문이다. 네이처가 “챗GPT 같은 도구가 과학적 연구의 투명성을 위협한다(Tools such as ChatGPT threaten transparent science)”고 강조한 것은 이런 점과 관련이 있다.

과학 분야는 아니지만, 논문을 써 본 입장에서는 네이처의 주장에 일정 부분 동의한다. 최소한 지금 학계가 요구하는 논문 틀에는 맞지 않는 부분이 적지 않다. 네이처 지적대로, 눈문을 쓰는 것만으로 저자의 책임을 다했다고 보기는 힘들기 때문이다.

■ 챗GPT 때문에 비교문학계의 원거리 읽기 논쟁 다시 생각하다

과학이 아닌 다른 분야에선 어떨까? 이를테면 문헌 분석 같은 다른 영역에선 네이처와는 다른 판단을 할 수 있지 않을까? 인간이 감히 도전하지 못하는 과제를 챗GPT가 풀어낼 수도 있기 때문이다.

문학 영역을 예로 들어보자. 프랑코 모레티라는 비교 문학자가 있다. 그는 문학연구 방법론으로 ‘원거리 읽기(distant reading)’를 적극 도입해야 한다고 주장한다.

복잡한 그의 논지를 단순화하면 이렇다. 인류 역사에는 엄청나게 많은 ‘문학적 정전’이 있다. 우리가 인류의 고전이라고 선정한 작품들이다. 그런데 이런 작품들 외에도 연구해야 할 대상이 엄청나게 많다. 그 분량이 워낙 방대하기 때문에 한 연구자가 평생 파고 들어도 다 읽어내기 힘들다.

모레티가 "문학 작품을 분석할 때 '꼼꼼하게 읽는(close reading)' 방법 뿐 아니라, 다른 사람이 읽은 결과를 적극 수용하는 원거리 읽기도 활용할 필요가 있다"고 주장하는 것은 이런 한계를 극복하기 위한 조치다. 이런 간접 읽기를 적극 수용해야만 문학사의 전모를 제대로 밝혀낼 수 있다는 것이다.

챗GPT가 이런 한계를 극복하는 데 큰 힘이 될 수도 있다. 방대한 문헌을 읽은 뒤 뭔가 새로운 연구 결과를 찾아냈다면 어떻게 해야 할까? 사람 연구자가 전체 연구 설계를 한 뒤 챗GPT가 분석 작업을 수행했을 경우에도 공동 연구자로 볼 수 없는 것일까?

관련기사

- 챗GPT 작성 논문에 대한 제재는 반드시, 언제나, 옳을까2023.01.27

- 버즈피드 "챗GPT로 맞춤형 콘텐츠·퀴즈 만든다"2023.01.27

- 챗GPT, 21세기 대학에 경고장을 보내다2023.01.19

- 챗GPT, 정신 치료 가능할까...전문가 "시기상조"2023.01.19

이렇게 질문을 던져 놓고 보니, 네이처가 사안을 너무 단순화한 것일 수도 있겠다는 생각도 든다. 다만 이 때도 심사자들의 '검증 범위'를 벗어나고, 질의 응답이 불가능하다는 한계는 여전히 남는다.

그래서 다시 곰곰 따져 보니, 챗GPT 같은 LLM을 연구자로 선뜻 받아들이는 것도 간단한 문제는 아닌 것 같다는 생각이 든다.