KAIST(총장 이광형)는 바이오및뇌공학과 정재승 교수 연구팀이 3차원 공간에서 생각만으로 로봇 팔을 정확하게 조종하는 '뇌-기계 인터페이스 시스템'을 개발했다고 23일 밝혔다.

뇌 활동에 나타난 사람의 의도를 파악해 로봇이나 기계가 대신 행동에 옮기는 뇌-기계 인터페이스 기술이 로봇이나 드론, 컴퓨팅, 메타버스 등의 차세대 인터페이스로 주목받고 있다. 하지만 '손을 움직인다' 정도의 의도를 넘어 팔 움직임의 방향에 대한 의도를 섬세하게 파악해 로봇 팔을 움직이는 기술은 아직 정확도가 높지 않다. 움직일 수 있는 방향도 2-3개로 제한적이다.

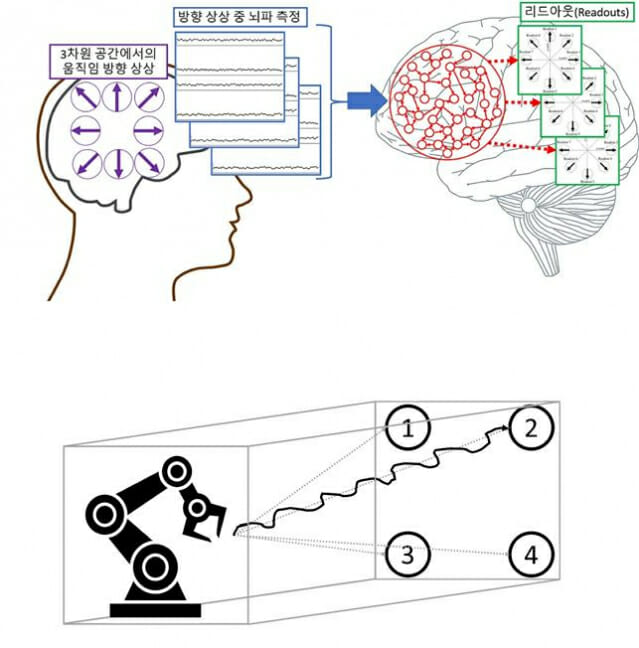

연구팀은 조종 '방향'에 대한 의도를 뇌 활동만으로 인식하는 인공지능 모델을 개발, 3차원 공간에서 24개의 방향을 90% 이상의 정확도로 정교하게 해석하는 시스템을 만들었다. 뇌파피질검사(ECoG)를 통해 간질 환자에게서 수집한 뇌파 신호를 측정해 해독하는 역할을 한다.

인공지능 기법 중 하나인 축적 컴퓨팅 기술을 활용, 뇌-기계 인터페이스에 필요한 개개인의 뇌파 신호의 중요 특성을 인공신경망이 자동으로 학습해 찾게 했다. 유전자 알고리즘을 이용해 인공지능 신경망이 최적의 뇌파 특성을 효율적으로 찾을 수 있게 시스템을 설계했다.

이를 통해 사람마다 차이가 크고, 넓은 영역에 있는 신경세포 집단의 전기적 신호 특성을 해석해야 해 잡음이 크다는 뇌파의 한계점을 해결했다.

또 심부 뇌파를 최종 해석하는 리드아웃을 가우시안 모델로 설계, 시각피질 신경 세포가 방향을 표현하는 방법을 모방하는 인공신경망을 개발했다. 이런 리드아웃 방식은 축적 컴퓨팅의 선형 학습 알고리즘을 이용해 성능이 떨어지는 하드웨어에서도 빠르게 학습할 수 있어 일상에서 메타버스나 스마트기기 등에 응용할 수 있게 해 준다.

이 인터페이스로 3차원 공간에서 로봇팔을 움직이는 상상을 할 때의 뇌파를 해석한 결과, 성공적으로 로봇팔을 움직이는 시뮬레이션 결과를 보였다.

이번 연구 결과는 사지마비 환자나 사고로 팔을 잃은 환자를 위한 로봇팔 장착 및 제어 기술을 비롯해 메타버스, 스마트기기, 게임, 엔터테인먼트 등 다양한 분야에 뇌-기계 인터페이스 적용할 가능성을 열 것으로 기대된다.

제1저자인 김훈희 박사는 "공학적 신호처리 기법에 의존해 온 기존 뇌파 디코딩 방법과 달리, 인간 뇌의 실제 작동 구조를 모방한 인공신경망을 개발해 좀더 발전된 형태의 뇌-기계 인터페이스 시스템을 개발했다"라며 "향후 뇌의 특성을 좀 더 구체적으로 이용한 '뇌 모방 인공지능(Brain-inspired A.I.)'을 이용한 다양한 뇌-기계 인터페이스를 개발할 계획"이라고 말했다.

관련기사

- KAIST, 하이드로젤 기반 뇌-기계 인터페이스 개발2021.06.21

- KAIST, 인간 모사형 감각시스템 세계 첫 개발2021.07.12

- 인공지능이 합금 신소재 원소 조합 찾아준다2022.02.21

- 노래에 반응하는 뇌 영역 따로 있다2022.02.23

연구책임자 정재승 교수는 "뇌-기계 인터페이스 시스템은 대부분 고사양 하드웨어가 필요해 실시간 응용으로 나아가기 어렵고 스마트기기 적용이 어려웠다"라며 "이번 시스템은 90%~92%의 높은 정확도를 가진 의도 인식 인공지능 시스템을 만들어 메타버스 안에서 아바타를 생각대로 움직이게 하거나 앱을 생각만으로 컨트롤하는 스마트기기 등에 광범위하게 사용될 수 있다"고 말했다.

이번 연구는 국제학술지 '어플라이드 소프트 컴퓨팅(Applied Soft Computing)' 2022년 117권 3월호에 게재됐다. 논문명은 An electrocorticographic decoder for arm movement for brain-machine interface using an echo state network and Gaussian readout이다.