삼성전자가 메모리 저장장치의 혁신을 통해 인공지능(AI)의 에너지 효율 최적화 지원에 나선다. '인접 메모리 프로세싱' 제품을 앞세워 AI 전력 효율성을 극대화하겠다는 목표다.

1일 온라인으로 열린 '삼성 AI 포럼 2021' 행사의 기술 세션에서 최창규 삼성전자 종합기술원 AI&SW 연구센터장(전무)는 'AI 컴퓨팅의 에너지 효율화 방향'이란 주제로 발표했다.

최 전무는 "수조개의 변수를 가지는 인공지능 모델을 학습하기 위해 엄청난 양의 데이터를 처리해야 하는 과정에서 소비전력 증가가 큰 문제로 떠오르고 있다"며 "다음 세대에 건강한 지구를 물려주기 위해서는 에너지 효율을 최우선으로 하는 지속 가능한 인공지능 컴퓨팅 기술을 위한 혁신적인 아이디어가 필요하다" 강조했다.

최 전무의 발표에 따르면 인공지능 모델을 한번 학습시키는데 약 1.3기가와트시(GWh)를 소비하는데, 이는 한국에서 약 1분간 소비하는 전력량과 동일하다. 게다가 한번 모델을 학습시키는데 발생하는 탄소 배출량은 8만4000대의 차가 하루에 배출하는 탄소의 양과 동하다. 이를 정화하기 위해서는 8천500만 그루의 소나무를 더 심어야 한다.

최 전무는 지금까지 인공지능의 에너지 효율을 증가시키기 위한 노력은 대부분 전용 하드웨어 개발에 집중돼 왔다는 점을 지적했다. 최신 그래픽처리장치(GPU)를 사용하더라도 125조개에 달하는 신경으로 연결된 인간의 뇌처럼 복잡한 학습의 경우에는 아직도 GPU 연산 능력의 10% 미만 밖에 활용하지 못하고 있기 때문이다.

심지어 인공지능 전용 가속기를 사용할 때조차 계산 능력 대비 부족한 메모리의 대역폭으로 인해 성능과 하드웨어 활용률이 떨어진다.

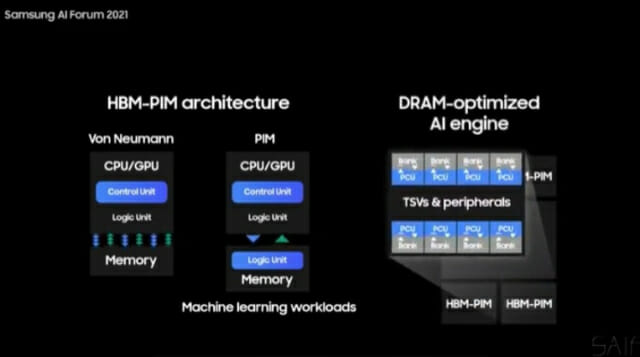

최 전무는 "삼성은 메모리와 저장장치의 혁신을 통해 연산능력과 메모리 대역폭간 격차 문제의 해결을 제시해 왔다"며 "인접 메모리 프로세싱 제품은 프로세서와 메모리 사이의 데이터 이동을 최소화하고 메모리 내부의 대역폭을 효과적으로 활용하는 기술"이라고 소개했다.

삼성전자가 세계 최초로 메모리 반도체와 인공지능 프로세서를 하나로 결합한 'HBM-PIM(프로세싱 인 메모리)'가 대표적인 사례다. HDM-PIM은 D램 셀에 통합된 인공지능 엔진을 통해 메모리뱅크에서 병렬 연산을 실행해 에너지 효율성이 높다.

관련기사

- "삼성전자, 갤럭시S22 양산 시작…내년 초 출시"2021.11.01

- 삼성전자 창립 52주년..."초일류 100년 기업 역사 함께 만들자"2021.11.01

- '삼성 AI 포럼' 개막…"AI로 사회 이슈 해결"2021.11.01

- "AI 컴퓨팅, 스토리지도 고민하라"2021.07.07

또 PIM 개념을 듀얼 인라인 메모리 모듈(DIMM)에 적용한 'AX-DIMM'로 대표적인 기술로 꼽을 수 있다. AX-DIMM은 인공지능 엔진이 DIMM 내의 버퍼 칩에 내장되어 있는 제품이다.

최 전무는 "지속 가능한 인공지능 컴퓨팅과 프로세서-메모리 간의 확장성을 위해서는 전력 효율이 핵심"이라며 "이런 삼성의 혁신과 함께 학계와 산업계도 같은 비전을 가진 연구를 수행하고 있다"고 전했다.