인공지능(AI)은 산업 전반에 걸쳐 빠르게 적용되고 있다. 하지만 여전히 AI 도입을 방해하는 장애물이 존재한다.

대표적인 어려움이 AI 모델 구축을 위한 숙련된 AI 전문가 확보다. AI 모델 구축을 위해선 알고리즘을 해석하고, 방대한 데이터를 정밀하게 다루기 위한 높은 수학적 지식 등이 요구되기 때문이다.

또 대부분의 AI는 결과 도출과정을 공개하지 않는다. 오류가 발생했을 때 원인을 찾아내 해결하기 어렵다는 뜻이다. 이로 인해 금융, 의료 분야에서는 AI 도입에 신중을 기하고 있다.

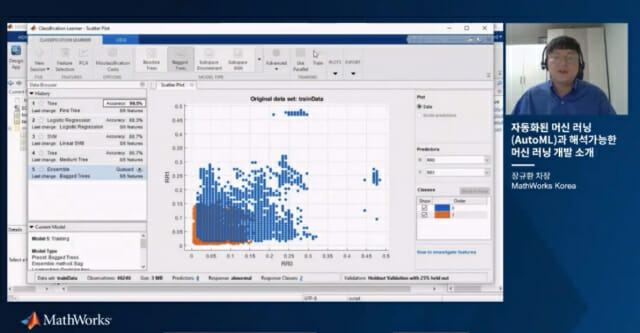

매스웍스코리아 장규환 차장은 이러한 문제를 해결하기 위한 방안으로 매트랩을 이용한 자동화된 기계학습(오토ML)과 해석가능한 ML을 소개했다.

장규환 차장은 최근 온라인으로 진행한 매트랩 머신러닝데이 2021 웨비나를 통해 ‘오토ML과 해석가능한 ML’을 구현하는 방법에 대해 소개했다.

■ 오토ML, 비전문가도 머신러닝 모델 개발

오토ML은 완전 자동화된 머신러닝 모델 개발 프로세스다.

데이터 분석에 가장 적합한 알고리즘을 선택하는 등 최적의 모델링 기법을 선정하기 위한 반복 실험 단계를 제거해 데이터 전처리만 거치면, 모델을 즉시 최적화 및 배포할 수 있도록 지원한다.

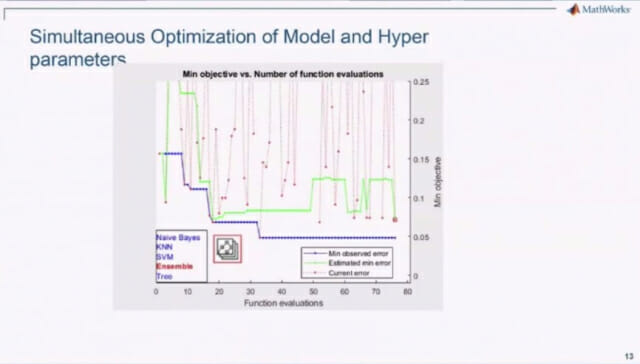

오토ML 구현에 최적화된 매트랩은 머신러닝 개발 프로세스 중 ▲피처 엔지니어링 ▲모델링 ▲하이퍼파라미터 설정 세 단계를 자동화함으로써, 개발 과정에서 리소스 낭비를 최소화한다.

피처 엔지니어링은 웨이블릿 변환, 고속 푸리에 변환을 포함한 피처 선택, 또는 피처 추출 등 다양한 피처 엔지니어링 기법을 손쉽게 지원하는 환경을 제공한다.

모델링은 사용자가 명령어 한 개 만을 사용해 많은 머신러닝 모델링 기법 가운데에서 데이터에 적합한 고성능 모델을 자동 선택할 수 있도록 지원한다.

장규환 차장은 “오토ML은 워크플로에서 어렵고 시간이 많이 걸리는 여러 단계를 자동화할 수 있다”며 “어려운 단계를 단순화한 만큼 도메인전문가도 AI전문가의 도움 없이 최적화된 모델을 구현할 수 있다”고 설명했다.

하이퍼파라미터 설정은 매트랩 환경에서 다양한 모델에 하이퍼파라미터 값을 자동 최적화 및 적용함으로써 고성능의 모델 개발을 지원한다. 하이퍼파라미터 최적화를 위한 수작업 과정과 비교해 시간 낭비를 제거하고 성능 최적화를 보장한다는 장점이 있다.

매스웍스 내부 테스트 결과, 매트랩 오토ML로 개발한 인간 행동 탐지 및 심장 이상 탐지 모델의 성능은 수작업으로 개발한 해당 두 모델의 성능과 비교해도 높은 성능을 기록했다.

또한, 매스웍스는 R2020b부터 업데이트되는 양의 데이터에 대한 학습 및 모델 업데이트를 지원하는 증강 학습을 지원하고 있다.

■ 설명가능한 ML로 블랙박스 현상 제거

현재 AI는 결과값 도출 과정을 설명할 수 없는 블랙박스 현상으로 인해 결과에 대한 신뢰성이 떨어지는 문제점을 겪고 있다. 이러한 문제는 공정성, 윤리적 편향 이슈로도 이어지고 있다.

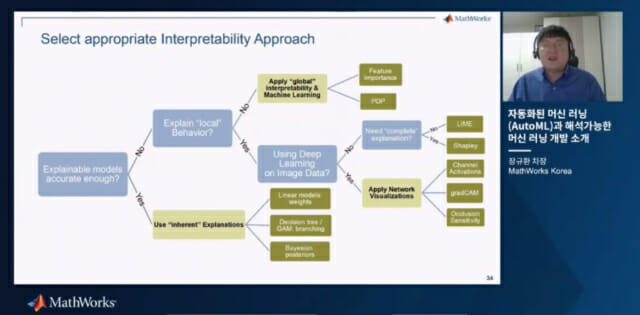

설명가능한 ML은 블랙박스 AI 모델의 신뢰도 문제를 해결하기 위해 제시되는 기법이다. 특정 한 개 모델에 대한 알고리즘 기반의 설명 방식, 그리고 보편적 모델에 대한 전체 데이터 및 특정 데이터 범위 안의 설명 방식을 지원한다.

매스웍스는 피치 선택, 샤플리 값 등 다양한 알고리즘 지원을 통해 모델의 결과값에 중요 역할을 하는 특징 세트를 판별하여 모델의 의사결정 과정을 설명하도록 돕는다.

피처 선택은 모델에 영향을 미치는 주요 특징만을 추출해서 규모가 작으면서도 우수한 성능을 지닌 설명가능한 모델 개발을 지원한다.

분류 과정을 세분화된 계층별로 확인하는 기법을 통해 모델의 의사결정에 중요한 영향을 미치는 피처를 찾고 모델의 분류 결정 과정을 자세히 설명할 수 있다.

일반적으로 예측력이 높은 모델일수록 설명가능성이 낮고, 예측력이 낮은 모델은 설명가능성이 높다. 설명가능성이 낮은 예측력 높은 모델의 경우에도 특정 데이터 범위에 대해서는 설명가능성을 구현하고 성능을 높일 수 있다.

샤플리 값은 게임이론을 적용해서 실험 결과에 영향을 끼친 요소를 중요도별로 판별하는 방식이다.

샤플리 값을 적용하면 중요도에 따른 요소가 그래프로 표시돼 어떤 데이터가 AI에 영향을 줬는지 한눈에 확인할 수 있다.

관련기사

- 매스웍스, 매트랩 및 시뮬링크 릴리스 2021b 발표2021.09.28

- 자율주행 AI인재, 매트랩·시뮬링크로 키운다2021.09.22

- 매스웍스, 매트랩 및 시뮬링크 릴리스 2021a 출시2021.03.16

- 해양 조난자 수색, 드론과 AI로 한다면2020.07.29

게임이론은 게임의 참여자들 간 협업을 통해 창출한 이득을 각 참여자의 기여도에 따라 배분하는 분석이론이다.

장규환 차장은 “매트랩은 이미지도 해석가능한 ML로 분석해 어디에 오류가 있는지 확인할 수 있다”며 “매트랩 온램프를 통해 무료로 테스트해 볼 수도 있으니 많은 관심 부탁드린다”고 말했다.