빅데이터 열풍을 불러왔던 노란코끼리의 행렬은 이제 저멀리 흐릿해지고 있다. 최근 수년 사이 하둡과 관련 기술에 대한 관심은 현저하게 줄었다. 하둡은 죽었는가.

최근 미국 지디넷의 컬럼니스트 토니 베어는 '하둡의 유산: 더 이상 데이터의 두려움은 없다'란 제목의 글에서 하둡 생태계 축소의 시사점을 분석했다.

최근 아파치소프트웨어재단은 독자수 급감을 보이는 하둡 산하 프로젝트 일부를 목록에서 삭제조치했다. 아파치 하둡 생태계가 빅데이터 시장 중심지에서 벗어났다는 걸 보여주는 사례다.

하둡(Hadoop)을 ‘죽었다’고 표현하는 건 이미 오래된 유행이다. 하지만, 하둡이 기업들을 빅데이터에 대한 두려움을 떨쳐낼 수 있는 길로 이끈 것은 분명하다. 또한, 하둡은 혁신의 선순환을 이끌며 오늘날 우리가 알고 있는 클라우드 분석과 AI 서비스라는 거대한 시장을 창출했다.

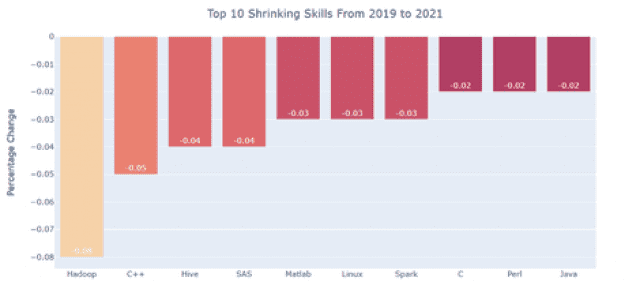

아파치 하둡 관련 컴포넌트들은 10년 전 빅데이터와는 무관하다는 주장을 펴는 사람들이 있다. 실례로 이들은 한 구직 사이트에서 데이터 과학자의 채용을 위한 하둡 기술에 대한 수요가 현격히 감소했다는 이유를 들었다. C++, 하이브 같은 언어 사용자와 스파크, 자바도 마찬가지로 수요가 줄었다. 그리고 이는 데이터 엔지니어들을 대상으로 하는 채용에서도 별반 다르지 않을 것이라는 주장이다.

하둡은 2014년을 기점으로 세계 빅데이터 시장으로 진출했다. 빅데이터의 레이블은 여러 테라바이트 또는 페타바이트 단위의 데이터 결합이 매우 탁월했고, 비관계형 데이터로 분석을 확장할 수 있었다.

오늘날 다중 모델 데이터베이스는 일반적이지만, 대부분의 관계형 데이터 웨어하우스는 JSON 데이터를 구문 분석하고 그래프 데이터 뷰 같은 기능을 추가하는 정도다. 그리고 클라우드 스토리지의 데이터를 직접 쿼리하거나 데이터 웨어하우스에서 쿼리를 결합하는 기능도 보편화됐다.

물론 아파치 소프트웨어 재단의 하둡 관련 몇몇 프로젝트는 종료됐다. 하지만, 일반적인 통념과 달리 하둡은 죽지 않았다. 하둡 생태계의 수많은 핵심 프로젝트들이 클라우데라 데이터 플랫폼(CDP)에서 지속적으로 살아 움직이며, 새로운 제품으로 유지되고 있다. 다만 살아남은 패키지 플랫폼이 CDP 이전에는 존재하지 않았던 것이기 때문에 더 이상 하둡이라고 부르지 않을 뿐이다.

어디서나 자신 클러스터를 개별 오픈소스 프로젝트와 조합한다는 개념은 꽤나 오래됐다. 현재 우리는 아파치 맵리듀스, 하이브, 레인저, 아틀라스 등을 수동으로 적용하는 시대를 지나 이를 대체하는 플랫폼을 사용한다. 이젠 오라클을 구입하더라도 쿼리 최적화 프로그램과 스토리지 엔진을 별도로 설치하지 않는데, 하둡이라고 다르지 않다.

2020년대로 들어선 이후 새로운 프로젝트들은 패키지 소프트웨어를 구입, 설치하는 것보다 클라우드 서비스를 더 선호하고 있다. 클라우드로 전환은 원래 비용 문제에서 출발했지만, 오늘날에는 조직의 관리 영역 측면에서 운영 간소화와 비즈니스의 민첩성이 더욱 강조되고 있다.

오늘날에는 ‘3V(volume, variety, velocity)’라 불리우는 다양한 데이터 분석 방법이 있다. 사실상 데이터 호수가 되어버린 클라우드 오브젝트 스토리지에서 특정 데이터에 쉽게 접근할 수 있다. 아마존 아테나 같은 서비스를 이용해 임시 쿼리를 수행할 수 있고, 대부분의 클라우드 데이터 웨어하우징 서비스를 통해 연합 쿼리 기능도 이용할 수 있다.

데이터브릭스 같은 전용 서비스 또는 애저 시냅스 애널리스틱스 같은 클라우드 데이터 웨어하우징 서비스는 데이터 분석을 위해 스파크를 이용한다. 데이터 웨어하우스와 데이터 레이크 사이의 경계는 모호해지고, 이 때문에 많은 사람들은 데이터 레이크하우스라는 용어를 사용한다.

초기의 하둡이 데이터 엔지니어의 도움을 받아 데이터 과학자들만의 영역이 됐던 것처럼 머신 러닝과 AI도 마찬가지였다. 오늘날 데이터 과학자들은 모델의 라이프사이클을 관리하기 위한 풍부한 툴과 프레임워크를 가지게 됐다. 오토ML 서비스는 데이터 과학에 관심있는 일반인도 머신 러닝 모델을 쉽게 구축할 수 있도록 해주었으며 클라우드 데이터웨어하우스는 SQL 명령으로 촉발되는 자체 패키지 머신 러닝 모델들을 계속해서 추가하고 있다.

10년 전만 해도 이 모든 일들은 불가능할 것처럼 보였다. 선도적으로 연구를 시작한 구글은 구글 파일 시스템을 통해 기존 스토리지 네트워크의 한계를 뛰어넘었다, 구글은 맵리듀스를 통해 선형에 가까운 확장성을 얻었고 기존의 확장 SMP 아키텍처의 한계를 뛰어넘었다.

관련기사

- 하둡의 빈틈 '오브젝트 스토리지'가 노린다2020.04.23

- 클라우데라, AWS·MS 애저에서 DB 플랫폼 상용화2021.03.02

- 클라우데라, 쿠버네티스 기반 데이터 플랫폼 공개2020.06.23

- 클라우데라, 통합 데이터 플랫폼 'CDP' 발표2019.09.29

구글에서 논문을 발표할 당시, 당시 10억 페이지 이상의 분량의 검색엔진 프로젝트를 진행하던 더그 커팅과 마이크 카파렐라는 그 소식을 통해 큰 도움을 받을 수 있었고, 오픈소스를 통해 시스템 구현 비용을 획기적으로 줄일 수 있는 방법도 찾았다. 그 후 커뮤니티의 다른 개발자들은 이 기술에 관심을 가졌다. 한가지 예로, 페이스북은 프로그래밍 언어와 같은 SQL을 제공해 페타바이트 규모의 데이터 세트를 통합하는 하이브를 개발했다.

하둡 프로젝트는 혁신의 선순환을 이끌었다. 하둡이 등장하면서 데이터는 넘쳐났고 넘쳐나는 데이터를 연산하기 시작했다. 값싼 대역폭과 많은 용량으로 가능해진 클라우드 네이티브 아키텍처의 출현으로 컴퓨터와 데이터는 다시 세분화되었다. 하둡의 유산은 혁신에 대한 선순환 뿐만 아니라 방대한 양의 데이터 처리에 대한 두려움 극복이라는 점을 잊지 말아야 할 것이다.