인텔 내부의 선행 기술 연구 조직인 인텔 랩스가 3일(미국 현지시간) 상용화를 염두에 두고 개발중인 5대 선행 기술의 진척 상황을 공개했다.

이 행사는 올 3월 중순 미국 샌프란시스코에서 진행될 예정이었지만 코로나19 여파로 한 차례 연기된 뒤 9개월만에 온라인에서 진행되었다.

이날 기조연설을 진행한 리치 울리그(Rich Uhlig) 인텔 시니어 펠로우는 "현재 컴퓨터 성능의 1천 배 이상을 달성하기 위해서는 반도체간 상호 연결과 연산, 보안 등 광범위한 영역에 대한 연구가 필요하며 인텔 내부 전문가들이 한데 모여 연구를 진행중"이라고 밝혔다.

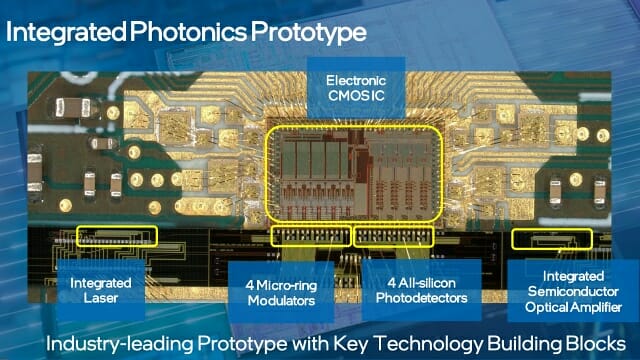

■ 서버간 데이터 광통신으로 연결하는 집적 포토닉스

인텔이 상용화한 썬더볼트 기술은 원래 광통신 기술을 이용해 데이터 전송속도를 높이기 위한 기술인 '라이트 피크'(Light Peak)을 바탕으로 만들어진 것이다. 그러나 구부릴 경우 파손되는 케이블의 한계와 전력 소모 때문에 구리선 기반으로 변경되었다.

현재 인텔은 반도체 기반으로 레이저를 이용해서 데이터센터에 설치된 서버간에 정보를 주고 받는 기술인 '집적 포토닉스'를 연구중이다.

제임스 자우시 차석 엔지니어는 "집적 포토닉스는 기존 전기 신호로 데이터를 주고 받는 기술의 한계를 극복해 입출력 용량을 최대 1천 배 이상 확대할 수 있는 기술"이라고 설명했다.

또 "현재 대역폭 수요는 3년마다 최대 2배 이상 늘어나고 있지만 전기 신호로는 전력 소모를 감당할 수 없으며 이를 해결하기 위해 실리콘 기술에 기반한 소형 광 변조기와 증폭기를 개발하고 있다"고 덧붙였다.

■ 전력 소모 줄이면서 연산 속도 높이는 뉴로모픽 컴퓨팅

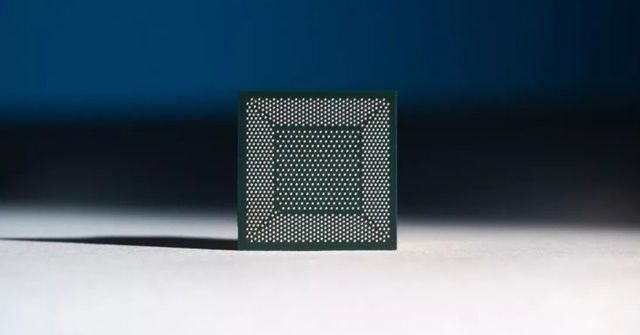

인텔은 2017년 기존 프로세서와 다른 새로운 구조의 컴퓨팅 칩인 '로이히'(Loihi)를 공개했다. 이 칩은 인텔 14nm 공정에서 생산되었으며 뇌세포를 구성하는 뉴런을 모방한 뉴로모픽 코어를 여러 개 내장해 AI에 특화된 연산을 수행한다.

마이크 데이비스 인텔 뉴로모틱 컴퓨팅 연구소 이사는 "현재 자율비행하는 드론은 연산에 많은 배터리를 소모하며 고작 20분만 비행할 수 있지만 왕관앵무는 고작 2g에 불과한 뇌를 이용해서 드론보다 더 빨리, 오래 비행한다"며 로이히 칩의 개발 동기를 소개했다.

로이히 칩은 인텔이 2015년 개발한 뉴로모픽 아키텍처 기반으로 만들어졌다. 인텔이 개발한 연구용 시스템인 포호이키 스프링스(Pohoiki Springs)는 로이히 칩 64개를 내장했고 수백만 개의 이미지 중 원하는 이미지를 기존 프로세서 대비 최대 24배 더 빨리 찾아냈다.

지난 7월 싱가포르 국립대 연구진은 로이히 칩을 로봇에 적용해 축각을 구별하는 연구 결과를 공개하기도 했다. 마이크 데이비스 이사는 "메르세데스 벤츠, 로지텍, 레노버 등이 로이히를 이용한 연구에 협력할 것"이라고 설명했다.

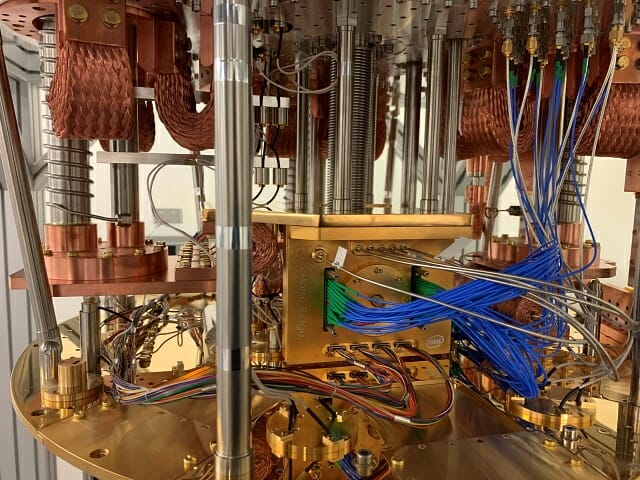

■ 양자 컴퓨터 제어용 칩 '호스리지Ⅱ' 공개

기존 컴퓨터의 비트는 0 또는 1의 상태만 처리하지만 양자 컴퓨터의 기본 계산 단위인 큐비트(qubit)는 0과 1의 상태를 동시에 갖는다. 큐비트 수가 늘어날 수록 더 많은 데이터를 처리할 수 있고 기존 트랜지스터 컴퓨터로 처리할 수 없었던 문제를 해결할 수 있다.

앤 마츠우라 차석 엔지니어는 "100개, 혹은 수천 개 큐비트로는 이런 문제를 해결할 수 없고 수십만 개, 혹은 수백만 개의 큐비트가 필요한데 이를 위해서는 좋은 품질의 양자를 세밀하게 컨트롤하는 기술이 필요하다"고 설명했다.

앤 마츠우라는 "인텔은 그동안 쌓아왔던 트랜지스터 기술을 기반으로 극저온 상태에서 양자 컴퓨터를 제어할 수 있는 칩인 '호스리지Ⅱ'와 함께 양자 컴퓨터 개발을 위한 소프트웨어까지 모든 기술을 함께 연구중"이라고 덧붙였다.

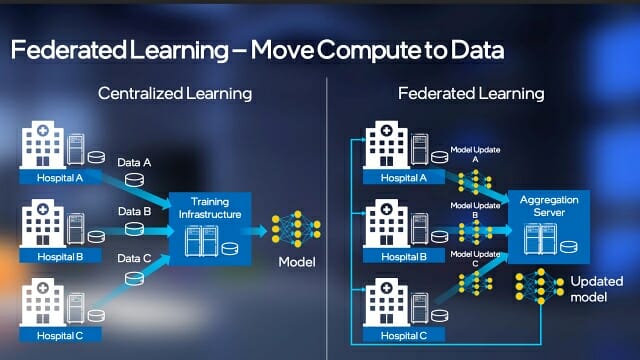

■ 데이터 사일로 한계 넘는 기밀 컴퓨팅

AI는 의료 영상이나 금융 분야에서 많은 성과를 거두고 있다. 문제는 보다 좋은 결과를 얻으려면 많은 데이터를 이용해 학습을 진행해야 하지만 민감한 정보 특성상 데이터를 내보내지 못하고 담아 두는 '데이터 사일로' 현상이 나타난다는 것이다.

제이슨 마틴 수석 엔지니어는 "의료 영상 데이터가 아니라 이를 처리하는 머신러닝 모델만 한데 모아서 학습하는 새로운 방법인 '연합 학습'을 이용하면 데이터 사일로의 한계는 극복하고 성능은 높일 수 있을 것"이라고 설명했다.

연합 학습에는 인텔이 내년 출시할 3세대 제온 스케일러블 프로세서에 내장된 SGX(소프트웨어 가드 익스텐션) 기술도 동원된다. 이 기술은 서버에서 처리하는 프로그램과 데이터를 격리하고 암호화 해 데이터가 실행되는 과정을 엿볼 수 없게 보호한다.

■ 잠재적인 버그 찾는 머신 프로그래밍

머신 프로그래밍은 개발자가 AI에 소프트웨어에 필요한 기능을 설명하면 자동으로 프로그래밍을 통해 원하는 코드를 만들어 주는 전혀 새로운 기술이다.

저스틴 고슬릭 인텔 랩스 수석 과학자는 "현재 소프트웨어를 개발하기 위해 개발자들에게 요구되는 기술은 너무 광범위하며 전세계 78억 명의 인구 중 불과 2천 700만 명이 코딩을 할 수 있다는 연구 결과가 이를 증명한다"고 설명했다.

머신 프로그래밍의 첫 단계는 소프트웨어 디버깅이다. 저스틴 고슬릭은 "2017년 영국 케임브리지 대학 설문조사에서 미국 프로그래머들이 전체 업무 시간의 50% 이상을 디버깅에 투자하고 있다"고 설명했다.

관련기사

- 인텔, CPU·GPU 통합 '원API' 12월 출시2020.11.12

- 인텔, 첫 외장 Xe 기반 그래픽칩 공개2020.11.02

- 인텔, 새로운 트랜지스터 구조 '슈퍼핀' 공개2020.08.13

- 인텔, 기계 프로그래밍 코드 유사성 시스템 공개2020.07.30

인텔 랩스는 현재 AI를 이용해 코드에 숨은 버그를 자동적으로 찾아내는 기술을 개발중이다. AI가 코드를 스스로 학습한 다음 성능을 떨어뜨릴 수 있는 버그, 혹은 잠재적인 버그를 스스로 찾아내 개발자를 돕는다.

저스틴 고슬릭은 "10억 줄 이상의 코드를 이용해 학습한 결과 10년 간 개발자도 알아채지 못했던 버그를 찾아내는 성과를 얻었다"고 설명했다.