퀄컴이 차세대 AI 가속기로 AI 데이터센터 시장을 공략한다. 해당 칩은 저전력 D램을 채용해 엔비디아·AMD 등 기존 HBM(고대역폭메모리) 기반의 AI 가속기 대비 비용을 낮춘 것이 특징이다.

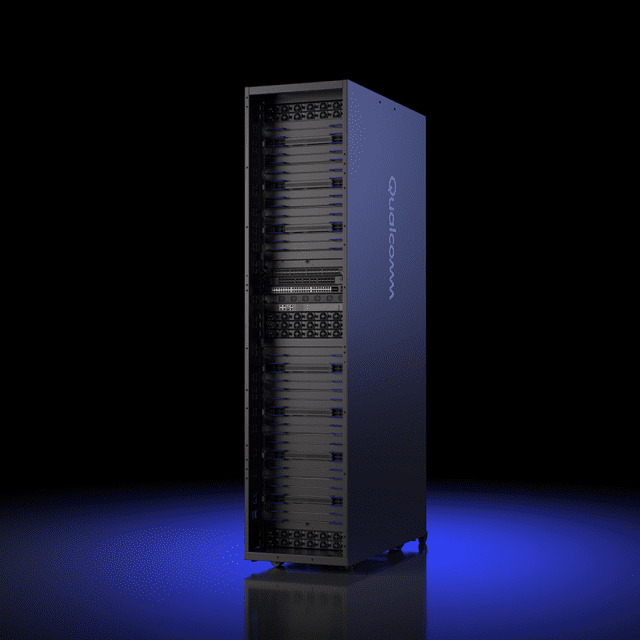

28일 퀄컴은 데이터센터용 AI 추론 최적화 솔루션인 'AI200', 'A250' 칩 기반 가속기 카드와 랙을 출시한다고 밝혔다.

퀄컴에 따르면 AI200은 LLM 및 멀티모달 추론 등 다양한 AI 기능에 최적화된 성능과 낮은 총소유비용(TCO)를 제공하도록 설계됐다. 카드 당 768GB(기가바이트)의 LPDDR을 지원한다.

LPDDR은 저전력 D램을 뜻한다. 엔비디아·AMD 등 기존 데이터센터용 AI 가속기 개발업체가 HBM(고대역폭메모리)을 주요 메모리로 채용한 데 반해, 퀄컴은 LPDDR을 탑재해 비용 및 전력 효율성을 극대화하려는 것으로 풀이된다.

또한 AI250은 메모리 기반 컴퓨팅을 통해 메모리 아키텍처에 변화를 줬다. 퀄컴은 "10배 이상 향상된 유효 메모리 대역폭과 훨씬 낮은 전력 소비를 제공해 AI 추론 워크로드의 효율성과 성능을 획기적으로 향상시킨다"고 설명했다.

이외에도 AI200 및 A250 기반의 랙 솔루션은 열 효율성을 위한 액체 냉각, 160kW 수준의 전력 소비, PCIe·이더넷 등의 연결 기술, 보안 컴퓨팅 적용 등을 특징으로 한다.

AI200 및 A250은 각각 2026년과 2027년에 상용화될 예정이다. 기존 AI 가속기 대비 뛰어난 가성비를 강조한 만큼, 업계는 해당 칩이 반도체 업계에 불러올 파장에 대해 주목하고 있다.

관련기사

- 퀄컴 차세대 AI PC 프로세서, 컴퓨팅·AI 성능서 경쟁사 '압도'2025.09.29

- 퀄컴, 차세대 PC 프로세서 흥행 자신…"삼성과 흥미로운 소식 있을 것"2025.09.29

- 퀄컴·삼성, '갤럭시 AI'서 한뜻…"개인 맞춤형 AI 강화"2025.09.28

- 삼성전자, 갤럭시 AI 기기 '4억대' 목표…퀄컴과 밀월 깊어진다2025.09.25

다만 AI200 및 AI250의 구체적인 성능이 공개되지 않았다는 점은 아직 변수로 남아있다.

문준호 삼성증권 연구원은 "퀄컴은 AI 추론에 초점을 맞춰 HBM이 아닌 LPPDR을 탑재했기 때문에 가격을 낮출 수 있다"면서도 "랙 솔루션의 예상 전력 소비량이 HBM을 탑재한 엔비디아 GB300 NVL72(140~150kW)에 달하는 만큼, 고객사 및 스펙을 먼저 확인해야 할 것"이라고 밝혔다.