"정부가 그래픽처리장치(GPU) 수십만 장을 기업·기관에 도입하고 있지만, 이를 제대로 운영할 수 있는 데이터센터 성능이 여전히 부족합니다. GPU 운영에 필수적인 전력·냉각·네트워크 등 기반 시설이 기존 데이터센터로 감당하기 어렵습니다. 인공지능 데이터센터(AIDC) 구축이 필수입니다."

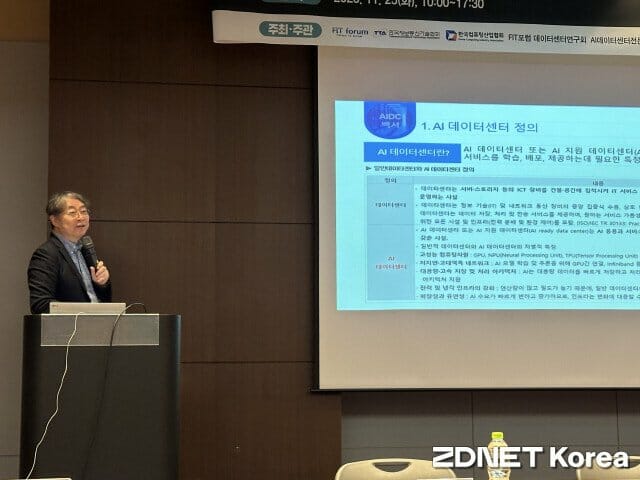

단국대 나연묵 SW융합대학 컴퓨터공학과 교수는 25일 한국컴퓨팅산업협회가 코엑스에서 개최한 '2025 미래 IT 전략-AI데이터센터 컨퍼런스'에서 "정부가 데이터센터 인프라 준비 없이 GPU만 대량 도입하고 있다"며 AIDC 필요성을 재차 강조했다.

그는 기존 데이터센터 개념이 AIDC와 다르다고 설명했다. 기존 데이터센터는 웹서비스나 기업 시스템을 운영하는 데 최적화된 인프라다. 중앙처리장치(CPU) 중심의 일반 서버를 기준으로 설계됐다. 반면 AIDC는 대규모 AI 모델을 학습·추론하는 시설이다. 고성능 연산 장치인 GPU와 AI 칩을 대량으로 활용하는 것을 목표로 뒀다.

나 교수는 GPU 서버 운영의 핵심인 고속 연결망·고출력 전력·고밀도 냉각 세 요소가 기존 데이터센터에 부족하다고 짚었다. 기존 데이터센터는 3~5킬로와트(kW) 전력 공급을 기준으로 설계됐는데, 엔비디아 최신 GPU 서버는 장비 한 대만으로 14.3kW를 요구한다는 점을 대표적 사례로 들었다. 그는 "GPU 한 대가 표준 랙 3개 공간을 차지하는 비효율을 초래할 수 있다"고 지적했다.

네트워크 병목도 기존 데이터센터 주요 문제로 꼽혔다. 나 교수는 국내 데이터센터 네트워크가 랙스케일 서버 구성을 충분히 뒷받침할 수 없다고 평가했다. 그는 "AI 학습은 여러 GPU를 한꺼번에 묶어 하나의 시스템처럼 동작시키는 기술이 반드시 필요하다"며 "이를 위해서는 GPU 간 데이터를 빠르게 주고받는 연결망이 필수"라고 강조했다. 이어 "특히 '인피니밴드'와 '울트라 이더넷' 같은 기술이 GPU 클러스터 성능을 결정한다"고 덧붙였다.

데이터센터 스토리지 요건도 문제로 제기됐다. 그는 "AI 학습에서는 기존 데이터센터 대비 훨씬 더 큰 용량과 더 빠른 처리 속도가 필요하다"며 "지금의 스토리지 인프라로는 대응이 쉽지 않다"고 지적했다.

나 교수는 기존 데이터센터의 냉각 인프라가 한계에 다다랐다고 봤다. 그는 "GPU 서버가 소비한 전력은 그대로 열로 배출되는데, 이 열량이 기존 공랭식 시스템의 처리 한계를 넘고 있다"고 지적했다.

관련기사

- 이노그리드, 위엠비와 AI 데이터센터 운영 관리 역량 '강화'2025.11.25

- 산업부, UAE와 AI 데이터센터·석유산업·원전 등 경제협력 고도화 협의2025.11.20

- 챗GPT가 원전 부른다… 데이터센터 전력 수요 폭증에 기업들 원전 '올인'2025.11.20

- 이노스페이스 "UAE 우주 데이터센터 구축 추진"2025.11.19

이어 "10kW 이상의 발열은 공랭식으로 감당하기 어려워 액침냉각이나 수냉식 같은 고성능 냉각 기술 도입이 불가피하다"며 "현재 정부와 민간에서는 임시 냉각 설비를 증설해 운영을 이어가고 있지만 이를 근본적 해결책으로 볼 수 없다"고 덧붙였다.

또 그는 "GPU 서버의 비중이 높고, 랙 전력 밀도 15~500kW를 감당하면서 수냉식으로 작동하는 AIDC를 더 늘려야 한다"고 강조했다.