AI 챗봇이 실수했을 때, 어떻게 사과해야 할까?

인공지능 챗봇이 일상생활에 깊숙이 들어오면서 새로운 문제가 떠올랐다. 바로 AI가 실수했을 때 어떻게 사과해야 하느냐는 것이다. IBM 리서치와 뉴욕 주립대학교 올버니 캠퍼스 연구진이 공동으로 진행한 최신 연구에 따르면, 사용자들은 단순한 "죄송합니다"보다는 실수 원인을 설명하는 사과를 선호하는 것으로 나타났다.

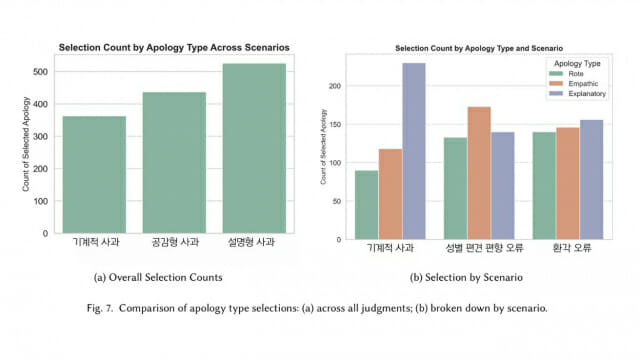

연구팀은 162명의 참가자를 대상으로 세 가지 사과 방식을 테스트했다. 첫 번째는 단순히 "죄송합니다"라고만 하는 기계적 사과(Rote Apology), 두 번째는 사용자의 감정을 헤아리며 공감하는 공감형 사과(Empathic Apology), 세 번째는 실수가 발생한 이유를 자세히 설명하는 설명형 사과(Explanatory Apology)다. 전반적으로 설명형 사과가 가장 높은 선호도를 기록했으며, 기계적 사과는 모든 상황에서 가장 낮은 평가를 받았다.

출처: Who's Sorry Now: User Preferences Among Rote, Empathic, and Explanatory Apologies from LLM Chatbots

편견 실수에는 공감이 최고, 환각 현상엔 답이 없어

흥미로운 점은 AI의 실수 유형에 따라 선호하는 사과 방식이 달라진다는 것이다. 연구진은 세 가지 실수 상황을 설정했다. 첫째는 성별 편견을 드러내는 편향 오류, 둘째는 존재하지 않는 논문을 인용하는 환각(Hallucination) 오류, 셋째는 시간대를 잘못 계산하는 사실 오류였다.

편견과 관련된 실수에서는 설명형 사과보다 공감형 사과가 더 선호되었다. 이는 도덕적으로 민감한 문제에서는 사용자의 감정적 피해를 인정하고 공감하는 것이 더 중요하다는 의미다. 반면 사실 오류에서는 명확하게 설명형 사과가 선호되었다.

가장 흥미로운 결과는 환각 오류에서 나타났다. 존재하지 않는 자료를 마치 실제인 것처럼 제시하는 이 오류에 대해서는 어떤 사과 방식도 명확한 선호도를 보이지 않았다. 참가자들은 이 실수를 가장 심각하게 받아들였지만, 정작 어떤 사과가 적절한지에 대해서는 합의에 이르지 못했다. 이는 환각이라는 새로운 형태의 AI 실수에 대해 사용자들이 아직 적절한 대응 방식을 찾지 못했음을 시사한다.

사용자 성향에 따라 갈리는 사과 선호도

개인의 성향 또한 사과 선호도에 큰 영향을 미쳤다. AI를 인간처럼 대하려는 경향이 강한 사용자들은 공감형 사과를 선호했고, 반대로 AI를 단순한 도구로 여기는 사용자들은 기계적인 사과를 더 받아들였다. 또한 상황을 통제하고 이해하려는 욕구가 강한 사용자들은 설명형 사과를 압도적으로 선호했다.

이는 미래의 AI 시스템이 사용자 개인의 성향을 파악하여 맞춤형 사과를 제공해야 할 필요성을 보여준다. 예를 들어, 장기적으로 상호작용하는 개인 비서 AI의 경우 사용자의 반응 패턴을 학습하여 각자에게 맞는 사과 방식을 개발할 수 있을 것이다.

AI 사과의 미래, 개인화와 상황별 맞춤형이 열쇠

연구진은 효과적인 AI 사과를 위한 몇 가지 핵심 원칙을 제시했다. 첫째, 편견과 같은 도덕적 문제에서는 변명처럼 들리지 않으면서도 명확한 책임 인정과 피해 인식을 보여야 한다. 둘째, 사용자의 개인적 특성을 고려한 맞춤형 접근이 필요하다. 셋째, 환각과 같은 새로운 형태의 실수에 대해서는 더 많은 연구가 필요하다.

특히 연구진은 현재 대부분의 AI 챗봇이 보이는 과도한 복종적 태도가 오히려 진정성 있는 사과를 방해할 수 있다고 지적했다. 인간 간의 사과는 상호 소통과 조율 과정을 거치지만, 현재 AI는 무조건적으로 사과하고 책임을 지려 하기 때문에 사용자와의 진정한 소통이 어렵다는 것이다. 미래의 AI 시스템은 상황에 맞는 적절한 사과 방식을 선택할 수 있는 더 정교한 능력을 갖춰야 할 것으로 보인다.

FAQ

Q: AI 챗봇의 사과가 왜 중요한가요?

A: AI 챗봇이 실수했을 때 적절한 사과는 사용자의 신뢰를 회복하고 지속적인 사용을 유도하는 핵심 요소입니다. 잘못된 사과는 오히려 신뢰를 더 떨어뜨릴 수 있어 AI 시스템 설계에서 매우 중요한 부분입니다.

Q: 환각 현상이란 무엇이며 왜 사과 방식에 대한 합의가 없었나요?

A: 환각(Hallucination)은 AI가 존재하지 않는 정보를 마치 사실인 것처럼 제시하는 현상입니다. 이는 기존에 없던 새로운 형태의 실수여서 사용자들이 어떤 사과가 적절한지 판단하기 어려워하는 것으로 보입니다.

Q: 개인 맞춤형 AI 사과가 실현 가능한가요?

관련기사

- AI로 조교들 쉬게 만든다...손글씨도 채점하고 피드백도 주는 AI 채점 인기2025.07.07

- "요즘 애들은 검색 안 해요"…MS가 알려주는 ‘진짜 정보 찾는 법’2025.07.03

- "AI 의사가 인간보다 4배 정확"... MS 의료 AI, 80% 진단 성공2025.07.01

- 구글에 내준 '내비게이션' 지도, 1대 5000 지도와 뭐가 다를까2026.02.27

A: 연구진은 장기간 상호작용하는 개인 비서 AI의 경우 사용자의 반응 패턴을 학습하여 개인 맞춤형 사과를 제공할 수 있을 것으로 예상한다고 밝혔습니다. 다만 이를 위해서는 더 정교한 사용자 모델링 기술이 필요합니다.

■ 이 기사는 AI 전문 매체 ‘AI 매터스’와 제휴를 통해 제공됩니다. 기사는 클로드 3.5 소네트와 챗GPT를 활용해 작성되었습니다. (☞ 기사 원문 바로가기)