챗GPT의 추론 성능을 60%이상 개선할 수 있는 신경망처리장치(NPU) 핵심기술이 개발됐다.

KAIST는 전산학부 박종세 교수 연구팀과 (주)하이퍼엑셀(전기및전자공학부 김주영 교수 창업기업)이 챗GPT와 같은 생성형AI 클라우드에 특화된 고성능·저전력 NPU 핵심기술을 새로 설계하는데 성공했다고 4일 밝혔다.

핵심은 2가지다. 키-값(KV) 캐시를 경량화하는 양자화 (quantization) 알고리즘과 이를 가속하는 NPU 기반 하드웨어 모듈(아키텍처)을 새로 개발했다.

트랜스포머 기반 언어 모델 추론 과정에서 생성되는 KV 캐시는 매 요청, 매 토큰마다 생성돼 누적되기 때문에 대규모 시스템에서는 메모리 용량과 대역폭 사용량 대부분을 차지한다.

이로인해 시스템 성능 병목을 초래한다. 연구자들이 이를 타개하기 위한 방편으로 최신 GPU를 최대한 많이 확보하려고 애쓰는 이유다.

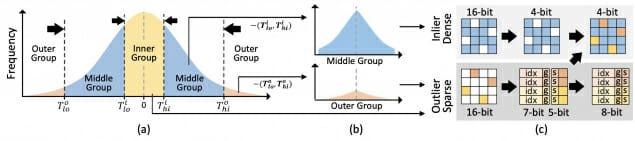

연구팀은 이같은 문제 해결을 위해 다양한 모델 및 입력 데이터셋 KV 캐시 값 분포를 분석하고 이를 특성화했다.

연구팀은 "이를 바탕으로 정확도 손실을 최소화하는 양자화 기법을 새로 설계했다"며 "양자화된 KV 캐시 평균 비트 폭 (bitwidth)를 줄이기 위해 양자화가 어려운 값들을 효과적으로 처리하는 경량화 기법도 함께 설계했다"고 설명했다.

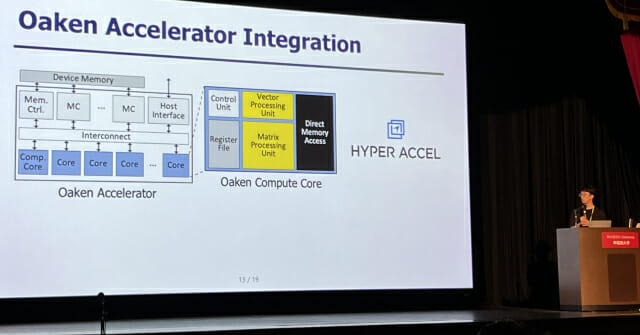

하드웨어 모듈은 기존 NPU 아키텍처 연산 로직을 변경하지 않으면서도 메모리 인터페이스와 통합될 수 있도록 설계했다.

연구팀은 이 모듈에 제한된 메모리 대역폭 및 용량을 효율적으로 활용하기 위한 페이지 단위 메모리 관리 기법과 양자화된 KV 캐시에 최적화된 새로운 인코딩 기법 등을 개발, 적용했다.

연구팀은 "이를 적용한 NPU 디바이스는 최신 GPU 기반 기존 경량화 기법 대비 추론 성능(초당 생성 토큰 개수)과 정확도가 60%이상 우수했다"며 "전력 소모도 기존 대비 44%이상 효율성을 확보했다"고 부연 설명했다.

박종세 교수는 "메모리 사용의 대부분을 차지하는 KV 캐시를 양자화함으로써, 적은 수의 NPU 디바이스 만으로 동일 수준의 AI 인프라를 구성할 수 있게 됐다"며 "생성형 AI 클라우드 구축 비용을 크게 절감할 수 있을 것"이라고 말했다.

박 교수는 또 "능동적인 실행형 AI인 ‘에이전틱 AI ’등으로 대표되는 AI 대전환(AX) 환경에서도 핵심 역할을 할 것"으로 기대했다.

연구는 KAIST 김민수 연구생(박사과정)과 ㈜하이퍼엑셀 홍성민 박사가 공동 제1 저자로 진행했다.

관련기사

- 하이퍼엑셀, 국산 AI 반도체 기반 K-클라우드 기술개발 국책과제 수주2025.05.09

- [기고] 생성형 AI 도입, 급할수록 돌아가라2025.03.20

- 카이스트-삼성, AI 시대 'PIM 반도체' 상용화 9부능선 넘었다2024.08.11

- 美, 생성형 AI '무단 학습' 철퇴…강력 규제법 만든다2024.07.13

연구결과는 지난 달 21일부터 25일까지 일본 도쿄에서 열린 ‘2025 국제 컴퓨터구조 심포지엄(ISCA)’에 발표됐다.

예산은 한국연구재단 우수신진연구자지원사업, 정보통신기획평가원(IITP), 인공지능반도체대학원지원사업 지원을 받았다.