“팔을 더 높이 들어올리기”도 텍스트로 지시하는 시대

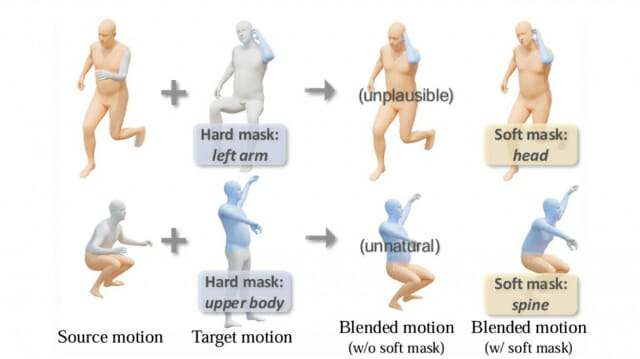

베이징대학교와 BIGAI 연구팀이 공동 개발한 ‘MotionReFit’은 기존의 한계를 넘은 범용 텍스트 기반 모션 편집 프레임워크다. 연구팀이 공개한 논문에 따르면, 사용자는 “팔을 더 넓게 흔들기”, “자랑스러운 자세로 걷기”, “상체로 바이올린 연주하기” 같은 문장을 입력하기만 하면 해당 동작이 애니메이션 캐릭터에 즉시 반영된다. 기존 모델은 ‘원본 모션–편집 모션–지시문’이라는 고정된 학습 구조를 갖고 있어 새로운 조합이나 감정 표현에는 취약했다. 이에 연구팀은 MotionCutMix라는 새로운 데이터 증강 기법을 도입해 문제를 해결했다. 이 기법은 서로 다른 모션 시퀀스의 신체 부위를 조합해 새로운 학습 샘플을 생성하는 방식으로, 기존보다 훨씬 다양한 편집 시나리오에 대응할 수 있다. 이를 통해 감정 변화나 복합 동작 같은 복잡한 지시도 자연스럽게 표현할 수 있게 됐다.

하지만 이렇게 생성된 모션은 때때로 손과 발의 움직임이 따로 놀거나 불균형한 동작이 발생할 수 있다. 이를 해결하기 위해 연구팀은 '모션 코디네이터(Body Part Coordinator)'라는 판별기 구조를 추가했다. 이 모듈은 생성된 모션이 얼마나 자연스럽고 조화로운지를 평가하고, 부자연스러운 동작을 걸러내는 방식으로 신체 부위 간의 동기화를 유도한다. 결과적으로, 시간의 흐름에 따른 동작 변화와 복잡한 신체 조합도 매끄럽게 구현할 수 있게 됐다.

13,000개 동작과 750개 스타일 모션으로 훈련된 AI

MotionReFit의 성능을 뒷받침하는 핵심은 ‘STANCE’라는 전용 데이터셋이다. 이 데이터셋은 크게 세 가지 모션 편집 작업을 학습할 수 있도록 구성되어 있다. 첫 번째는 신체 부위 대체 작업으로, HumanML3D 기반의 13,000개 모션 시퀀스에 평균 2개 이상의 마스크와 각 부위에 대한 자세한 동작 설명이 주어진다. 예를 들어 ‘상체는 바이올린을 켜고 하체는 걸어간다’는 식의 복합 모션도 구현 가능하다.

두 번째는 스타일 전환 작업이다. 연구팀은 전문 배우들이 동일한 동작을 다양한 감정 스타일로 표현하도록 하여 새로운 모션 캡처 데이터를 구축했다. 배우들은 자랑스러운, 우울한, 노인처럼 걷는 등의 감정을 반영한 동작을 연기했으며, 총 2시간 분량의 데이터로부터 750개의 고품질 모션 시퀀스가 수집됐다.

세 번째는 세밀한 동작 조정 작업으로, “오른팔을 더 높이 들어올리기” 같은 미세한 지시에 대응할 수 있도록 구성됐다. 이를 위해 16,000개의 원본 모션과 편집본, 그리고 해당 지시문으로 이루어진 트리플 데이터를 포함시켰다.

이 데이터셋은 GPT-4 기반으로 자동 생성한 초안에 대해 사람 주석자가 직접 검토하고 수정하는 방식으로 제작됐다. 기존의 대규모 언어 모델 기반 주석 방식보다 더 정밀하고 자연스러운 설명이 가능하다는 점에서 높은 완성도를 자랑한다.

FID 0.20 vs. 0.52, '자연스러움' 수치에서 확실한 차이

MotionReFit은 대표적인 경쟁 모델인 MDM과 TMED보다 월등한 성능을 보여줬다. 특히 모션의 자연스러움을 평가하는 FID(Fréchet Inception Distance) 점수에서 MotionReFit은 0.20을 기록하며, TMED의 0.52보다 두 배 이상 향상된 수치를 보였다. 이 수치는 낮을수록 실제 모션에 가까운 결과를 의미하는 만큼, MotionReFit의 모션 품질이 매우 우수하다는 것을 방증한다.

편집된 모션이 원본 동작과 얼마나 유사한지를 평가하는 E2S(Edited-to-Source Retrieval) 점수와, 편집 지시와 얼마나 잘 일치하는지를 평가하는 E2T(Edited-to-Target Retrieval) 점수 역시 MotionReFit이 가장 높은 정확도를 보였다. 예를 들어 MotionReFit은 “뒤로 걷기”, “상체로 열정적으로 기타 연주하기”와 같은 복합적인 지시에서도 원본 동작의 맥락을 유지하면서 지시에 정확히 부합하는 새로운 행동을 추가할 수 있었다. 반면 기존 모델들은 손과 발이 따로 움직이거나 감정 표현이 뚜렷하지 않은 등, 일관성이나 자연스러움 측면에서 부족한 결과를 보였다.

또한, 발 움직임의 물리적 정확성을 평가하는 FS(Foot Score)에서도 MotionReFit은 0.97을 기록하며, 경쟁 모델 대비 월등한 수준의 물리적 타당성을 확보했다.

“우울하게 걷기→기타 연주”까지 실시간 시퀀스 제어

MotionReFit은 단일 편집에 그치지 않고 시간 순차적 동작 조합과 사용자 상호작용 기반 반복 편집까지 지원한다. 사용자는 “팔을 들어 올리기”라는 지시로 시작한 후 “기타 연주 동작으로 전환”, 이어서 “하체로 리듬 타기”와 같은 지시를 순차적으로 입력할 수 있다. 각 단계는 프레임 단위로 나뉘어 모델에 전달되며, 오토레그레시브 방식으로 생성되기 때문에 중간 지점에서 새로운 지시가 주어지더라도 이전 동작과 부드럽게 연결된다.

이와 같은 기능 덕분에 MotionReFit은 단순한 모션 생성기가 아니라, 실시간으로 인터랙티브한 모션 편집이 가능한 시스템으로 발전했다. 실제로 연구팀은 16프레임 단위의 윈도우 크기 기준으로 초당 약 25프레임(FPS) 수준의 생성 속도를 달성했다. RTX 3090 GPU 환경에서 1초 분량의 애니메이션을 0.6초 내외로 생성할 수 있으며, 이로 인해 게임 캐릭터 제어, 가상 인간의 동작 생성, 애니메이션 제작 도구 등 다양한 산업 현장에서 즉시 활용이 가능하다.

FAQ

Q. MotionReFit은 어떤 점에서 기존 모션 생성 AI와 다른가요?

A: 기존 AI는 정해진 모션 샘플과 지시문 조합만 학습하기 때문에 새로운 스타일이나 복잡한 편집에는 한계가 있었습니다. 반면 MotionReFit은 MotionCutMix라는 기술로 다양한 신체 부위 모션을 혼합해 새로운 학습 데이터를 생성하고, 자연어 지시만으로도 정교한 모션 편집이 가능합니다. 감정 표현이나 복합 동작도 훨씬 자연스럽게 구현됩니다.

Q. 이 기술이 실제로 어디에 활용될 수 있나요?

A: MotionReFit은 게임 캐릭터의 실시간 동작 제어, 애니메이션 제작 자동화, 가상 인간의 감정 표현 등 다양한 분야에 활용될 수 있습니다. 특히 한 줄의 문장만으로도 ‘우울하게 걷기’ 같은 감정 기반 동작이 가능해져, 인터랙티브 콘텐츠나 XR 환경에서 실시간 캐릭터 제어에 큰 강점이 있습니다.

Q. MotionReFit을 사용하려면 많은 데이터를 직접 준비해야 하나요?

관련기사

- 챗GPT에서 브랜드 노출 극대화하려면 어떻게 해야 할까2025.04.15

- [Q&AI] 이재명, 출마 선언 후 첫 공식 일정으로 AI기업 방문… 왜?2025.04.14

- 中 유니트리, G1 로봇 복싱 대결 예고… 로봇 스포츠의 새 지평 열까2025.04.11

- "1분짜리 AI 영상도 가능?"…엔비디아 TTT로 만든 ‘톰과 제리’2025.04.11

A: 아닙니다. MotionReFit은 적은 양의 주석 데이터만으로도 고성능을 발휘할 수 있도록 설계되었습니다. MotionCutMix를 통해 대량의 무주석 데이터를 조합해 학습 데이터를 자동으로 확장할 수 있기 때문에, 기존 시스템보다 훨씬 효율적인 학습이 가능합니다.

■ 이 기사는 AI 전문 매체 ‘AI 매터스’와 제휴를 통해 제공됩니다. 기사는 클로드 3.5 소네트와 챗GPT를 활용해 작성되었습니다. (☞ 기사 원문 바로가기)