대형 언어 모델(LLM), 훈련 없이 시각·청각 능력 발휘

메타 AI와 UC 버클리 연구진이 발표한 연구에 따르면, 대형 언어 모델(LLM)은 추가적인 훈련 없이도 이미지, 비디오, 오디오를 이해하고 생성하는 능력을 갖출 수 있는 것으로 나타났다. 연구진은 이 과정을 가능하게 하는 ‘MILS(Multimodal Iterative LLM Solver)’ 기법을 개발했다. MILS는 LLM의 테스트 타임 최적화(test-time optimization) 능력을 활용해 멀티모달 데이터를 처리할 수 있도록 하는 방식이다.

기존 멀티모달 AI 모델들은 특정 데이터셋을 기반으로 훈련해야 했지만, MILS는 이러한 과정 없이도 이미지 캡셔닝(image captioning), 영상과 오디오 이해 및 생성, 스타일 변환(style transfer) 등 다양한 작업을 수행할 수 있다. 연구에 따르면, MILS는 LLM이 자체적으로 해결책을 생성하고, 멀티모달 모델이 이를 평가하여 피드백을 제공하는 방식으로 작동한다. 이러한 반복적인 최적화 과정을 거치면서 MILS는 최적의 결과를 도출할 수 있다.

MILS의 핵심 원리: 생성하고 평가하며 스스로 발전

MILS의 가장 큰 특징은 훈련 없이도 멀티모달 데이터를 처리할 수 있는 능력이다. 기존의 모델들은 이미지 캡셔닝을 위해 이미지-텍스트 페어 데이터로 훈련되어야 했지만, MILS는 이러한 과정 없이도 이미지, 영상, 오디오 데이터를 해석할 수 있다.

예를 들어, MILS는 일반적인 LLM을 생성기(GENERATOR)로 활용하고, CLIP 같은 멀티모달 모델을 평가기(SCORER)로 활용한다. MILS가 생성한 후보 결과물은 평가 모델을 통해 점수를 매겨 다시 피드백되며, 이 과정을 반복하면서 성능을 점진적으로 향상시킨다. 연구진은 이 과정을 통해 MILS가 "emergent zero-shot capabilities", 즉 새로운 데이터나 작업을 훈련 없이 처리할 수 있는 능력을 갖추게 된다고 설명했다.

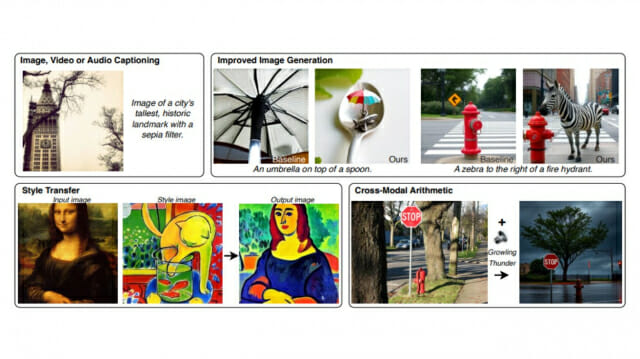

MILS는 단순히 이미지 캡셔닝뿐만 아니라 텍스트-이미지 생성(text-to-image generation), 스타일 변환(style transfer), 멀티모달 산술(cross-modal arithmetic) 등 다양한 작업에도 적용될 수 있다. 연구진은 MILS를 활용하여 스타일 변환을 수행하고, 다양한 이미지 스타일을 적용하는 실험에서도 성공적인 결과를 보였다고 밝혔다.

MILS의 실험 결과: 기존 모델과 비교해 경쟁력 있는 성능

연구진은 MILS의 성능을 기존의 멀티모달 모델들과 비교 평가했다. 대표적인 실험 결과는 다음과 같다.

이미지 캡셔닝(Image Captioning): MILS는 기존의 이미지 캡셔닝 모델과 비교하여 경쟁력 있는 성능을 기록했다. MSCOCO 데이터셋을 기준으로, BLEU4, CIDEr, METEOR, SPICE 등의 평가 지표에서 기존 모델들과 대등하거나 더 나은 성능을 보였다.

비디오 캡셔닝(Video Captioning): MILS는 MSR-VTT 데이터셋을 활용한 실험에서도 기존 비디오 캡셔닝 모델과 비교해 강력한 성능을 보였다. 특히, 훈련 없이도 기존의 HowTo100M과 VideoCC3M 데이터셋을 활용한 모델과 유사한 수준의 성능을 기록했다.

오디오 캡셔닝(Audio Captioning): Clotho 데이터셋을 활용한 실험에서는 기존의 Zero-shot Audio Captioning 모델(ZerAuCap)보다 높은 METEOR 및 SPICE 점수를 기록하며, 문맥적으로 더 정확한 캡션을 생성할 수 있음을 보여주었다.

텍스트-이미지 생성(Text-to-Image Generation): MILS를 사용해 최신 텍스트-이미지 생성 모델(예: LDM, FLUX.1)에서 품질을 향상시키는 실험을 진행했다. 연구진이 수행한 인간 평가에서 MILS를 적용한 생성 이미지가 더욱 높은 품질과 텍스트 일치도를 보였다.

스타일 변환(Style Transfer): MILS는 훈련 없이도 특정 스타일을 이미지에 적용하는 능력을 보였다. 연구진은 Gram Matrix 기반 거리 측정 방식을 SCORER로 활용해 스타일 변환을 성공적으로 수행했다.

멀티모달 산술(Cross-Modal Arithmetic): MILS는 이미지와 오디오를 결합해 새로운 텍스트 설명을 생성하는 실험에서도 효과적인 결과를 도출했다. 예를 들어, "잔디 위에 있는 학"이라는 이미지와 "해변에서 파도가 치는 소리"라는 오디오 설명을 결합하여 "해변가에서 파도를 바라보는 학"이라는 새로운 개념을 생성할 수 있었다.

MILS의 확장 가능성과 AI 모델의 발전, 훈련 없이도 창작과 분석이 가능하다

MILS는 훈련 없이 멀티모달 AI 시스템을 구축할 수 있다는 점에서 기존 모델과 차별화된다. 특히, 새로운 데이터셋이나 작업에 대해 즉각적인 적응이 가능하다는 점에서 AI 연구 및 산업에서 활용 가치가 클 것으로 보인다. 연구진은 MILS의 성능이 LLM과 멀티모달 모델의 발전에 따라 더욱 향상될 것이라고 전망했다. 예를 들어, LLM의 연산 속도가 향상되거나, 컨텍스트 길이가 증가하면 MILS의 최적화 과정이 더욱 빨라지고 효율적으로 작동할 수 있다. 또한, 멀티모달 AI 모델이 개선될수록 MILS의 성능도 자연스럽게 향상될 것으로 예상된다.

향후 MILS는 영상, 3D 모델링, 로봇 비전 등 더 다양한 영역에 적용될 가능성이 있다. 특히, 실시간 비디오 분석이나 AI 기반 디자인 생성 등 보다 복잡한 멀티모달 작업에도 적용될 수 있을 것이라는 기대가 크다. 이번 연구 결과는 AI 모델이 훈련 없이도 다양한 감각 정보를 처리할 수 있음을 입증하며, 향후 AI의 멀티모달 이해 능력을 한층 더 발전시키는 계기가 될 것으로 보인다.

FAQ

Q. MILS는 기존 AI 모델과 어떻게 다른가요?

A. 기존 모델은 이미지·오디오 이해를 위해 훈련 데이터가 필요했지만, MILS는 훈련 없이도 즉시 다양한 멀티모달 작업을 수행할 수 있습니다. LLM이 스스로 후보 답변을 생성하고, 평가 모델이 이를 검토하며 점진적으로 개선하는 방식으로 작동합니다. 이를 통해 AI가 새로운 데이터나 작업에도 빠르게 적응할 수 있습니다.

Q. MILS가 실제로 어떤 성능을 보였나요?

A. 이미지·비디오·오디오 캡셔닝에서 기존 훈련 기반 모델과 비슷하거나 더 나은 성능을 보였습니다. 예를 들어, 이미지 캡셔닝 실험에서 METEOR 및 SPICE 점수에서 기존 모델을 능가했습니다. 텍스트-이미지 생성 및 스타일 변환에서도 MILS 기반 생성 이미지가 더 높은 품질을 기록했습니다.

Q. MILS는 앞으로 어떤 분야에서 활용될 수 있나요?

관련기사

- 하사비스 딥마인드 CEO "5~10년 내 인간 수준 AI 등장"2025.03.18

- 클릭 한 번에 매출 51% 증가…AI 맞춤형 비즈니스 혁명, 비법은?2025.03.18

- AI 뉴스검색 "못 믿겠네"… 8개 엔진 모두 "인용 문제 심각"2025.03.18

- 韓 AI반도체, '엔비디아 대항마' 넘어 실전으로2026.02.18

A. MILS는 영상 분석, 3D 모델링, 로봇 비전 등 더 복잡한 멀티모달 작업에 적용될 수 있습니다. 실시간 AI 응용 프로그램에서 데이터 없이 즉각적으로 적응하는 시스템 개발에도 활용될 가능성이 큽니다. LLM과 멀티모달 AI 기술이 발전할수록 MILS의 활용 가능성도 더욱 커질 것입니다.

■ 이 기사는 AI 전문 매체 ‘AI 매터스’와 제휴를 통해 제공됩니다. 기사는 클로드 3.5 소네트와 챗GPT를 활용해 작성되었습니다. (☞ 기사 원문 바로가기)