챗GPT 1회 사용 전력량 0.3와트시... 기존 추정치의 1/10 수준

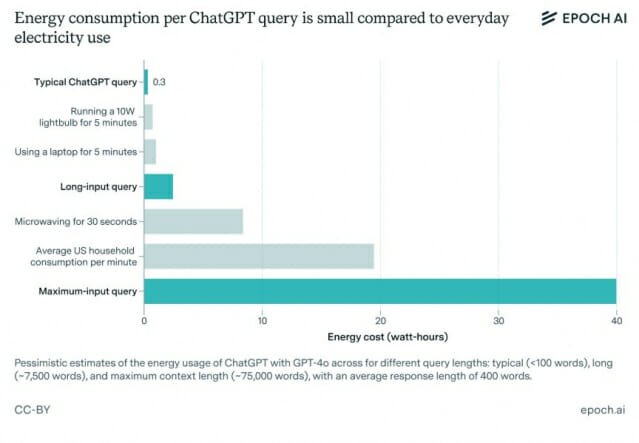

인공지능(AI) 연구소 에포크AI(Epoch AI)의 분석에 따르면, 챗GPT의 실제 전력 소비량이 기존에 알려진 것보다 훨씬 낮은 것으로 나타났다. 일반적인 챗GPT 사용 시 소비되는 전력량은 약 0.3와트시(Wh)로, 이는 기존에 널리 알려졌던 3와트시의 10분의 1 수준이다. 이는 LED 전구나 노트북을 몇 분 정도 사용하는 데 필요한 전력량보다도 적은 수준이다. 미국의 평균 가정이 연간 소비하는 전력량이 1만 500킬로와트시(하루 평균 2만 8천 와트시)임을 고려하면, 챗GPT 사용으로 인한 전력 소비는 매우 미미한 수준이다.(☞ 보고서 원문 바로가기)

GPT-4o, 2천억 개 매개변수로 단 0.3와트시 전력 소비

챗GPT의 주력 모델인 GPT-4o는 약 2,000억 개의 매개변수를 보유하고 있으며, 혼합 전문가 모델(MoE) 구조를 통해 실제로는 이 중 약 1,000억 개만 동시에 활성화된다. 한 번의 응답 생성에는 평균 500개의 토큰(약 400단어)이 사용되며, 이는 약 0.3와트시의 전력을 소비한다. GPT-4o-mini는 API 가격이 GPT-4o의 10분의 1 수준으로, 전력 소비도 더 적다. 반면 추론에 특화된 o1과 o3 모델은 일반 응답보다 2.5배 많은 토큰을 생성하며, 이로 인해 더 높은 전력을 소비한다.

주요 AI 기업들의 대화형 모델도 비슷한 수준의 전력 소비

메타(Meta)의 AI 어시스턴트는 라마 3.2(Llama 3.2) 11B 또는 90B 모델을 사용하며, 앤트로픽(Anthropic)의 클로드(Claude)는 클로드 3.5 소넷(Claude 3.5 Sonnet)을 기반으로 약 4,000억 개의 매개변수를 사용한다. 구글의 제미나이(Gemini)는 플래시(Flash)와 프로(Pro) 모델을 사용하고 있다. 딥시크(DeepSeek)의 V3 모델은 총 6,710억 개의 매개변수 중 370억 개만 활성화하는 방식으로 효율적인 전력 소비를 실현했다. 이들 모델은 대부분 GPT-4o나 GPT-4o-mini와 비슷한 수준의 전력을 소비하는 것으로 분석된다.

10만 토큰 입력 시 전력 소비량 40와트시까지 증가

입력 데이터의 길이가 길어질수록 전력 소비량이 기하급수적으로 증가한다. 일반적인 대화에서는 0.3와트시면 충분하지만, 1만 토큰(짧은 논문이나 긴 잡지 기사 수준) 길이의 입력 텍스트를 처리할 경우 약 2.5와트시의 전력이 필요하다. 10만 토큰(약 200페이지 분량)을 처리할 때는 약 40와트시의 전력이 소비된다. 다만 이러한 대용량 처리는 초기 한 번만 필요하며, 이후 같은 문서에 대한 대화는 추가적인 대용량 전력 소비가 발생하지 않는다.

AI 모델 학습에 미국 가정 2만 가구 3개월치 전력 소비

GPT-4o와 같은 대형 AI 모델의 학습 과정에는 약 20-25메가와트의 전력이 3개월 동안 소비되며, 이는 약 2만 가구의 미국 가정이 사용하는 전력량과 비슷한 수준이다. 챗GPT는 현재 3억 명의 사용자를 보유하고 있으며 하루 10억 건의 메시지를 처리한다. 이를 0.3와트시로 계산하면 하루 약 12.5메가와트의 전력이 소비되는데, 이는 모델 학습에 필요한 전력량과 비슷한 수준이다.

AI 칩 제조 에너지 비용, 운영 전력보다 낮아

TSMC와 같은 AI 칩 제조업체의 전력 소비량도 주목할 만하다. TSMC는 2023년 한 해 동안 240억 킬로와트시(평균 2.7기가와트)의 전력을 소비했다. 이는 TSMC가 생산한 GPU들이 소비하는 전력량(GPU당 약 1킬로와트)과 비슷한 수준이지만, GPU가 여러 해 동안 사용된다는 점을 고려하면 실제 운영 전력이 제조 과정의 전력 소비보다 더 높다고 볼 수 있다.

AI 모델의 전력 효율성, 하드웨어와 알고리즘 발전으로 개선 중

AI 업계는 다중 토큰 예측이나 추론 최적화 등 다양한 기술을 통해 전력 효율성을 지속적으로 개선하고 있다. 구글 딥마인드(Google DeepMind)는 200만 토큰의 입력 처리가 가능한 제미나이(Gemini) 모델을 출시하며 입력 처리의 효율성을 크게 향상시켰다. 다만 AI가 점차 복잡한 작업을 수행하게 되면서, 이러한 효율성 개선이 실제 전력 소비 감소로 이어질지는 불확실하다. 특히 딥 리서치(Deep Research)와 같은 고급 AI 서비스의 등장은 AI의 전력 소비가 증가할 수 있음을 시사한다.

2030년 AI 전력 소비량, 미국 전체의 10% 전망

관련기사

- [Q&AI] 조태용 vs 홍장원, 계엄 메모 진실 공방…탄핵 심판 증거될까2025.02.13

- [Q&AI] AI칩 개발 전쟁 시작됐나…메타가 퓨리오사AI 노리는 이유는2025.02.13

- AI가 우리를 멍청하게 만든다고?…MS의 충격적 연구2025.02.12

- 금융심사 넘은 '국가AI컴퓨팅센터'…구축 속도 붙을까2026.03.10

에포크AI는 2030년까지 AI가 미국 전체 전력 소비량의 약 10%를 차지할 것으로 전망했다. 현재 AI 데이터센터는 연간 약 11테라와트시의 전력을 소비하는데, 이는 미국 전체 전력 소비량(4조 킬로와트시)의 약 0.3% 수준이다. 하드웨어와 알고리즘의 효율성이 지속적으로 개선되고 있어 장기적으로는 AI의 전력 효율성이 더욱 향상될 것으로 예상된다.

■ 이 기사는 AI 전문 매체 ‘AI 매터스’와 제휴를 통해 제공됩니다. 기사는 클로드 3.5 소네트와 챗GPT를 활용해 작성되었습니다. (☞ 기사 원문 바로가기)