"30분 녹음으로 동화책 완성"...AI가 바꾼 4살 아이의 창작 경험

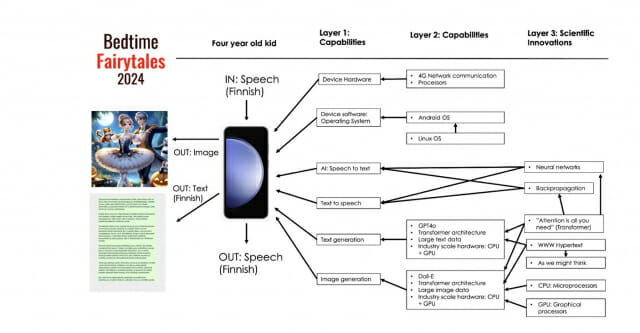

필란드의 알토 대학교의 타피오 피트카란타(Tapio Pitkaranta) 교수가 발표한 논문에 따르면, 현재 우리는 4살 아이도 음성만으로 AI를 통해 자신만의 동화책을 만들 수 있는 시대를 살고 있다. 단 30분의 녹음으로 이야기를 만들고, AI는 이를 텍스트로 변환하고 그림을 그려 다시 음성으로 들려주는 방식이다. (☞ 논문 바로가기)

주목할 만한 점은 아이가 AI가 만든 초기 결과물이 마음에 들지 않으면 수정을 요청할 수 있으며, 성인의 기술적 도움 없이도 AI와 직접 상호작용하며 자신만의 비전에 맞는 이야기를 완성할 수 있다는 것이다.

1970년대 마이크로프로세서에서 현대 CPU까지: 컴퓨팅 파워의 진화

1971년 인텔의 4004 프로세서 출시를 시작으로 컴퓨터 하드웨어는 급속도로 발전했다. 1978년 인텔 8086은 PC 산업의 표준이 되었고, 이후 CPU는 복잡한 수학적 연산이 가능한 수준으로 발전했다. 1945년 ENIAC이 진공관으로 기본적인 수치 계산만 수행하던 시대에서, 현재는 수십억 개의 트랜지스터로 AI 모델 학습이 가능한 시대로 진화했다.

"4G의 100배 속도"...5G 시대가 여는 모바일 AI 혁명

1946년 벨 연구소의 차량용 전화 시스템을 시작으로, 모바일 기술은 1G에서 5G까지 진화했다. 특히 2007년 아이폰의 등장과 함께 시작된 스마트폰 혁명은 현재 전 세계 60억대 이상의 스마트폰으로 이어졌다. 이러한 모바일 기기들은 단순한 통신기기를 넘어 AI 시스템을 위한 데이터 생성기이자 접근 지점이 되었다. 5G 네트워크는 4G보다 100배 빠른 속도로, 실시간 AI 응용을 가능하게 만들었다.

1메가와트에서 1기가와트로: 데이터센터 전력 소비의 폭발적 증가

현대 AI 시스템의 근간이 되는 데이터센터는 이제 원자력발전소에 맞먹는 수준인 1기가와트(GW)의 전력을 소비한다. 국제에너지기구(IEA)의 '2024년 전력 분석 및 전망' 보고서는 처음으로 데이터센터의 전력 소비를 주요 이슈로 다뤘다. 특히 2010년대 후반부터는 엣지 컴퓨팅과 서버리스 기술의 도입으로 실시간 분석과 사물인터넷(IoT) 애플리케이션이 가능해졌으며, AWS 람다와 같은 서비스로 인프라 관리 없이도 코드 실행이 가능해졌다.

1999년 GeForce 256에서 2020년 A100까지: GPU의 AI 가속화 여정

GPU의 역사는 1970년대 벡터와 래스터 그래픽을 위한 특수 하드웨어에서 시작되었다. 1984년 IBM의 Professional Graphics Controller를 거쳐, 1999년 엔비디아(NVIDIA)의 GeForce 256은 최초로 변환과 조명 기능을 내장한 'GPU'로서 그래픽 연산의 새로운 표준을 제시했다. 2007년 CUDA 아키텍처의 도입으로 GPU는 과학 시뮬레이션과 기계학습으로 영역을 확장했고, 2020년 출시된 A100 GPU는 대규모 AI 모델 학습에 최적화되었다.

1945년 하이퍼미디어에서 1998년 PageRank까지: 웹이 만든 AI 데이터 혁명

1945년 배니버 부시의 'As We May Think' 논문에서 제시된 하이퍼미디어 개념은 1968년 더글러스 엥겔바트의 "모든 데모의 어머니"를 거쳐, 1989년 팀 버너스리의 WWW 발명으로 실현되었다. 1994년 넷스케이프 네비게이터의 등장으로 웹 접근성이 향상되었고, 1998년 브린과 페이지가 개발한 구글의 PageRank 알고리즘은 웹의 하이퍼링크 구조를 활용해 정보의 중요도를 평가하는 혁신을 가져왔다.

1943년 신경망에서 2017년 트랜스포머까지: AI 연구의 핵심 돌파구

관련기사

- [Q&AI] 설날 용돈 얼마가 적당할까…AI에게 물어보니2025.01.25

- [Q&AI] 아나운서 김나정, 마약 강제 투약 자수…챗GPT가 예상한 형량은2025.01.25

- 오픈AI의 첫 'AI 에이전트' 오퍼레이터, 어떻게 작동할까2025.01.25

- '다음' 인수 나선 업스테이지…낭만 승부수와 IPO 전략 사이2026.02.02

1950년 앨런 튜링의 '컴퓨팅 기계와 지능' 논문으로 시작된 AI 연구는 1943년 매컬럭-피츠 뉴런 모델, 1961년 로젠블랫의 퍼셉트론을 거쳐 발전했다. 1970년 린나인마의 역전파 알고리즘, 1986년 루멜하트, 힌튼, 윌리엄스의 연구로 다층 신경망 학습이 가능해졌다. 2013년 Word2Vec의 등장으로 자연어의 의미 관계를 벡터로 표현할 수 있게 되었고, 2017년 "Attention is All You Need" 논문의 트랜스포머 모델은 GPT, BERT와 같은 대규모 언어 모델의 근간이 되었다.

■ 이 기사는 AI 전문 매체 ‘AI 매터스’와 제휴를 통해 제공됩니다. 기사는 클로드 3.5 소네트와 챗GPT-4o를 활용해 작성되었습니다. (☞ 기사 원문 바로가기)