네이버가 지난 3년여간 비공개로 부쳐온 이 회사의 1세대 거대 언어AI '하이퍼클로바(HyperCLOVA)'의 매개변수(파라미터)가 처음으로 공개됐다.

네이버는 지난 2021년 5월 자사의 1세대 생성AI '하이퍼클로바'를, 이어 2년여 후인 2023년 8월 '하이퍼클로바'를 업그레이드한 2세대 생성AI '하이퍼클로바X'를 각각 발표했다. 하지만 두 제품 모두 AI 성능을 좌우하는 핵심 요소인 파라미터 수를 그동안 비공개로 일관했다. 파라미터 수를 알면 AI에 투자한 비용과 성능 등을 유추할 수 있어 굳이 경쟁사에 노출하고 싶지 않아서다. 이에, '하이퍼클로바'의 파라미터를 놓고 추측만 무성했다.

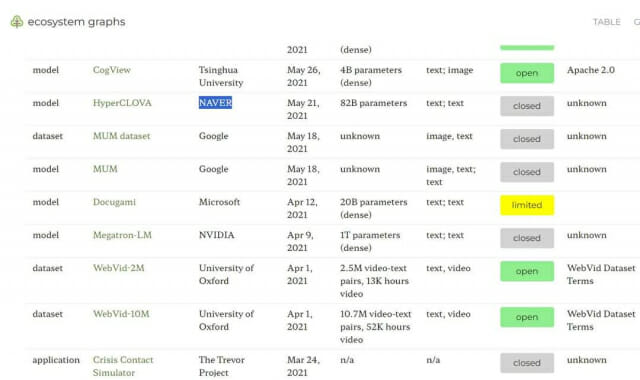

최근 '에코시스템 그래프(Ecosystem graph)'에 따르면 '하이퍼클로바'의 파라미터는 820억개로 나타났다. '에코시스템 그래프'는 미국 스탠포드 대학이 매년 1분기에 발표하는 세계 AI 생태계 조사 보고서 'AI 인덱스'의 파운데이션 모델(거대 AI)의 근거가 된다. 올해 스탠포드 'AI 인덱스'는 세계 파운데이션 모델을 소개하면서 미국, 중국에 이어 세계 세번째로 파운데이션 모델을 발표한 네이버를 포함시키지 않았고, 이에 논란이 된 바 있다.

'하이퍼클로바'의 820억개 파라미터에 대해 네이버클라우드 고위 관계자는 "2021년 발표한 논문에 82B라고 밝혔는데 이 부분이 반영된 듯 하다"고 설명했다. 네이버보다 앞서 2020년 6월 공개된 오픈AI '챗GPT'는 파라미터 수가 1750억개였다. 네이버가 작년 8월 발표한 '하이퍼클로바X'의 파라미터는 이번 '에코시스템 그래프'에도 비공개(unknown)로 명기됐다.

파라미터는 사용자가 원하는 방식으로 자료를 처리하기 위해 명령어 입력시 추가하거나 변경하는 수치 정보를 말한다. AI모델의 성능과 직접적으로 연관돼 있다. 파라미터가 크면 그만큼 메모리 용량이 커지고 성능도 좋아진다. 파라미터 하나는 보통 2바이트이므로 AI모델에 필요한 메모리는 파라미터 수 곱하기 2를 하면 된다. 예컨대 파라미터가 70억개인 모델은 GPU가 14GB 정도 메모리를 필요로 한다.

관련기사

- 네이버클라우드 "수학 '하이퍼클로바X'로 배우세요"2024.05.29

- "하이퍼클로바X, 어떻게 활용할까"…네이버클라우드, 세미나 통해 '해법' 제시2024.05.13

- 박윤영 KT 차기 대표 과제는2025.12.16

- '국정 생중계' 시대, 언론은 어떻게 보도해야 할까2025.12.16

네이버의 '하이퍼클로바X'는 거대언어모델(LLM) 기반 생성AI다. 한국어와 한국 문화를 집중 학습해 글로벌 LLM과 차별화했다. 지난 4월 네이버는 '하이퍼클로바X'가 글로벌 기업과의 LLM(거대언어모델) 비교 평가에서 더 높은 점수를 받았다고 밝힌 바 있다.

당시 네이버는 학습 방법이나 성능 등 AI 모델의 세부 정보를 소개하는 논문인 테크니컬 리포트를 인용해 "하이퍼클로바X가 한국어, 일반상식, 수학, 코딩 부문에서 비교 평가를 위해 선정한 14개 모델 중 1위를 기록했다"고 소개했다.