중국에서 인물의 사진만 있으면 말하는 영상을 얻을 수 있는 인공지능(AI) 기술이 공개됐다.

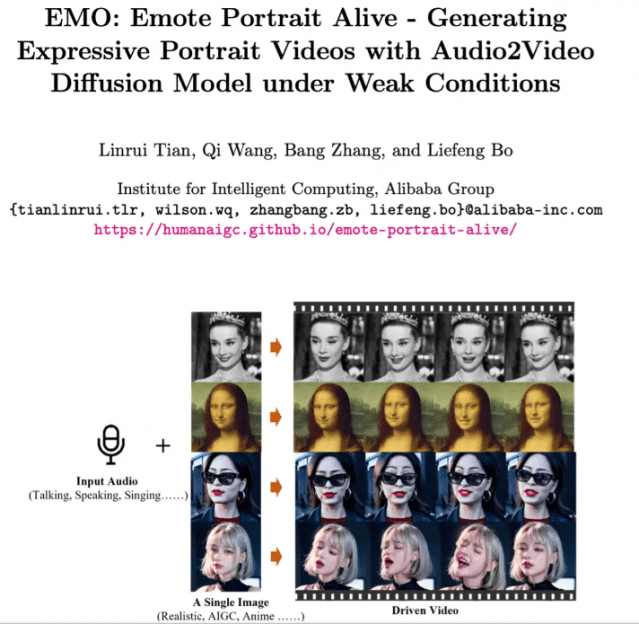

3일 중국 알리바바그룹의 연구진이 '립싱크'에 사용할 수 있는 EMO(Emote Portrait Alive) 프레임워크를 발표했다. 인물 사진과 오디오만 입력하면 사진 속 인물이 중국어, 영어, 한국어 등을 말하는 영상을 구현할 수 있다.

EMO는 엔비디아의 오디오2비디오(Audio2Video) 확산 모델을 기반으로 만들어졌다. 연구진은 이 AI 프레임워크를 얻기 위한 훈련에 250시간 이상의 전문 영상을 사용했다고 설명했다.

연구진은 EMO 프레임워크에서 생성된 몇 편의 데모 영상을 공개했다.

보고서에 따르면 이 프레임워크의 작동 과정은 두 단계로 나뉜다. 먼저 참조 네트워크(ReferenceNet)를 사용해 참조 이미지와 동작 프레임에서 특징을 추출한 이후, 사전 훈련된 오디오 인코더를 사용해 사운드를 처리하고 삽입한다. 이후 다중 프레임 노이즈와 얼굴 영역 마스크를 결합해 영상을 생성한다.

관련기사

- 기술 고도화 나선 韓 기업, 글로벌 AI 생태계서 생존 가능?2024.03.03

- 오픈AI에 '뿔난' 일론 머스크, 샘 알트먼과 법적 분쟁 벌인다2024.03.02

- AI, 우주 등 국방전략기술 조기 확보에 ‘올인’2024.03.01

- 올해 AI 대약진..."네이버·카카오 개인정보 유출 방지 정조준"2024.03.01

이 프레임워크에는 두 가지의 어텐션메커니즘(Attention Mechanism)과 시간 모듈이 결합돼 있어 영상에서 캐릭터 정체성의 일관성과 자연스러운 동작을 보장한다.

연구진은 모델의 작동 원리를 아시브(ArXiv)에 게시했다. 관심이 있는 사람은 깃허브에 방문해 프로젝트를 확인할 수 있다. 아시브는 출판되기 전 논문이 저장되는 무료 웹사이트다.