인텔리콘연구소(대표 임영익)는 국내 최초로 한국 법률에 특화한 언어모델(sLLM) '코알라(KOALLA, Korean Adaptive Legal Language AI)' 개발에 성공했다고 23일 밝혔다.

이번에 개발한 '코알라1.0'은 리걸테크의 다양한 응용 서비스에 적용이 가능하다. 기업이나 로펌의 대용량 문서 기반 생성AI(RAG) 시스템에도 장착할 수 있다. 이에, 기업의 다양한 환경과 요구에 부응하는 온-프레미스(On-Premise, 서버 구축형)나 설치형(Appliance) 방식 법률특화 생성AI 도입이 가능해진다.

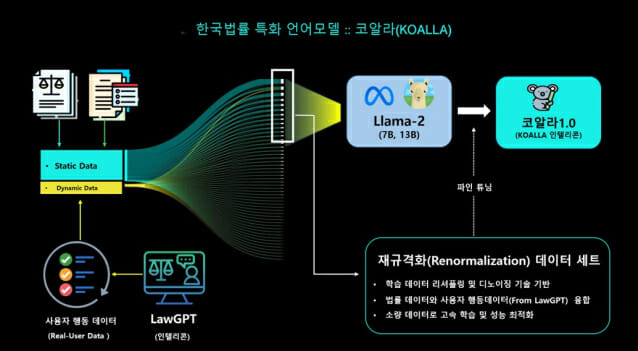

'코알라'는 메타의 오픈소스 AI모델인 '라마2(Llama-2)'의 7B(70억 파라미터),13B(130억 파라미터)모델을 파인튜닝(Fine-Tuning)해 개발했다. 특히 인텔리콘은 '코알라' 성능을 높이기 위해 널리 알려진 'DPO(Direct Preference Optimization)'같은 기법 외에 학습 데이터 구성 자체를 최적화하는 '데이터 재규격화(Renormalization)' 기술을 자체 개발해 추가 학습에 사용했다. 수 백만개의 법률, 판례, 상담자료, 주석자료 등을 기반으로 학습 데이터 규격화 작업을 먼저 한 후, 성능향상에 도움이 되는 데이터만을 선별해 재규격화했다.

데이터 '재규격화' 기법은 인텔리콘이 자체로 고안한 특허 기술이다. 방대한 학습 데이터에서 성능향상에 불필요한 데이터를 제거하는 '데이터 디노이징(Data-denoizing)' 기법과 실제 사용자의 행동 패턴 데이터를 융합하는 '리셔플링(Re-shuffling)' 기술을 포함했다. 또 사용자 데이터는 살아 움직이는 데이터(Dynamic Data)로 인텔리콘이 지난해 5월 개발한 법률GPT(LawGPT)와 '도큐브레인(DocuBrain)'을 통해 얻은 자료들이다.

GPT같은 거대언어모델(LLM)은 거짓 답변을 만들어 내는 환각현상(Hallucination)때문에 법률, 의료 등에 직접 사용하면 위험하다. 이런 문제를 해결하기 위해 근거기반 생성AI(RAG)가 인기를 모으고 있다. 최근에는 경량화 거대언어모델(sLLM)을 기반으로 수천개에서 수만개의 데이터만으로 파인 튜닝을 해 독자모델을 완성하는 방향으로 생성AI 생태계가 조성되고 있는 상황이다.

관련기사

- 인텔리콘연구소, 2023 서울국제발명전시회 2관왕 영예2023.11.07

- [AI는 지금] 'AI 거품론'에도 내 갈 길 간다…소프트뱅크·오픈AI, 투자 확대 '승부수'2025.11.21

- 국정자원 복구는 두 달, 민간은 몇 시간…왜 차이 날까2025.11.22

- 엔씨, 아이온2 두 번째 긴급 라이브…"어비스 포인트 격차 즉시 완화"2025.11.21

업계는 어떤 질문에도 응답하는 만능 거대언어모델보다는 자신 만의 내부 데이터를 기반으로 정교한 답을 생성하는 RAG방식이나 특화한 언어모델을 선호한다. 미국의 거대언어모델 API를 이용하는 대신 한국 법률에 특화한 거대언어모델을 직접 적용하는 것은 문서 보안 문제 등을 해결하면서 국내 리걸테크 산업에 큰 변화를 줄 전망이다.

임영익 인텔리콘 대표는 "자체 모델을 개발하면서 깨달은 것이 있다. 모델 성능의 본질은 모델 자체가 아니라 데이터에 있다는 결론을 내렸다. 아무리 모델을 잘 선택해 다양한 기법을 동원해도 미국의 GPT-4 성능에 근접하는 것은 무리다. 가성비도 좋지 않다"면서 "우리는 모델 뿐 아니라 학습 데이터 구조 자체에 좀 더 집중하는 연구를 하면서 데이터 재규격화 기법을 고안했다. 소량 데이터로 성능을 극대화할 수 있다는 것을 확인했다"고 밝혔다. 이어 "앞으로 라마2 외에 다른 모델도 활용해 '코알라2.0' 개발 및 고도화를 진행할 예정이며, 다양한 코알라를 만든 후 경량모델 블랜딩(Blending) 기술을 적용해 거대언어모델에 근접하는 ‘앙상블 브레인’을 개발할 계획"이라고 덧붙였다.