오픈AI, 메타, 구글을 비롯한 빅테크 거대언어모델(LLM)의 투명성 지수가 낮은 것으로 조사됐다.

미국 월간지 IEEE 스펙트럼은 미국 스탠퍼드대 기초모델연구센터(CRFM)가 빅테크 LLM 투명성을 조사한 결과를 22일(현지시간) 보도했다. 연구팀은 현재 사용되고 있는 것 중 가장 큰 범용 모델 10개를 선정해 신뢰성 등급을 매겼다. CRFM이 자체적으로 설정한 100가지 지표를 기준으로 평가했다. 지표는 매개변수, 훈련 방식, 데이터 공개 여부, 설명가능성 등으로 이뤄졌다.

연구팀은 공개적으로 사용 가능한 모델 데이터를 검색했다. 모델을 각 지표에 따라 평가한 후 종합 점수를 냈다. 그후 LLM 개발사에 연락해 종합 점수에 이의를 제기할 의향 있는지 확인했다. 연구팀 설명에 따르면 이의 제기 요청을 한 기업은 없었다.

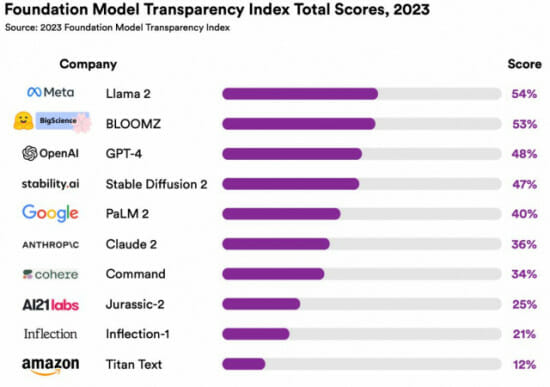

조사 결과에 따르면 10개 모델 중 메타의 라마 2가 100점 만점에서 54점으로 가장 높은 투명성 점수를 받았다. 허깅페이스의 블룸즈, 오픈AI GPT-4가 각각 53점, 48점으로 뒤를 이었다. 10개 모델 평균 점수는 32점이다.

연구팀은 오픈소스형 모델이 폐쇄형 모델보다 더 높은 투명성 점수를 기록한 것으로 평가했다. 오픈소스형 모델은 메타의 라마 2, 허깅페이스의 블룸즈, 스테빌리티AI의 스테이블 디퓨전이다. 특히 허깅페이스 블롬즈는 특정 지표에서 100점을 기록하기도 했다. 반면 오픈AI의 GPT-4 같은 폐쇄형 모델은 특정 분야에서 0점을 받았다.

스탠퍼드 CRFM 연구 조교이자 케빈 클라이먼 박사는 "LLM에 들어가는 데이터, 기능 평가, 출시 후 훈련 방식에 대해서 투명한 운영 방식을 유지해야 한다"고 강조했다. 그는 "기업은 LLM을 공개할 때만 투명성을 강조하고, 그 후 폐쇄적인 행보를 보인다"고 지적하기도 했다.

관련기사

- 美 유니버설 뮤직 "챗봇 클로드, 가사 도용" 고소2023.10.20

- "AI 모델 미세조정, 유해 답변·탈옥 확률 높여"2023.10.17

- "정부, AI 개발보다 데이터 품질 개선 먼저"2023.10.16

- "검색 엔진에 생성 AI 결합하면 에너지 소비 10배↑"2023.10.11

그는 모델 영향력이 커질수록 투명성은 낮아진다고 설명했다. 클라이먼 박사는 오픈AI를 예로 들었다. 그는 "오픈AI는 GPT-3 버전을 GPT-4로 업그레이드할 때 매개변수를 비롯한 하드웨어 시스템, 컴퓨팅 규모, 데이터셋, 훈련 방법에 대한 모든 정보를 비공개로 돌렸다"며 "누구도 GPT-4가 얼마나 알고리즘 신뢰성을 지키고 있는지 정확히 알지 못한다"고 했다.

최근 AI 기업이 저작권 있는 원본 자료를 모델 데이터셋에 무단으로 사용했다는 점에서 비난받고 있다. 이와 관련된 소송도 여러 건 제기됐다. 이에 따라 일각에선 LLM 학습 데이터 출처 중요성이 커졌다. 반면 오픈AI 등 빅테크는 LLM에 들어 있는 데이터를 보안상의 이유로 공개하지 않는다. CRFM 연구팀 리시 봄마사니 박사는 "현재 빅테크 언어모델 투명성은 낙제점 수준"이라며 "LLM에 투명성을 특별히 신경 쓰는 빅테크는 없다"고 지적했다.