매사추세츠공과대학(MIT) 연구팀이 생성 인공지능(AI)의 이미지 합성 기능을 방지하는 기술을 공개했다.

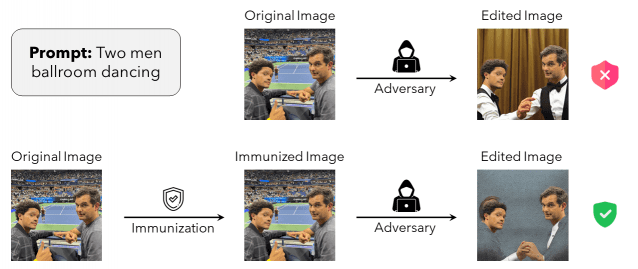

31일(현지시간) MIT뉴스 등 보도에 따르면 MIT 컴퓨터과학·인공지능연구소(CSAIL) 연구팀이 무단 이미지 조작을 방지하는 포토가드 기술을 공개했다.

연구원이 발표한 연구논문에 따르면 포토가드는 인코더 공격과 확산 두가지 방식으로 생성AI의 합성을 원천적으로 방해하거나 합성 이미지를 쉽게 감지할 수 있도록 지원한다.

인코더 공격은 이미지에 사람 눈으로는 판단할 수 없는 미세한 불규칙성이 반복해서 발생하게 만든다. 이를 통해 생성AI가 이미지를 제대로 학습하지 못해 원하는 결과물이 나오지 못하도록 방지한다

관련기사

- "생성AI 산업화, 비즈니스 플랫폼으로 지원"2023.07.28

- 메가존클라우드-키토크AI, 생성AI 프롬프트 최적화 개발2023.07.26

- 생성AI, 사이버공격 증가 핵심요인 급부상2023.07.25

- "급변하는 AI시대, 범국가 개인정보 보호체계 필수"2023.06.24

확산은 AI모델이 이미지를 생성할 때 사람의 눈으로 알아채지 못할 수준의 미세한 변화를 만들어 합성임을 확인할 수 있도록 만드는 기술이다. 이 방법은 이미지 합성 과정에서 파악할 수 없어 배포 후에도 사실 확인을 명확히 할 수 있다.

논문의 주 저자인 하디 살만은 "포토가드는 아직 모든 이미지를 보호할 수 없다. 악의적인 의도를 가진 개인이 이미지를 편집하거나 리버스 엔지니어링을 시도할 수도 있다"며 "이 기술이 효과적이기 위해서는 정책 입안자는 이미지 조작으로부터 사용자 데이터를 보호하도록 의무화하는 규정을 마련하는 것을 고려하는 등 이해 관계자의 통합된 대응이 필요하다"고 말했다.